Utilice modelos de base propietarios de Amazon SageMaker JumpStart en Amazon SageMaker Studio.

Use proprietary base models from Amazon SageMaker JumpStart in Amazon SageMaker Studio.

Amazon SageMaker JumpStart es un centro de aprendizaje automático (ML) que puede ayudarlo a acelerar su viaje de ML. Con SageMaker JumpStart, puede descubrir e implementar modelos de base públicos y propietarios en instancias de Amazon SageMaker dedicadas para sus aplicaciones de inteligencia artificial generativa. SageMaker JumpStart le permite implementar modelos de base desde un entorno aislado de la red y no comparte los datos de entrenamiento e inferencia del cliente con los proveedores de modelos.

En esta publicación, explicaremos cómo comenzar con modelos propietarios de proveedores de modelos como AI21, Cohere y LightOn desde Amazon SageMaker Studio. SageMaker Studio es un entorno de cuaderno donde los clientes de SageMaker Data Scientist evalúan y construyen modelos para sus próximas aplicaciones de inteligencia artificial generativa.

Modelos de base en SageMaker

Los modelos de base son modelos de ML a gran escala que contienen miles de millones de parámetros y están preentrenados en terabytes de datos de texto e imagen para que pueda realizar una amplia gama de tareas, como la resumen de artículos y la generación de texto, imagen o video. Debido a que los modelos de base están preentrenados, pueden ayudar a reducir los costos de capacitación e infraestructura y permitir la personalización para su caso de uso.

SageMaker JumpStart proporciona dos tipos de modelos de base:

- Cómo Earth.com y Provectus implementaron su infraestructura de MLOps con Amazon SageMaker.

- La IA puede algún día realizar milagros médicos. Por ahora, ayuda a realizar trabajos administrativos.

- Tecnología de IA para Revolucionar la Atención al Paciente

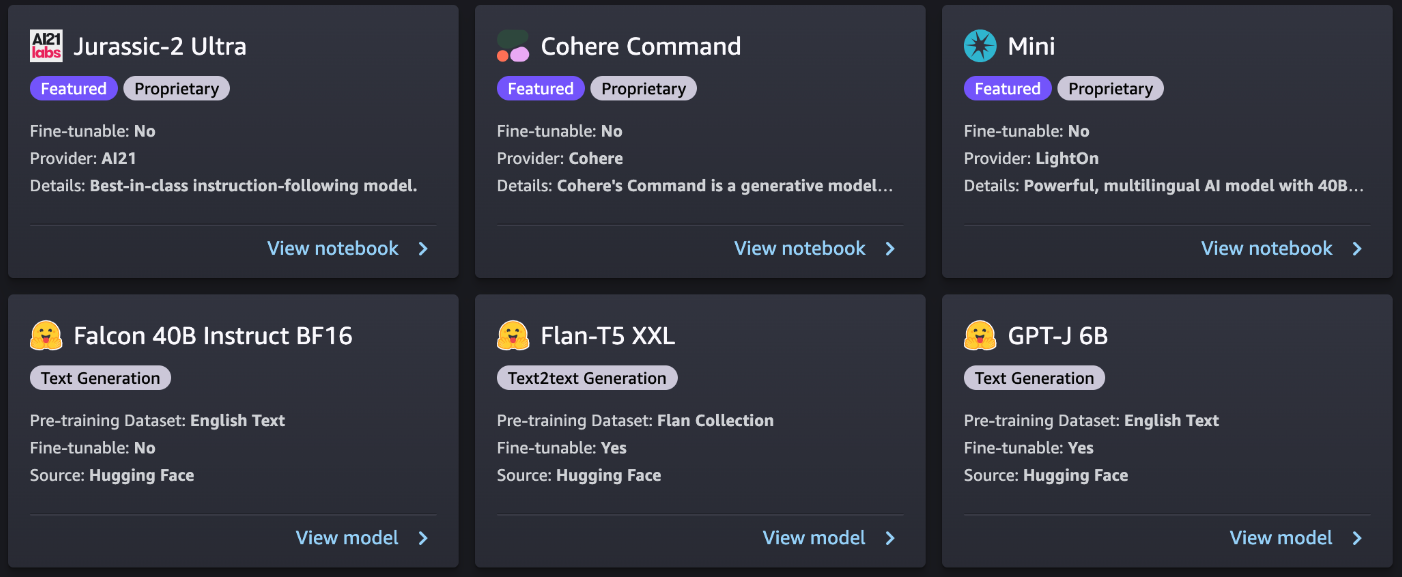

- Modelos propietarios – Estos modelos son de proveedores como AI21 con modelos Jurassic-2, Cohere con Cohere Command y LightOn con Mini entrenados en algoritmos y datos propietarios. No puede ver artefactos de modelos como peso y scripts, pero aún puede implementarlos en instancias de SageMaker para inferencia.

- Modelos públicamente disponibles – Estos son de centros de modelos populares como Hugging Face con Stable Diffusion, Falcon y FLAN entrenados en algoritmos y datos disponibles públicamente. Para estos modelos, los usuarios tienen acceso a los artefactos del modelo y pueden ajustarlos con sus propios datos antes de la implementación para inferencia.

Descubrir modelos

Puede acceder a los modelos de base a través de SageMaker JumpStart en la interfaz de usuario de SageMaker Studio y el SDK de Python de SageMaker. En esta sección, explicamos cómo descubrir los modelos en la interfaz de usuario de SageMaker Studio.

SageMaker Studio es un entorno de desarrollo integrado (IDE) basado en la web para ML que le permite construir, capacitar, depurar, implementar y monitorear sus modelos de ML. Para obtener más detalles sobre cómo comenzar y configurar SageMaker Studio, consulte Amazon SageMaker Studio.

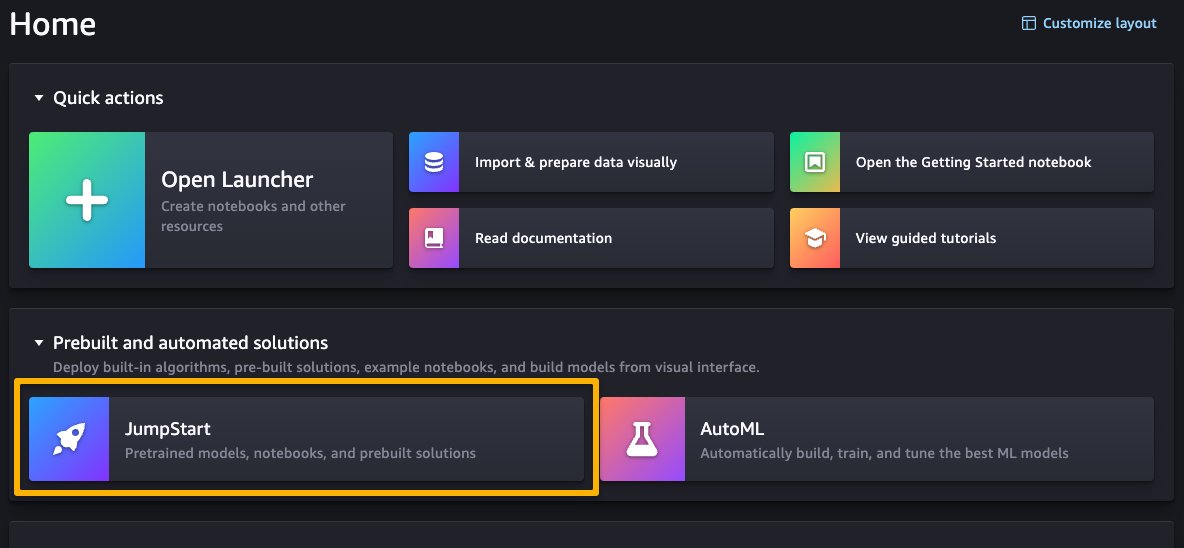

Una vez que esté en la interfaz de usuario de SageMaker Studio, puede acceder a SageMaker JumpStart, que contiene modelos preentrenados, cuadernos y soluciones preconstruidas, en Soluciones preconstruidas y automatizadas.

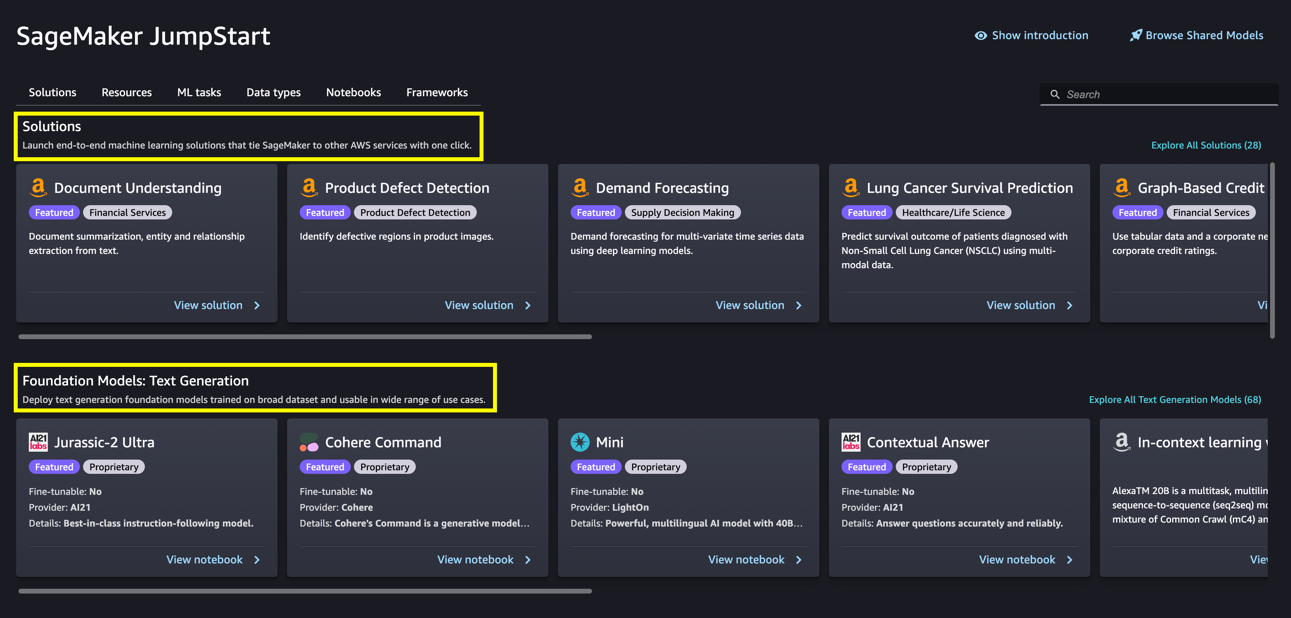

Desde la página principal de SageMaker JumpStart, puede buscar soluciones, modelos, cuadernos y otros recursos. La siguiente captura de pantalla muestra un ejemplo de la página principal con soluciones y modelos de base listados.

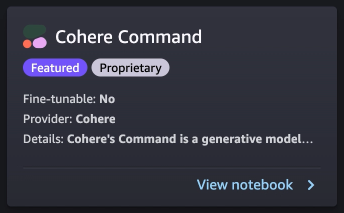

Cada modelo tiene una tarjeta de modelo, como se muestra en la siguiente captura de pantalla, que contiene el nombre del modelo, si es ajustable o no, el nombre del proveedor y una breve descripción sobre el modelo. También puede abrir la tarjeta del modelo para obtener más información sobre el modelo y comenzar a entrenar o implementar.

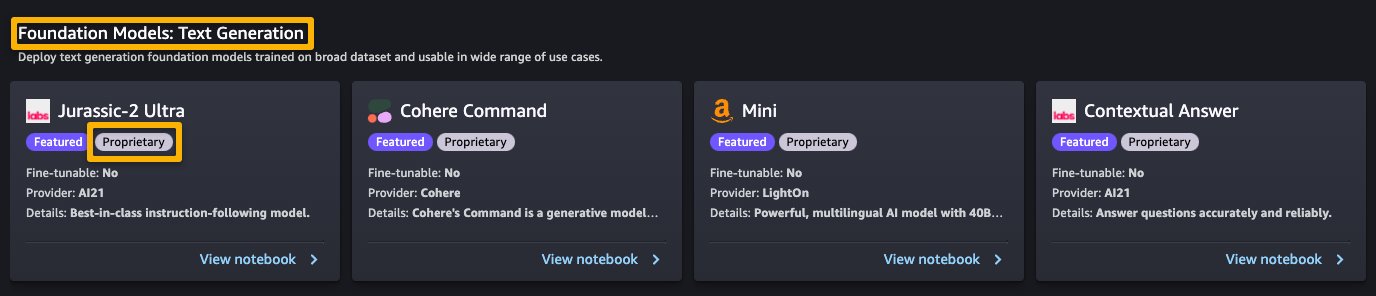

Suscribirse en AWS Marketplace

Los modelos propietarios en SageMaker JumpStart son publicados por proveedores de modelos como AI21, Cohere y LightOn. Puede identificar modelos propietarios por la etiqueta “Propietario” en las tarjetas de modelo, como se muestra en la siguiente captura de pantalla.

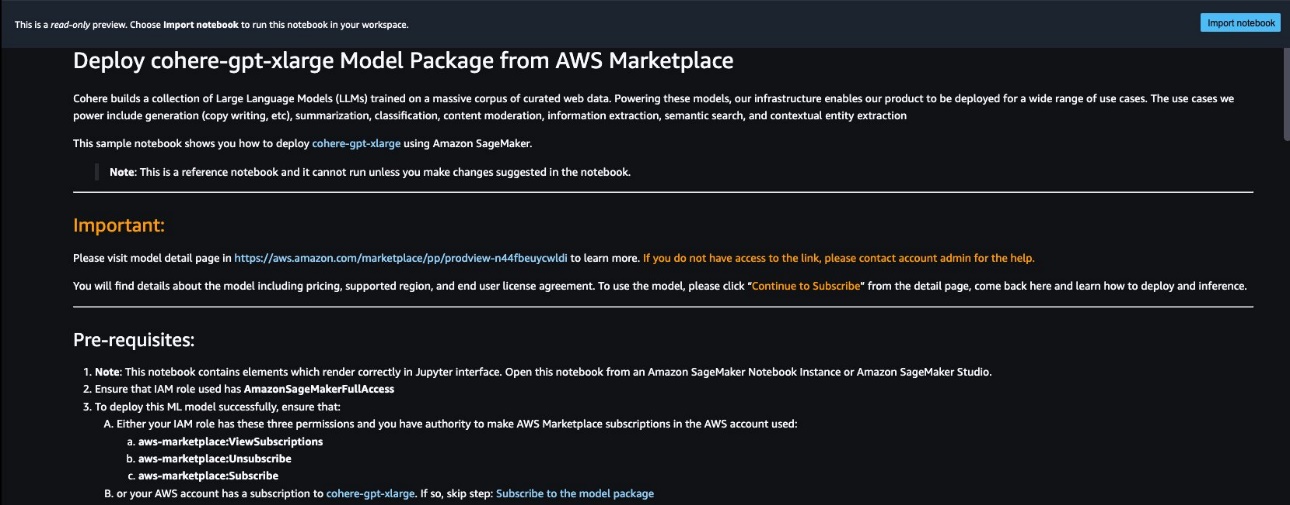

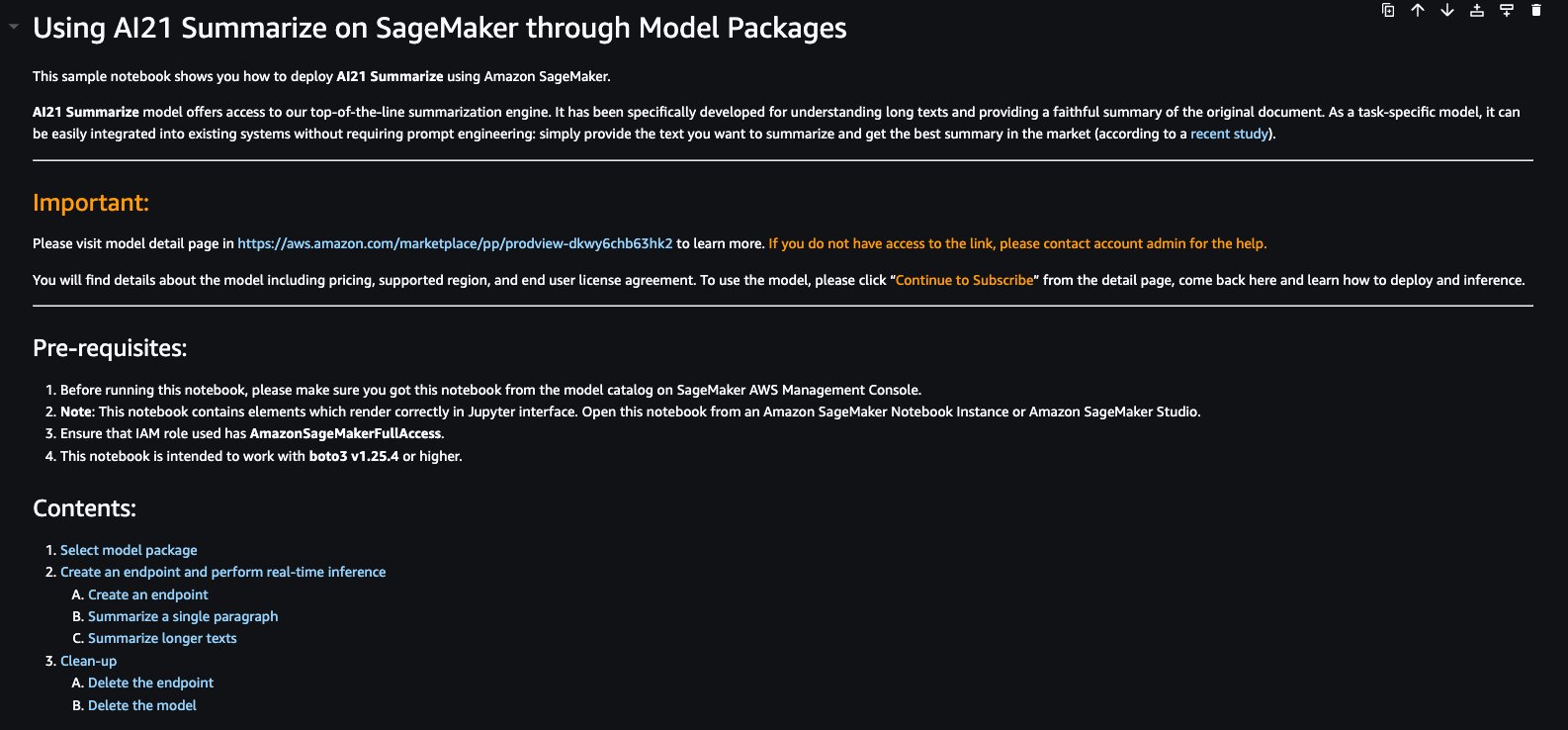

Puede elegir Ver cuaderno en la tarjeta del modelo para abrir el cuaderno en modo de solo lectura, como se muestra en la siguiente captura de pantalla. Puede leer el cuaderno para obtener información importante sobre requisitos previos y otras instrucciones de uso.

Después de importar el cuaderno, debe seleccionar el entorno de cuaderno apropiado (imagen, kernel, tipo de instancia, etc.) antes de ejecutar los códigos. También debe seguir las instrucciones de suscripción y uso según el cuaderno seleccionado.

Antes de usar un modelo propietario, primero debe suscribirse al modelo en AWS Marketplace:

- Abra la página de listado del modelo en AWS Marketplace.

La URL se proporciona en la sección Importante del cuaderno, o puede acceder a ella desde la página de servicio SageMaker JumpStart. La página de listado muestra la descripción general, precios, uso e información de soporte sobre el modelo.

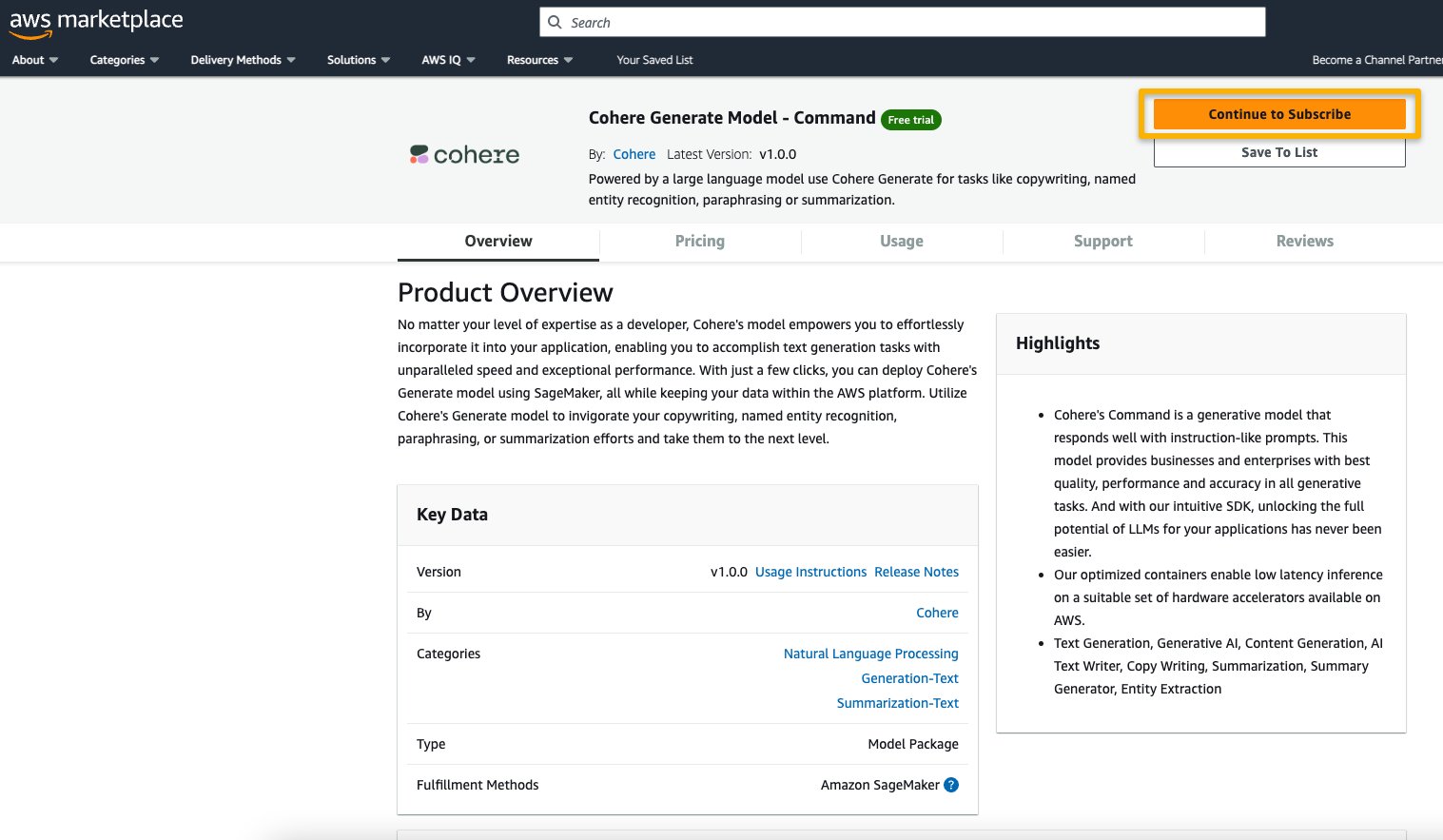

- En el listado de AWS Marketplace, elija Continuar para suscribirse.

Si no tiene los permisos necesarios para ver o suscribirse al modelo, comuníquese con su administrador de TI o punto de contacto de adquisiciones para que se suscriba al modelo por usted. Muchas empresas pueden limitar los permisos de AWS Marketplace para controlar las acciones que alguien con esos permisos puede realizar en el Portal de administración de AWS Marketplace.

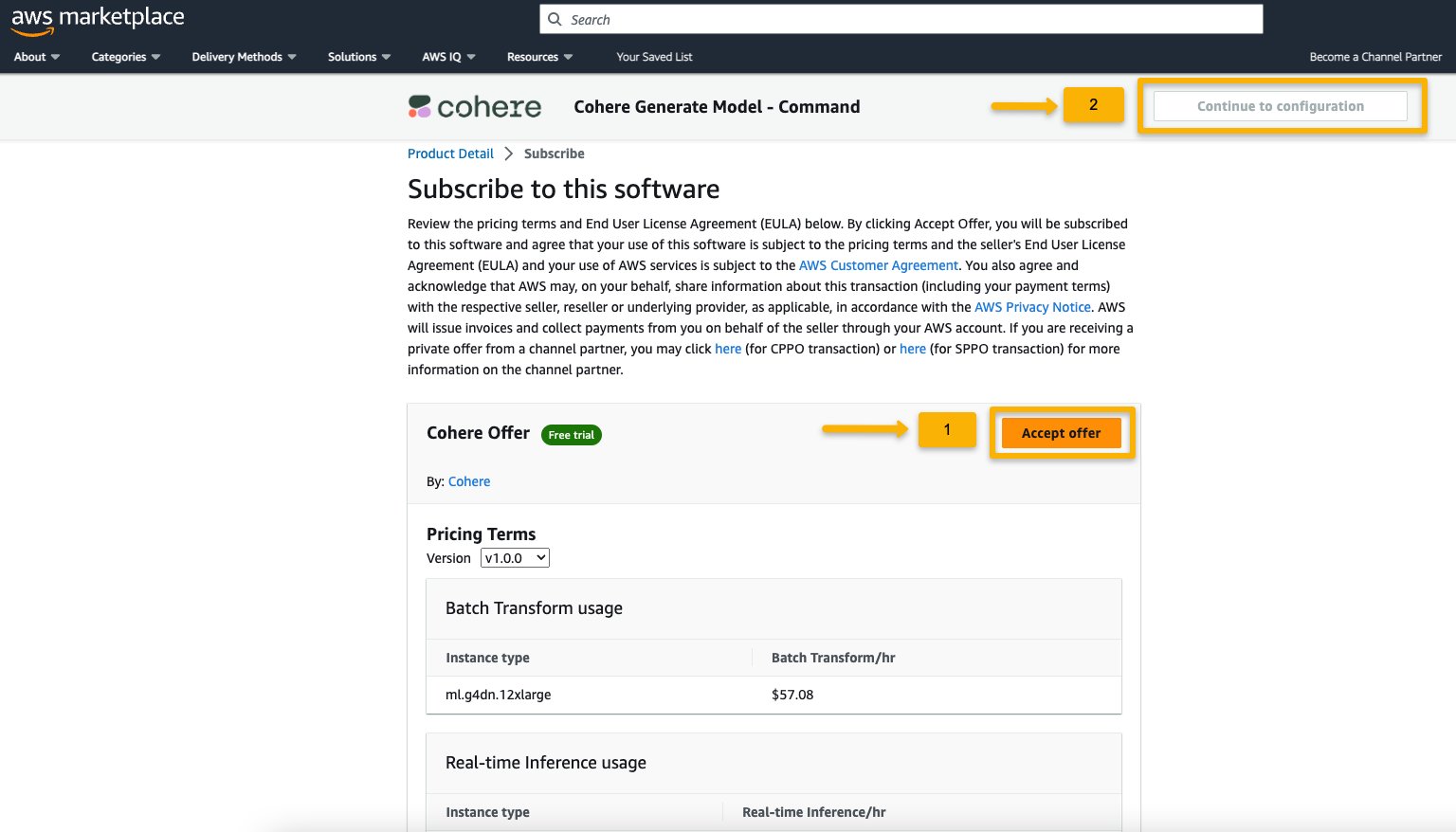

- En la página Suscribirse a este software, revise los detalles y elija Aceptar oferta si usted y su organización están de acuerdo con los términos de la EULA, los precios y el soporte.

Si tiene alguna pregunta o solicitud de descuento por volumen, comuníquese directamente con el proveedor del modelo a través del correo electrónico de soporte proporcionado en la página de detalles o comuníquese con su equipo de cuenta de AWS.

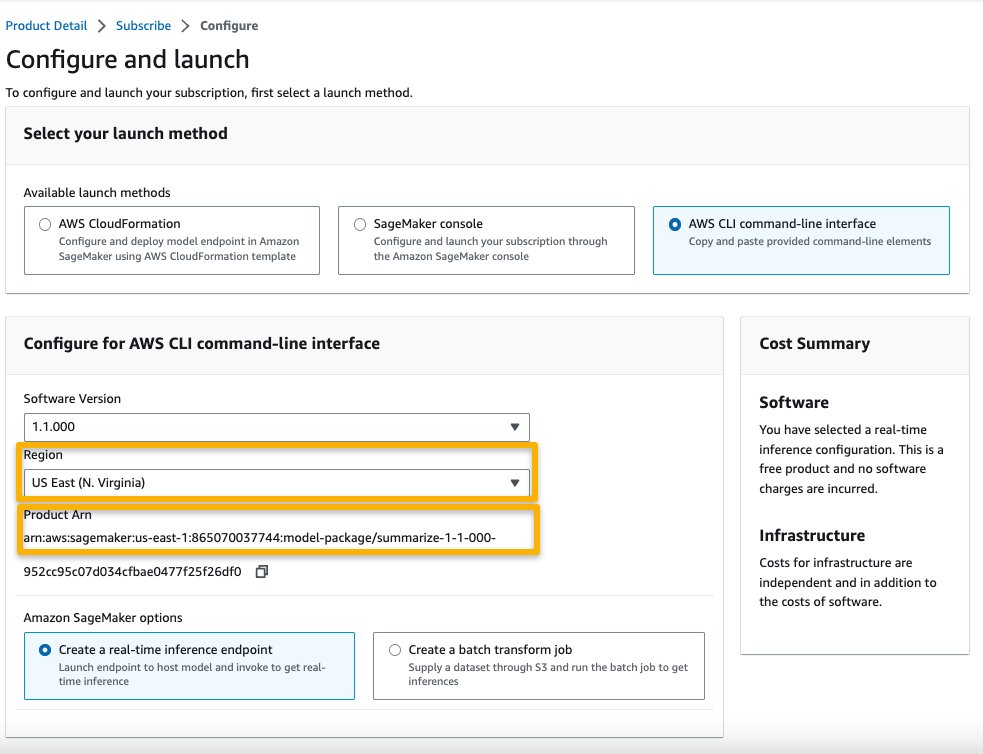

- Elija Continuar a la configuración y elija una región.

Verá un ARN de producto que se muestra. Este es el ARN del paquete de modelo que necesita especificar al crear un modelo implementable usando Boto3.

- Copie el ARN correspondiente a su región y especifíquelo en las instrucciones de la celda del cuaderno.

Inferencia de muestra con indicaciones de muestra

Veamos algunos de los modelos fundamentales de muestra de A21 Labs, Cohere y LightOn que se pueden descubrir desde SageMaker JumpStart en SageMaker Studio. Todos ellos tienen las mismas instrucciones para suscribirse desde AWS Marketplace e importar y configurar el cuaderno.

AI21 Resumen

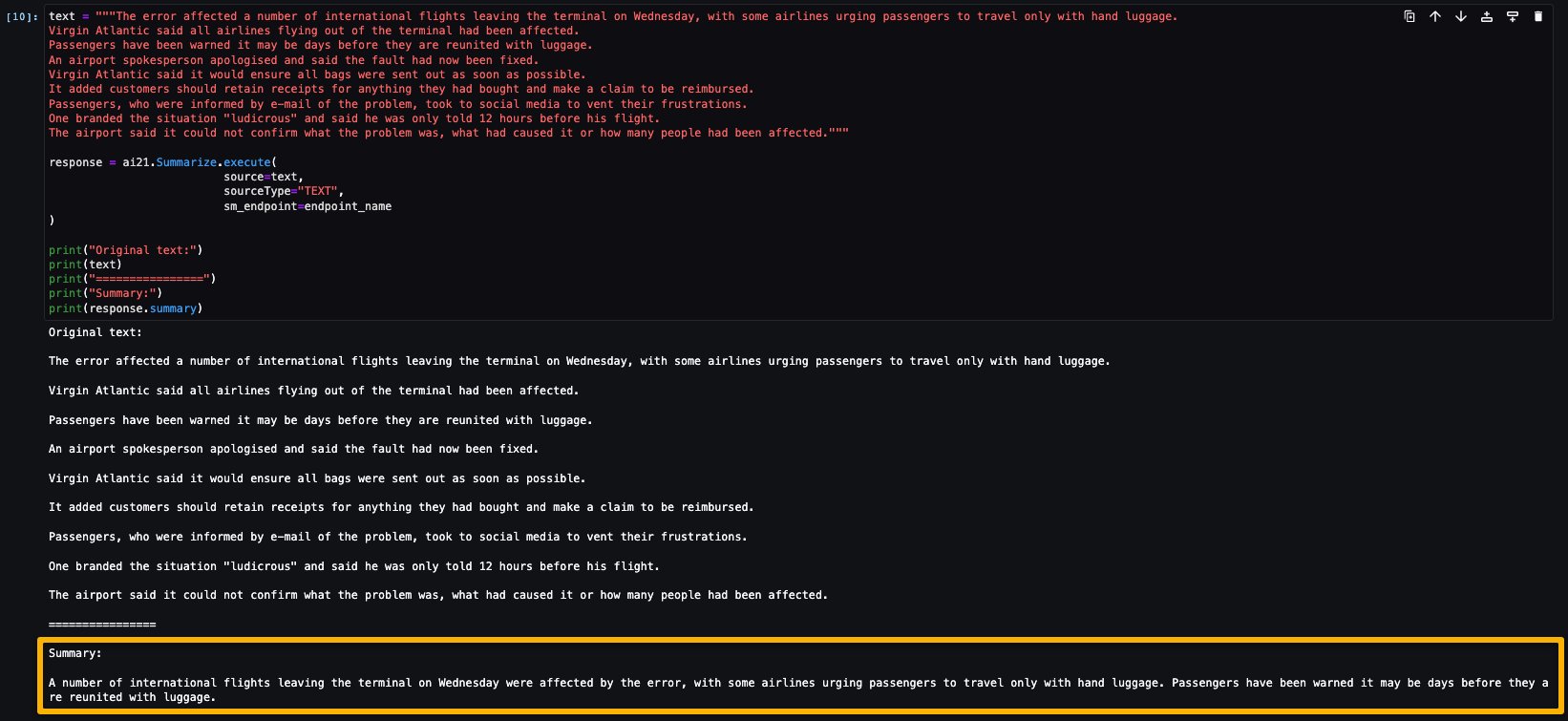

El modelo Resumen de A121 Labs condensa textos extensos en fragmentos cortos y fáciles de leer que siguen siendo consistentes con la fuente en términos de hecho. El modelo está entrenado para generar resúmenes que capturan ideas clave basadas en un cuerpo de texto. No requiere ninguna indicación. Simplemente ingrese el texto que necesita resumir. Su texto de origen puede contener hasta 50,000 caracteres, lo que equivale a aproximadamente 10,000 palabras o impresionantes 40 páginas.

El cuaderno de muestra para el modelo AI21 Resumen proporciona importantes requisitos previos que deben seguirse. Por ejemplo, el modelo se suscribe desde AWS Marketplace, tiene permisos de roles de IAM apropiados, y la versión de boto3 requerida, etc. Le guía a través de cómo seleccionar el paquete de modelo, crear puntos finales para inferencia en tiempo real y luego limpiar.

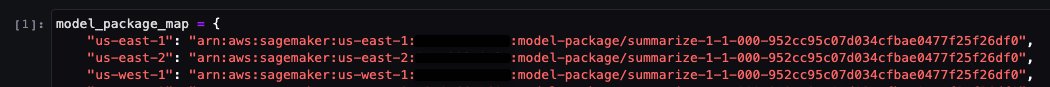

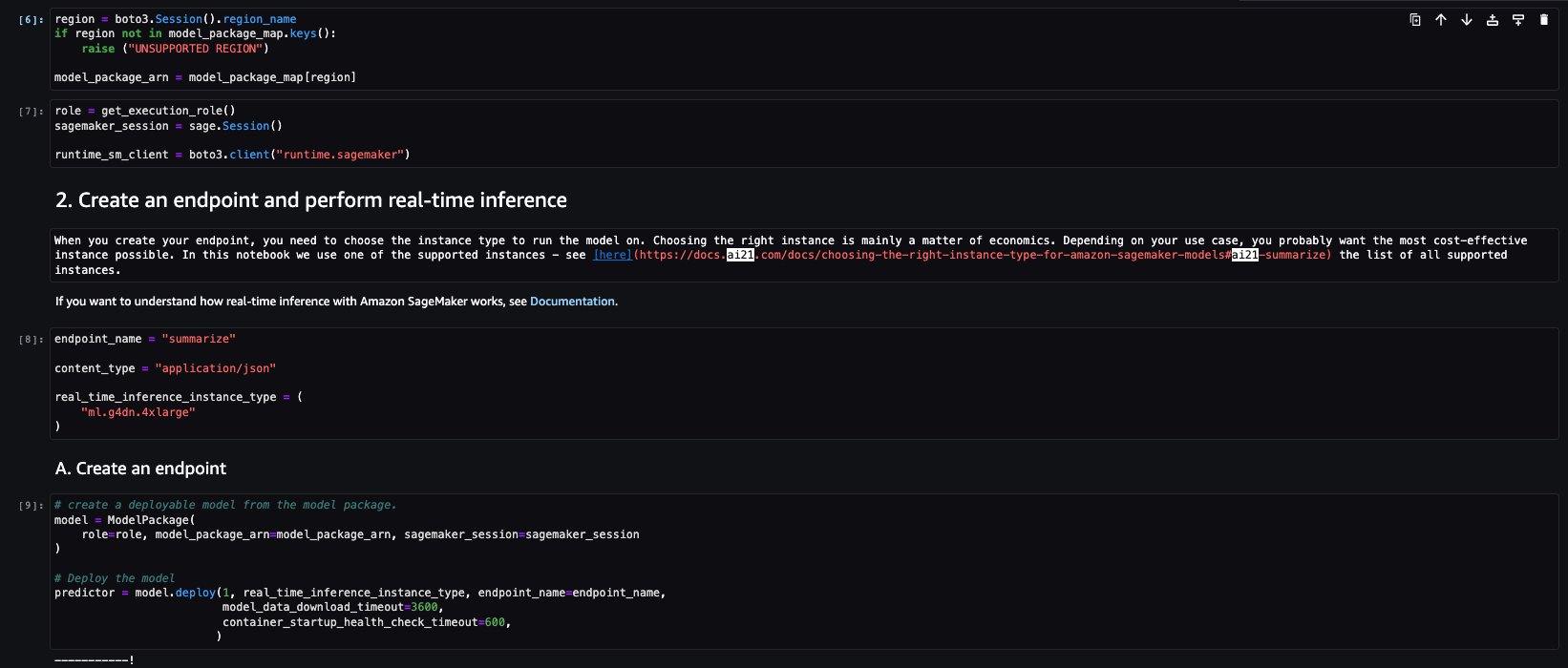

El paquete de modelo seleccionado contiene la asignación de ARN a regiones. Esta es la información que capturaste después de elegir Continuar con la configuración en la página de suscripción de AWS Marketplace (en la sección Evaluar y suscribir en el Marketplace) y luego seleccionar una región para la cual verás el ARN de producto correspondiente.

La libreta puede tener el ARN prellenado.

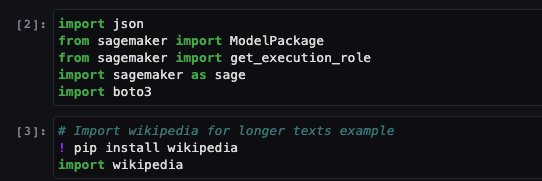

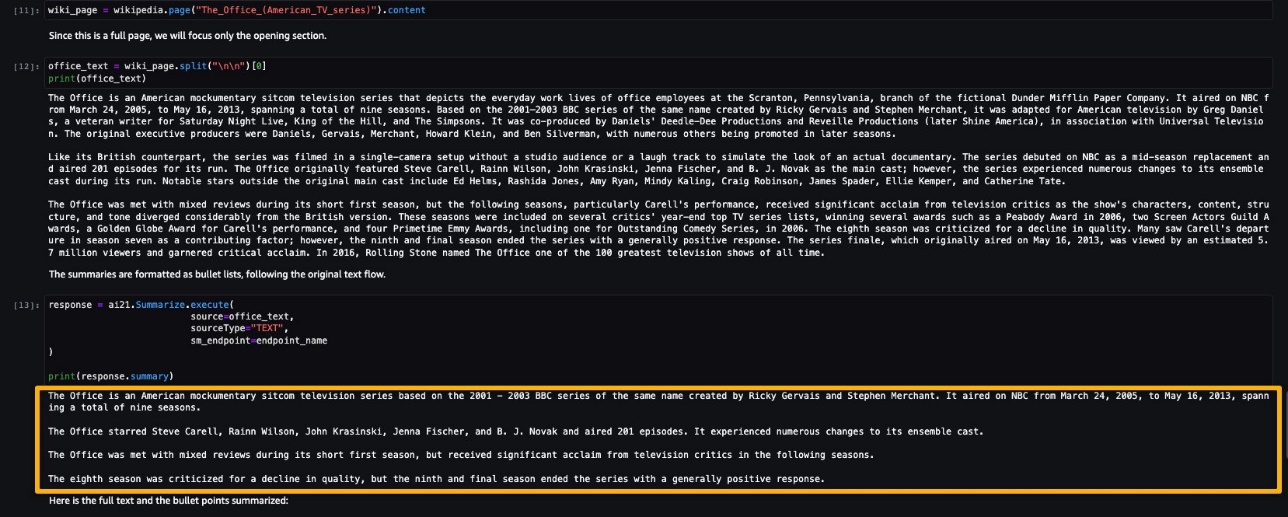

Luego importas algunas bibliotecas necesarias para ejecutar esta libreta e instalas wikipedia, que es una biblioteca de Python que facilita el acceso y análisis de datos de Wikipedia. La libreta lo utiliza más adelante para mostrar cómo resumir un texto largo de Wikipedia.

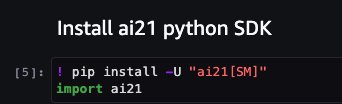

La libreta también procede a instalar el SDK de Python ai21, que es un envoltorio alrededor de las APIs de SageMaker, como deploy e invoke endpoint.

Las siguientes celdas de la libreta explican los siguientes pasos:

- Seleccionar la región y buscar el ARN del paquete de modelo en el mapa del paquete de modelo

- Crear tu punto de entrada de inferencia seleccionando un tipo de instancia (dependiendo de tu caso de uso e instancia compatible para el modelo, consulta Modelos específicos de la tarea para obtener más detalles) para ejecutar el modelo

- Crear un modelo desplegable a partir del paquete de modelo

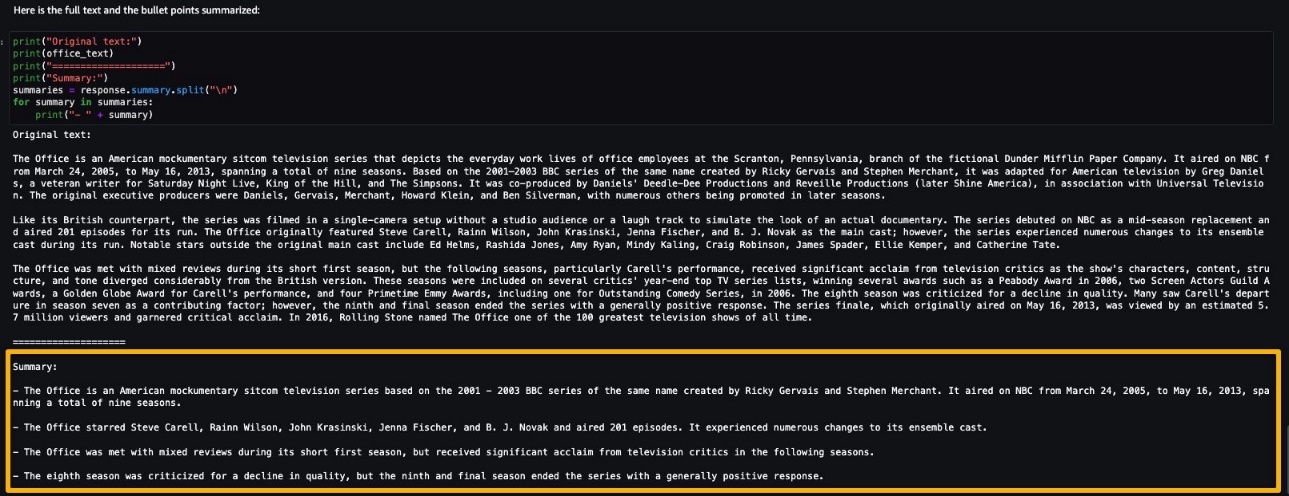

Ejecutemos la inferencia para generar un resumen de un solo párrafo tomado de un artículo de noticias. Como se puede ver en la salida, el texto resumido se presenta como una salida del modelo.

AI21 Summarize puede manejar entradas de hasta 50,000 caracteres. Esto se traduce en aproximadamente 10,000 palabras o 40 páginas. Como demostración del comportamiento del modelo, cargamos una página de Wikipedia.

Ahora que has realizado una inferencia en tiempo real para probar, es posible que no necesites el punto de entrada. Puedes eliminar el punto de entrada para evitar cargos.

Comando Cohere

El Comando Cohere es un modelo generativo que responde bien con instrucciones. Este modelo proporciona a las empresas y empresas la mejor calidad, rendimiento y precisión en todas las tareas generativas. Puedes usar el modelo de Comando de Cohere para impulsar tus esfuerzos de redacción, reconocimiento de entidades nombradas, parafraseo o resumen y llevarlos al siguiente nivel.

El cuaderno de muestra para el modelo de Comando de Cohere proporciona importantes requisitos previos que deben seguirse. Por ejemplo, el modelo está suscrito desde AWS Marketplace, tiene los permisos adecuados de roles de IAM y la versión requerida de boto3, entre otros. Lo guía a través de cómo seleccionar el paquete de modelos, crear puntos finales para inferencia en tiempo real y luego limpiarlos.

Algunas de las tareas son similares a las cubiertas en el ejemplo anterior del cuaderno, como instalar Boto3, instalar cohere-sagemaker (el paquete proporciona funcionalidad desarrollada para simplificar la interfaz con el modelo de Cohere) y obtener la sesión y la región.

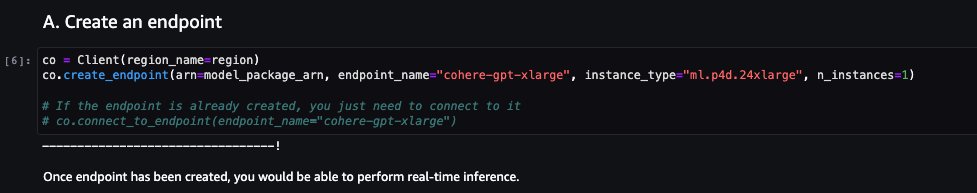

Exploramos la creación del punto final. Proporcione el ARN del paquete de modelos, el nombre del punto final, el tipo de instancia a utilizar y el número de instancias. Una vez creado, el punto final aparece en su sección de puntos finales de SageMaker.

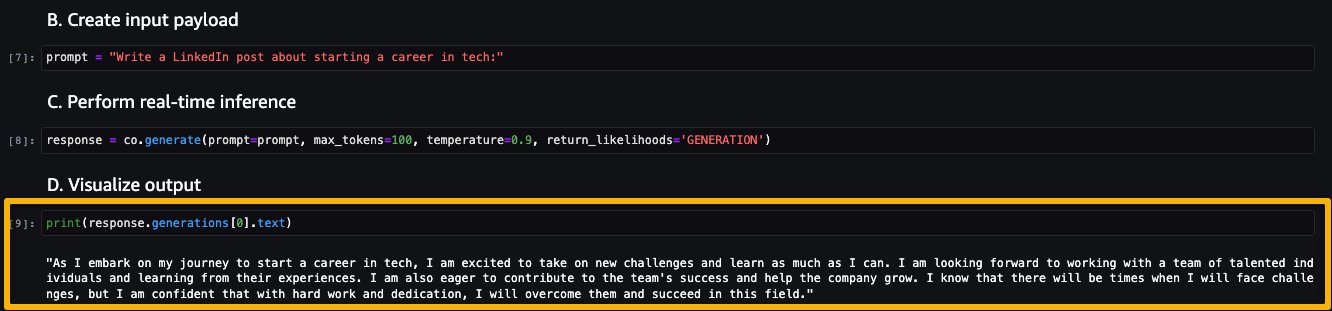

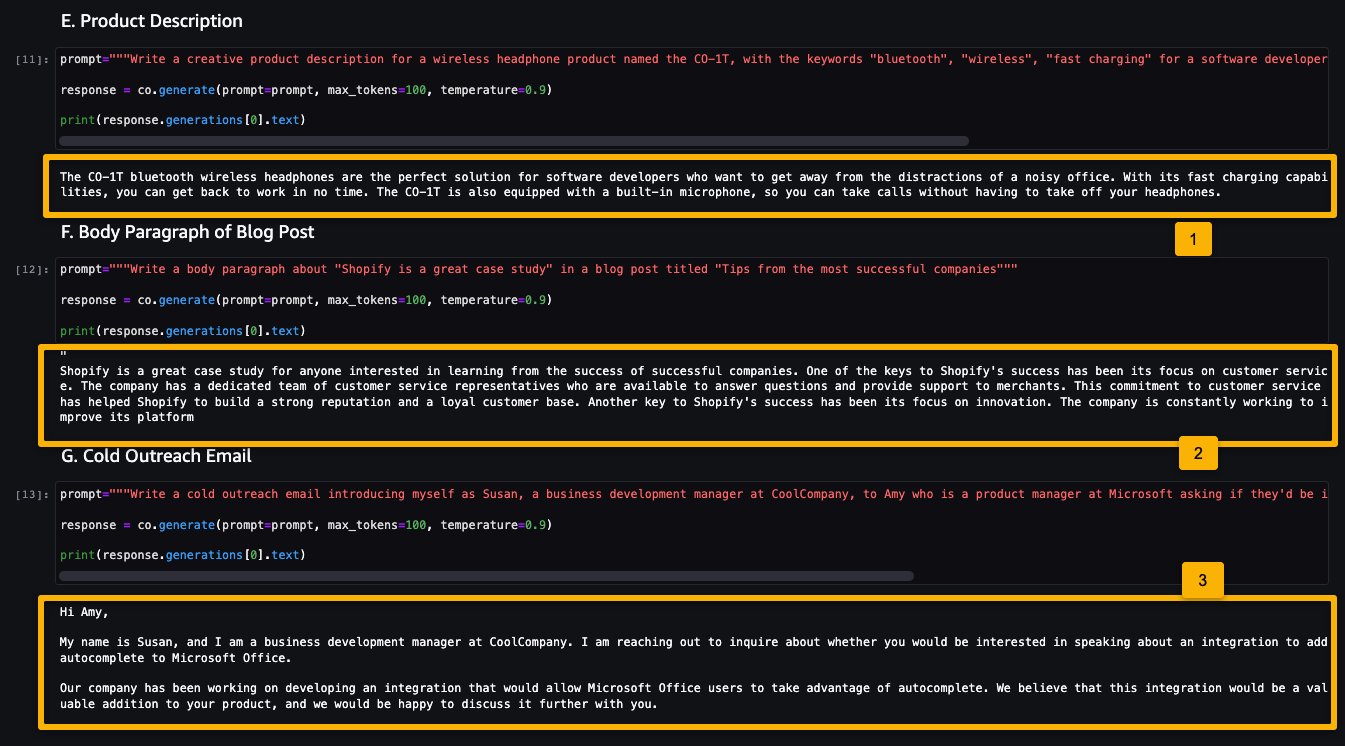

Ahora corramos la inferencia para ver algunas de las salidas del modelo de Comando.

La siguiente captura de pantalla muestra un ejemplo de generación de una publicación laboral y su salida. Como se puede ver, el modelo generó una publicación a partir del estímulo dado.

Ahora veamos los siguientes ejemplos:

- Generar una descripción de producto

- Generar un párrafo de cuerpo de una publicación de blog

- Generar un correo electrónico de divulgación

Como se puede ver, el modelo de Comando de Cohere generó texto para varias tareas generativas.

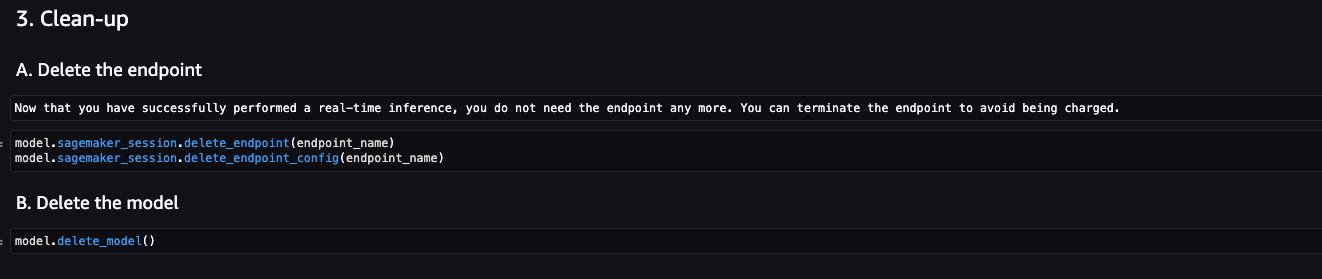

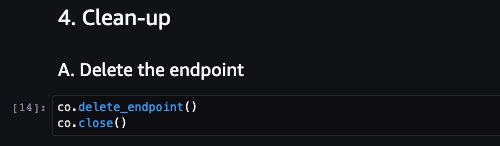

Ahora que ha realizado la inferencia en tiempo real para la prueba, es posible que no necesite el punto final. Puede eliminar el punto final para evitar cargos.

LightOn Mini-instruct

Mini-instruct, un modelo de IA con 40 mil millones de parámetros creado por LightOn, es un potente sistema de IA multilingüe que ha sido entrenado utilizando datos de alta calidad de numerosas fuentes. Está construido para comprender el lenguaje natural y reaccionar a comandos específicos para sus necesidades. Se desempeña admirablemente en productos de consumo como asistentes de voz, chatbots y electrodomésticos inteligentes. También tiene una amplia gama de aplicaciones empresariales, incluida la asistencia de agentes y la producción de lenguaje natural para el cuidado automatizado de clientes.

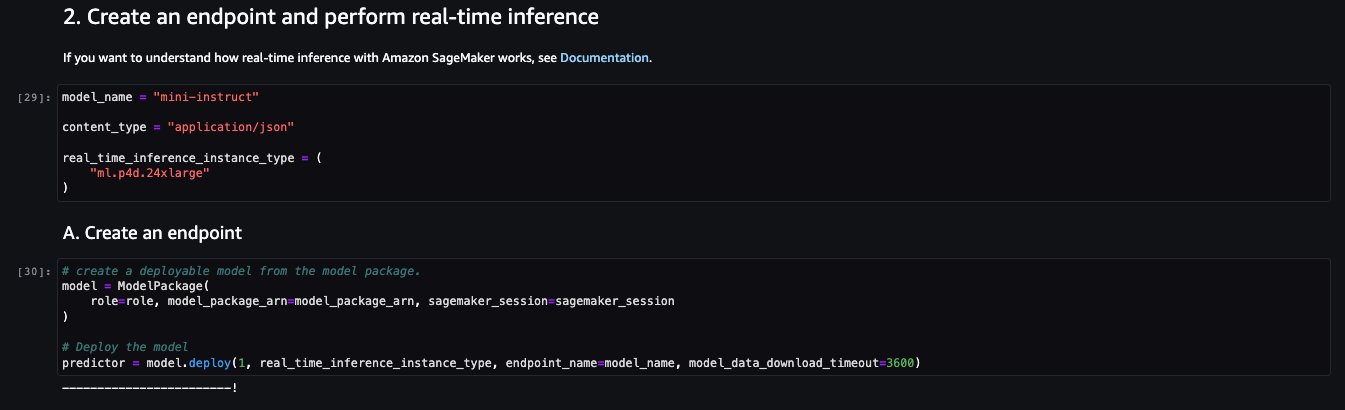

El cuaderno de muestra para el modelo de Mini-instruct de LightOn proporciona importantes requisitos previos que deben seguirse. Por ejemplo, el modelo está suscrito desde AWS Marketplace, tiene los permisos adecuados de roles de IAM y la versión requerida de boto3, entre otros. Lo guía a través de cómo seleccionar el paquete de modelos, crear puntos finales para inferencia en tiempo real y luego limpiarlos.

Algunas de las tareas son similares a las cubiertas en el ejemplo anterior del cuaderno, como instalar Boto3 y obtener la sesión y la región.

Veamos la creación del punto final. Primero, proporcione el ARN del paquete de modelos, el nombre del punto final, el tipo de instancia a utilizar y el número de instancias. Una vez creado, el punto final aparece en su sección de puntos finales de SageMaker.

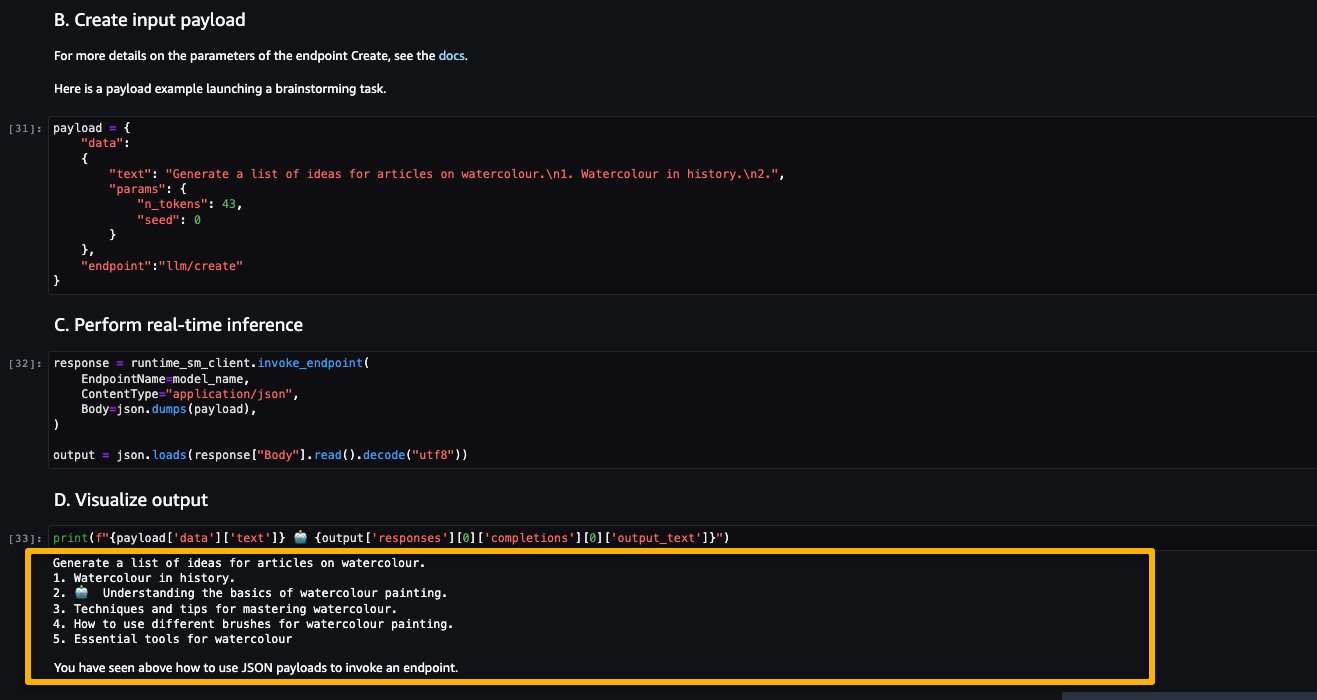

Ahora intentemos inferir el modelo pidiéndole que genere una lista de ideas para artículos sobre un tema, en este caso acuarela.

Como puede ver, el modelo LightOn Mini-instruct pudo proporcionar texto generado basado en la indicación dada.

Limpiar

Después de haber probado los modelos y creado los puntos finales de inferencia para los modelos propietarios de ejemplo, asegúrese de eliminar los puntos finales de inferencia de SageMaker y eliminar los modelos para evitar cargos.

Conclusión

En esta publicación, le mostramos cómo comenzar con modelos propietarios de proveedores de modelos como AI21, Cohere y LightOn en SageMaker Studio. Los clientes pueden descubrir y usar modelos Foundation propietarios en SageMaker JumpStart desde Studio, el SDK de SageMaker y la consola de SageMaker. Con esto, tienen acceso a modelos de ML a gran escala que contienen miles de millones de parámetros y están pre-entrenados en terabytes de datos de texto e imagen para que los clientes puedan realizar una amplia gama de tareas, como resumen de artículos y generación de texto, imagen o video. Debido a que los modelos foundation están pre-entrenados, también pueden ayudar a reducir los costos de capacitación e infraestructura y permitir la personalización para su caso de uso.

Recursos

- Documentación de SageMaker JumpStart

- Documentación de modelos Foundation de SageMaker JumpStart

- Página de detalles del producto SageMaker JumpStart

- Catálogo de modelos de SageMaker JumpStart

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Fármaco diseñado por inteligencia artificial listo para ensayos en humanos.

- Cómo usar el plugin de Bardeen ChatGPT

- Traje de Realidad Virtual podría ayudarte a ‘sentir’ cosas en el Metaverso.

- Robot utiliza una frambuesa falsa para practicar la recolección de frutas.

- Multimodal AI Inteligencia Artificial que puede ver y escuchar

- Wimbledon introduce comentarios impulsados por inteligencia artificial (IA)

- Google respalda la creación de clínicas de ciberseguridad con una donación de $20 millones.