Learn more about Transformers

Grandes modelos de lenguaje DeBERTa – BERT mejorado con decodificación y atención desentrelazada

En los últimos años, BERT se ha convertido en la herramienta número uno en muchas tareas de procesamiento de lenguaje...

Grandes Modelos de Lenguaje, StructBERT — Incorporando Estructuras del Lenguaje en el Entrenamiento Previo

Después de su primera aparición, BERT ha mostrado resultados fenomenales en una variedad de tareas de procesamiento d...

Explicación de la Atención de Múltiples Consultas

La Atención de Múltiples Consultas (MQA) es un tipo de mecanismo de atención que puede acelerar la velocidad de gener...

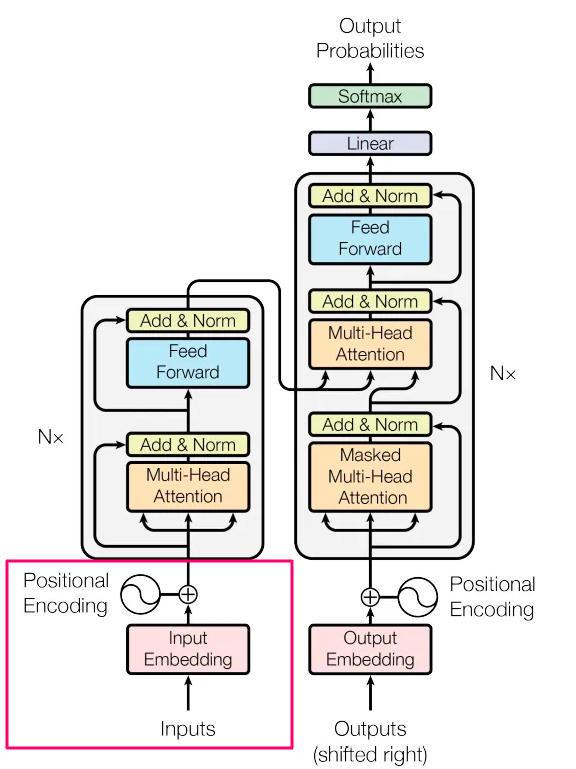

Hacia la IA generativa para la arquitectura del modelo

La revolución del transformador La atención es todo lo que necesitas ha tenido un profundo efecto en el diseño de las...

El ABC de los Transformers Todo lo que necesitas saber

Probablemente ya hayas oído hablar de Transformers, y todo el mundo habla de ello, ¿así que por qué escribir un nuevo...

Transformando texto en vectores Enfoque no supervisado de TSDAE para mejorar los embeddings

Combinar el preentrenamiento de TSDAE en un dominio objetivo con el ajuste fino supervisado en un corpus de propósito...

De-codificado Transformers explicados en un lenguaje sencillo

Sin código, matemáticas o mención de claves, consultas y valores.

Notas sobre CLIP Conexión de texto e imágenes

Los autores del documento anterior tienen como objetivo producir buenas representaciones (características) para imáge...

Grandes modelos de lenguaje RoBERTa – Un enfoque robustamente optimizado de BERT

La aparición del modelo BERT ha llevado a un progreso significativo en el procesamiento del lenguaje natural (NLP, po...

Explicando la atención en Transformers [Desde el punto de vista del codificador]

En este artículo, nos sumergiremos profundamente en el concepto de atención en las redes Transformer, particularmente...

Quantización GPTQ en un modelo Llama 2 7B Fine-Tuned con HuggingFace

En mi artículo anterior, te mostré cómo ajustar finamente el nuevo modelo Llama 2, recién lanzado por Meta AI, para c...

Simplificando Transformers NLP de última generación utilizando palabras que comprendes – parte 2 – Entrada

Dragón sale de huevos, los bebés saltan de vientres, el texto generado por IA comienza desde las entradas. Todos tene...

Swin Transformers | Tareas modernas de visión por computadora

Introducción El Swin Transformer es una innovación significativa en el campo de los transformadores de visión. El ren...

Ajuste fino de un modelo Llama-2 7B para la generación de código en Python

Hace aproximadamente 2 semanas, el mundo de la IA generativa quedó impactado por el lanzamiento del nuevo modelo de I...

Introducción al Aprendizaje Automático de Audio

Actualmente estoy desarrollando un sistema de reconocimiento de voz de audio, por lo que necesitaba repasar mis conoc...

Análisis de acordes de jazz con Transformers

En este artículo, resumo parte de mi artículo de investigación Predicción de jerarquías musicales con un decodificado...

Liberando la Inteligencia Artificial Generativa con VAEs, GANs y Transformadores

Introducción La IA generativa, un campo emocionante en la intersección de la inteligencia artificial y la creatividad...

Introducción práctica a los modelos de Transformer BERT

Explora BERT en un tutorial práctico comprende los transformadores, domina el pre-entrenamiento, el ajuste fino y rea...

Guía introductoria completa sobre el reconocimiento de voz a texto con Transformers

Introducción Todos lidiamos con datos de audio mucho más de lo que nos damos cuenta. El mundo está lleno de datos de ...

Aprendiendo Transformers Code First Parte 1 – La Configuración

No sé tú, pero a veces mirar código es más fácil que leer papers. Cuando estaba trabajando en AdventureGPT, comencé l...

Segmentación de Imágenes Eficiente utilizando PyTorch Parte 4

En esta serie de 4 partes, implementaremos la segmentación de imágenes paso a paso desde cero utilizando técnicas de ...

- You may be interested

- ¿Son los cúbits de gato la clave para u...

- Tu guía para AI y ML generativos en AWS...

- Un paso hacia pilotos automáticos segur...

- ¡Di una vez! Repetir palabras no ayuda ...

- Hugging Face es el nuevo GitHub para LLMs

- Implementando Data Lakes en la Gestión ...

- 8 Ejemplos Modernos de Inteligencia Art...

- Principales 7 casos de uso de ChatGPT e...

- Streaming en Ingeniería de Datos

- El jefe de Microsoft no está preocupado...

- Evaluando el próximo nivel de aprendice...

- Avances en la comprensión de documentos

- Revolutionizando el Aprendizaje Automát...

- Navegando la IA Específica de la Indust...

- Investigadores de UC San Diego presenta...

Find your business way

Globalization of Business, We can all achieve our own Success.