RT-2 Nuevo modelo traduce visión y lenguaje en acción

RT-2 nuevo modelo traduce visión y lenguaje en acción

Robotic Transformer 2 (RT-2) es un modelo novedoso de visión-lenguaje-acción (VLA) que aprende tanto de datos web como de robótica, y traduce este conocimiento en instrucciones generalizadas para el control de robots.

Los modelos de visión-lenguaje de alta capacidad (VLM) son entrenados en conjuntos de datos a gran escala de la web, lo que hace que estos sistemas sean notablemente buenos para reconocer patrones visuales o lingüísticos y operar en diferentes idiomas. Pero para que los robots logren un nivel similar de competencia, necesitarían recopilar datos de robots de primera mano en cada objeto, entorno, tarea y situación.

En nuestro artículo, presentamos Robotic Transformer 2 (RT-2), un modelo novedoso de visión-lenguaje-acción (VLA) que aprende tanto de datos web como de robótica, y traduce este conocimiento en instrucciones generalizadas para el control de robots, manteniendo al mismo tiempo capacidades a gran escala de la web.

Este trabajo se basa en Robotic Transformer 1 (RT-1), un modelo entrenado en demostraciones de múltiples tareas, que puede aprender combinaciones de tareas y objetos vistos en los datos de robótica. Específicamente, nuestro trabajo utilizó datos de demostración de robots RT-1 que se recopilaron con 13 robots durante 17 meses en un entorno de cocina de oficina.

- Conoce el modelo GOAT-7B-Community un modelo de IA ajustado finamente a partir del modelo LLaMA-2 7B en un conjunto de datos recopilados de la aplicación GoatChat.

- Ofreciendo entrenamiento gratuito en IA para todos en el Reino Unido

- Investigadores de DeepMind redefinen el Aprendizaje Reforzado Continuo con una precisa definición matemática

RT-2 muestra capacidades mejoradas de generalización y comprensión semántica y visual más allá de los datos de robótica a los que fue expuesto. Esto incluye interpretar nuevos comandos y responder a comandos de usuario realizando razonamientos rudimentarios, como razonar sobre categorías de objetos o descripciones de alto nivel.

También mostramos que al incorporar razonamiento en cadena permite a RT-2 realizar razonamiento semántico en múltiples etapas, como decidir qué objeto se podría utilizar como un martillo improvisado (una piedra), o qué tipo de bebida es mejor para una persona cansada (una bebida energética).

Adaptando VLMs para el control robótico

RT-2 se basa en VLMs que toman una o más imágenes como entrada y producen una secuencia de tokens que, convencionalmente, representan texto en lenguaje natural. Estos VLMs han sido entrenados con éxito en datos a gran escala de la web para realizar tareas como responder preguntas visuales, describir imágenes o reconocer objetos. En nuestro trabajo, adaptamos el modelo de Lenguaje e Imagen de Pathways (PaLI-X) y el modelo de Lenguaje Encarnado de Pathways (PaLM-E) para actuar como los pilares de RT-2.

Para controlar un robot, este debe ser entrenado para generar acciones. Abordamos este desafío representando las acciones como tokens en la salida del modelo, similares a los tokens del lenguaje, y describiendo las acciones como cadenas que pueden ser procesadas por tokenizadores de lenguaje natural estándar, como se muestra aquí:

La cadena comienza con una bandera que indica si continuar o terminar el episodio actual sin ejecutar los comandos subsiguientes, y continúa con los comandos para cambiar la posición y rotación del efector final, así como la extensión deseada del gripper del robot.

Utilizamos la misma versión discretizada de las acciones del robot que en RT-1, y mostramos que al convertirla en una representación de cadena, es posible entrenar modelos VLM en datos de robótica, ya que los espacios de entrada y salida de dichos modelos no necesitan ser modificados.

Generalización y habilidades emergentes

Realizamos una serie de experimentos cualitativos y cuantitativos en nuestros modelos RT-2, en más de 6,000 pruebas robóticas. Explorando las capacidades emergentes de RT-2, primero buscamos tareas que requirieran combinar conocimiento de datos a gran escala y la experiencia del robot, y luego definimos tres categorías de habilidades: comprensión de símbolos, razonamiento y reconocimiento humano.

Cada tarea requería entender conceptos visuales-semánticos y la capacidad de realizar el control robótico para operar en estos conceptos. Comandos como “recoge la bolsa que está a punto de caerse de la mesa” o “mueve el plátano a la suma de dos más uno” – donde se le pide al robot realizar una tarea de manipulación en objetos o escenarios nunca vistos en los datos robóticos – requerían conocimiento traducido de datos basados en la web para operar.

En todas las categorías, observamos un aumento en el rendimiento de generalización (más de 3 veces de mejora) en comparación con referencias anteriores, como modelos RT-1 anteriores y modelos como Visual Cortex (VC-1), que fueron pre-entrenados en grandes conjuntos de datos visuales.

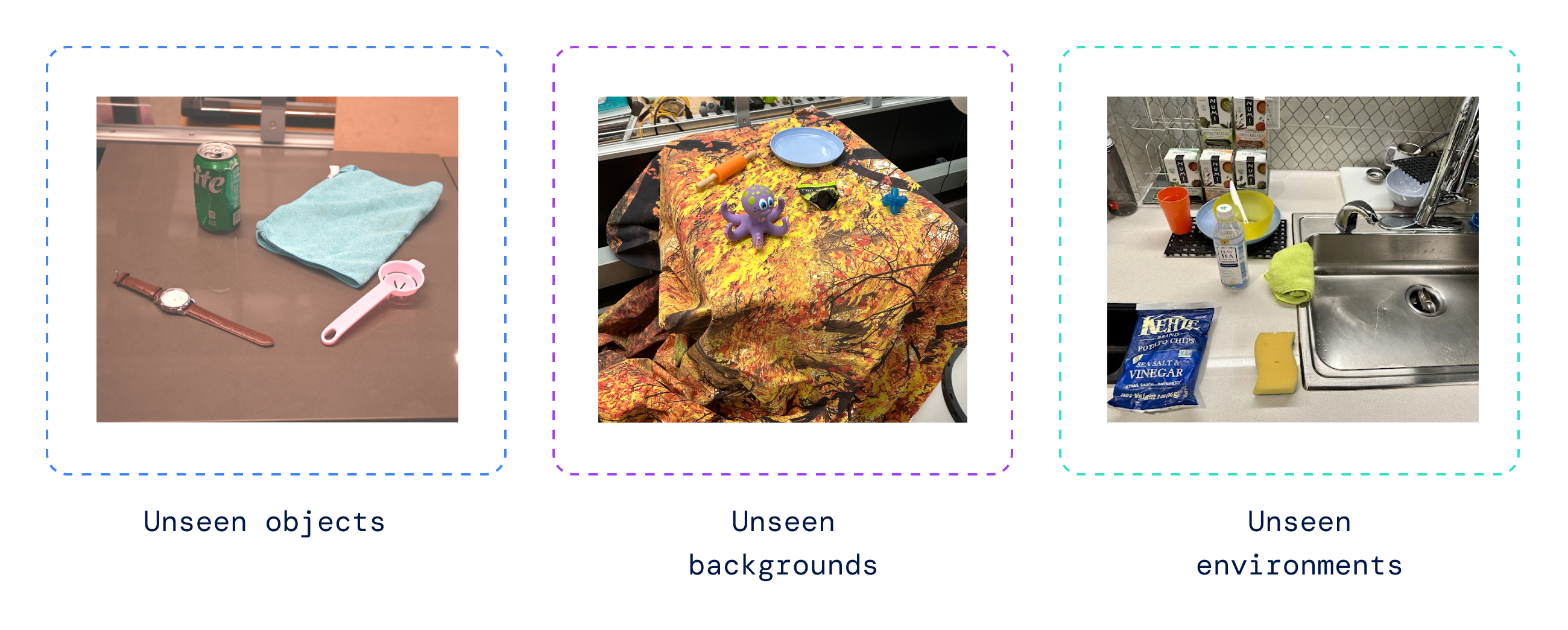

También realizamos una serie de evaluaciones cuantitativas, comenzando con las tareas originales de RT-1, para las cuales tenemos ejemplos en los datos del robot, y continuamos con grados variables de objetos, fondos y entornos previamente no vistos por el robot, que requerían que el robot aprendiera la generalización a partir del pre-entrenamiento de VLM.

RT-2 mantuvo el rendimiento en las tareas originales vistas en los datos del robot y mejoró el rendimiento en escenarios previamente no vistos por el robot, pasando del 32% de RT-1 al 62%, mostrando el considerable beneficio del pre-entrenamiento a gran escala.

Además, observamos mejoras significativas en comparación con referencias pre-entrenadas en tareas solo visuales, como VC-1 y Representaciones Reutilizables para Manipulación Robótica (R3M), y algoritmos que utilizan VLM para la identificación de objetos, como Manipulación de Objetos de Mundo Abierto (MOO).

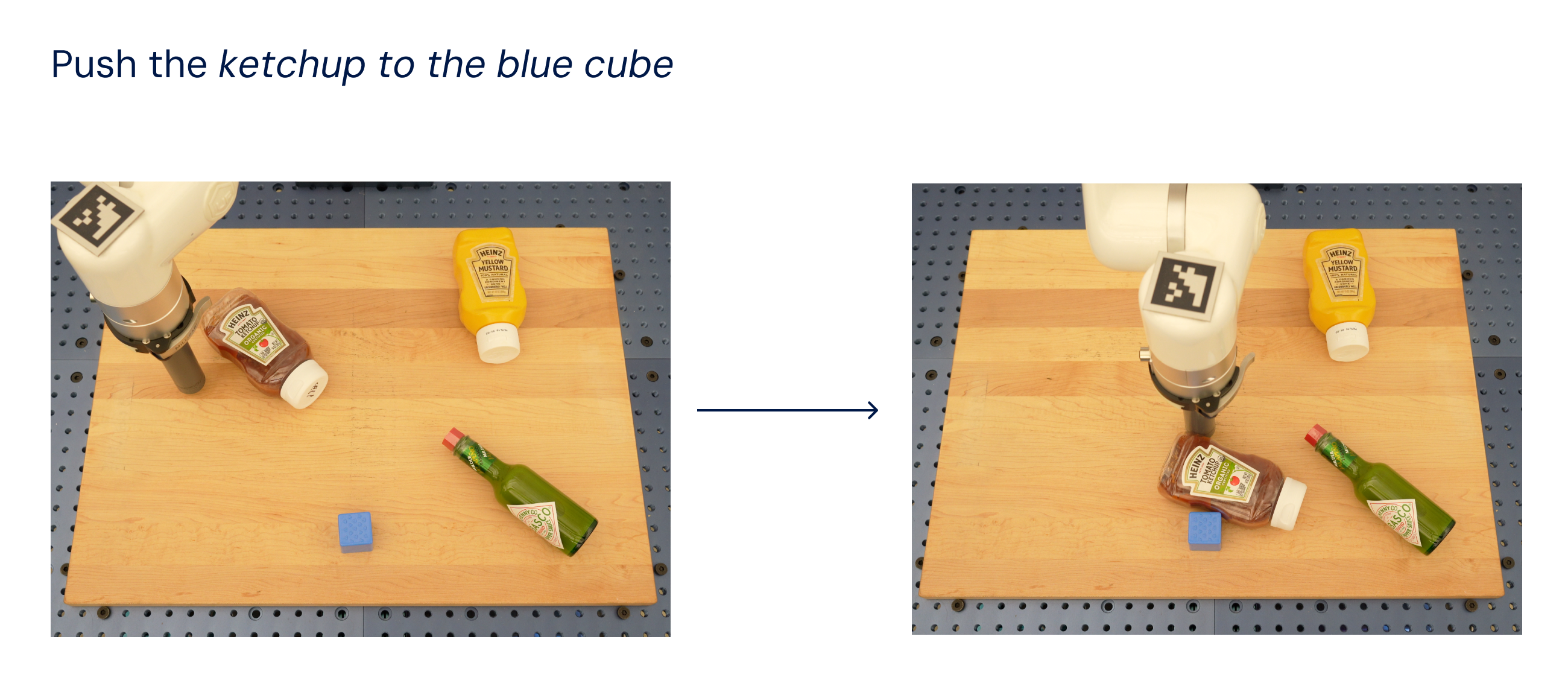

Evaluando nuestro modelo en la suite de tareas robóticas de código abierto Language Table, logramos una tasa de éxito del 90% en simulación, mejorando sustancialmente las referencias anteriores, incluyendo BC-Z (72%), RT-1 (74%) y LAVA (77%).

Luego evaluamos el mismo modelo en el mundo real (ya que fue entrenado en simulación y datos reales) y demostramos su capacidad para generalizar a objetos novedosos, como se muestra a continuación, donde ninguno de los objetos, excepto el cubo azul, estaba presente en el conjunto de datos de entrenamiento.

Inspirados por los métodos de incitación de cadena de pensamiento utilizados en los LLM, investigamos nuestros modelos para combinar el control robótico con la razón de cadena de pensamiento para habilitar el aprendizaje de planificación a largo plazo y habilidades de bajo nivel dentro de un solo modelo.

En particular, ajustamos finamente una variante de RT-2 durante solo unos cientos de pasos de gradiente para aumentar su capacidad de utilizar el lenguaje y las acciones de manera conjunta. Luego, ampliamos los datos para incluir un paso adicional de “Plan”, describiendo primero el propósito de la acción que el robot está a punto de tomar en lenguaje natural, seguido de “Acción” y los tokens de acción. Aquí mostramos un ejemplo de dicho razonamiento y el comportamiento resultante del robot:

Con este proceso, RT-2 puede realizar comandos más complejos que requieren razonamiento sobre los pasos intermedios necesarios para cumplir con una instrucción del usuario. Gracias a su base VLM, RT-2 también puede planificar tanto desde comandos de imagen como de texto, lo que permite una planificación fundamentada en la visualización, mientras que enfoques actuales de planificación y acción como SayCan no pueden ver el mundo real y dependen completamente del lenguaje.

Avanzando en el control robótico

RT-2 muestra que los modelos de visión y lenguaje (VLM) se pueden transformar en modelos de visión, lenguaje y acción (VLA) poderosos, que pueden controlar directamente un robot al combinar el preentrenamiento de VLM con datos robóticos.

Con dos instancias de VLAs basadas en PaLM-E y PaLI-X, RT-2 da como resultado políticas robóticas altamente mejoradas y, lo que es más importante, conduce a un rendimiento de generalización significativamente mejor y capacidades emergentes, heredadas del preentrenamiento de visión y lenguaje a escala web.

RT-2 no solo es una modificación simple y efectiva de los modelos de VLM existentes, sino que también muestra la promesa de construir un robot físico de propósito general que pueda razonar, resolver problemas e interpretar información para realizar una variedad diversa de tareas en el mundo real.

Lea nuestro artículo: https://robotics-transformer2.github.io/assets/rt2.pdf

Obtenga más información en la palabra clave: https://blog.google/technology/ai/google-deepmind-rt2-robotics-vla-model/

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Construye tu propio traductor con LLMs y Hugging Face

- Difusión estable XL en Mac con cuantificación avanzada de Core ML

- Los desarrolladores buscan OpenUSD en la era de la IA y la digitalización industrial

- 3 prácticas emergentes para una IA generativa responsable

- INDIAai y Meta se unen Abren camino para la innovación y colaboración en IA

- Investigadores demuestran pagos digitales cuánticos ‘incondicionalmente seguros

- En el Festival de Wagner, la nueva tecnología revela una brecha de liderazgo