RAG vs Finetuning ¿Cuál es la mejor herramienta para impulsar tu solicitud de LLM?

RAG vs Finetuning ¿Cuál es la mejor herramienta para tu solicitud de LLM?

La guía definitiva para elegir el método adecuado para tu caso de uso

Prólogo

A medida que aumenta el interés en los Modelos de Lenguaje Grande (LLM), muchos desarrolladores y organizaciones están ocupados construyendo aplicaciones que aprovechan su poder. Sin embargo, cuando los LLM pre-entrenados no funcionan como se esperaba, surge la pregunta sobre cómo mejorar el rendimiento de la aplicación de LLM. Y eventualmente llegamos al punto en el que nos preguntamos: ¿Deberíamos utilizar Generación con Recuperación Aumentada (RAG) o ajuste de modelo para mejorar los resultados?

Antes de profundizar, vamos a desmitificar estos dos métodos:

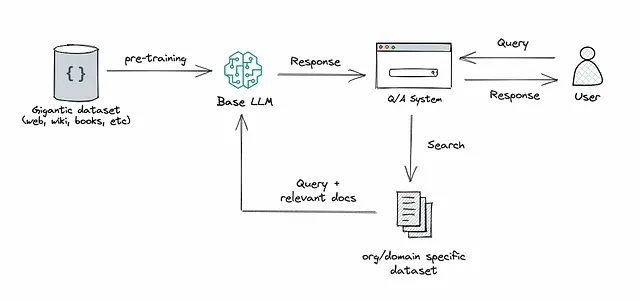

RAG: Este enfoque integra el poder de la recuperación (o búsqueda) en la generación de texto de LLM. Combina un sistema recuperador, que obtiene fragmentos de documentos relevantes de un gran corpus, y un LLM, que produce respuestas utilizando la información de esos fragmentos. En esencia, RAG ayuda al modelo a “buscar” información externa para mejorar sus respuestas.

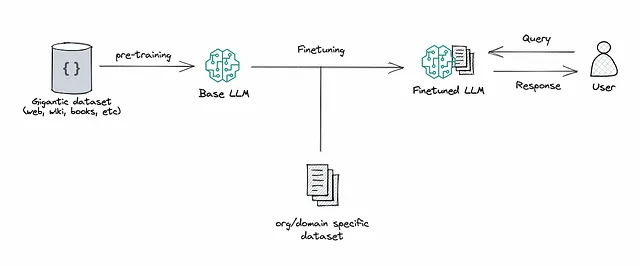

Ajuste de modelo: Este es el proceso de tomar un LLM pre-entrenado y entrenarlo aún más con un conjunto de datos más pequeño y específico para adaptarlo a una tarea en particular o mejorar su rendimiento. Al ajustar el modelo, estamos ajustando los pesos del modelo en función de nuestros datos, haciéndolo más adaptado a las necesidades únicas de nuestra aplicación.

- ¿Podemos evitar que los LLMs alucinen?

- Explorando el paisaje de la inteligencia artificial generativa

- Agentes de IA Tendencia del Mes en IA Generativa

Tanto RAG como el ajuste de modelo sirven como herramientas poderosas para mejorar el rendimiento de las aplicaciones basadas en LLM, pero abordan diferentes aspectos del proceso de optimización, y esto es crucial a la hora de elegir uno sobre el otro.

Anteriormente, solía sugerir a las organizaciones que experimentaran con RAG antes de adentrarse en el ajuste de modelo. Esto se basaba en mi percepción de que ambos enfoques lograban resultados similares pero variaban en términos de complejidad, costo y calidad. Incluso solía ilustrar este punto con…

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Descubriendo el Teorema de Flujo Máximo Corte Mínimo Un Enfoque Integral y Formal

- IA generativa para conocimientos biomédicos

- GPT-3 ¿Aprendizaje de pocos ejemplos para modelos de lenguaje?

- Ciencia de Datos Orientada a Objetos Refactorización de Código

- Una comparación de los métodos Temporal-Difference (0) y Constant-α Monte Carlo en la tarea de Random Walk

- Comparando y explicando los modelos de difusión en los Difusores de HuggingFace

- GPT-4 8 Modelos en Uno; El Secreto ha Sido Revelado