Más allá de GPT-4 ¿Qué hay de nuevo?

¿Qué hay de nuevo después de GPT-4?

Cuatro tendencias principales en Gen AI: de LLM a multimodal, de conexiones a vector DB, de agentes a OS y de ajuste fino a complementos

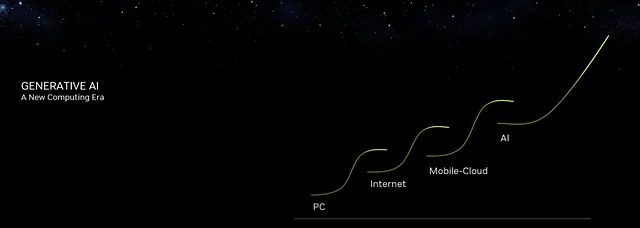

El CEO de Nvidia comparó a ChatGPT con el “Momento del iPhone” para la IA, marcando un hito en la innovación tecnológica y el impacto económico similar al del iPhone. Esto demuestra que la IA está inaugurando la próxima era de la movilidad y la nube, que actualmente es el ecosistema tecnológico más grande. Consulta las cuatro eras de la computación en el diagrama de apertura.

GPT-4 es el límite para todos los LLM. Y Llama 2 de Meta es el líder en la comunidad de código abierto de LLM. ¿Qué hay de nuevo después de GPT-4?

La evolución de la IA nunca se detiene. Hay cuatro tendencias emocionantes después de GPT-4: de LLM a multimodal, de conexiones a vector DB, de agentes a OS y de ajuste fino a complementos.

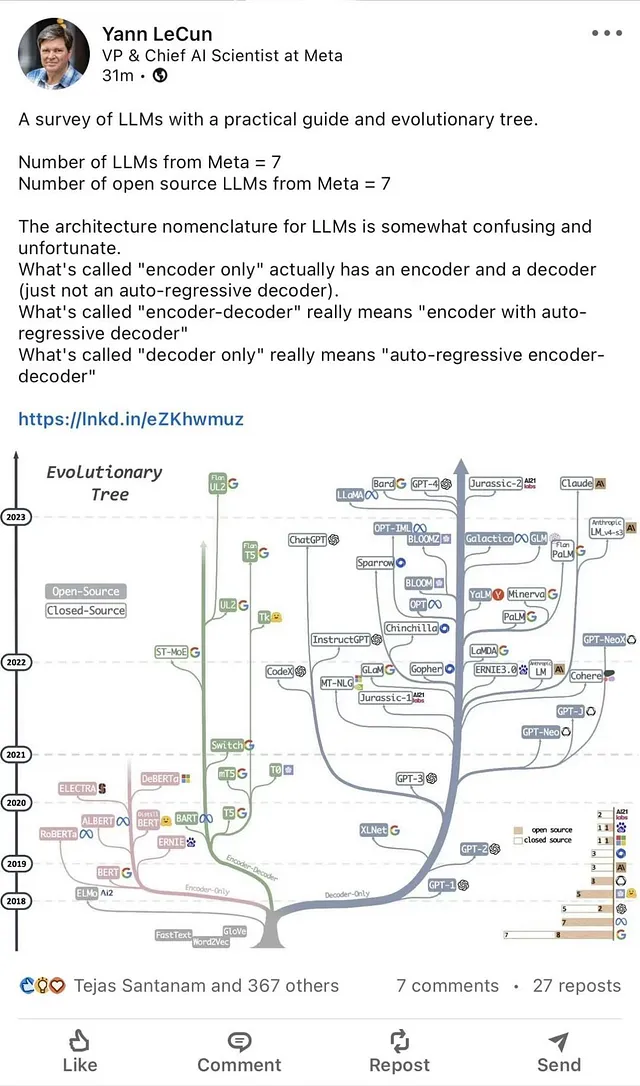

Variantes de LLM y código abierto de Meta

Antes de analizar las cuatro tendencias principales, compartiré lo último sobre Llama 2 de Meta y Code Llama.

- Conoce a BLIVA un modelo de lenguaje multimodal grande para manejar mejor preguntas visuales ricas en texto

- Grita al Diablo ‘Devil May Cry 5’ de Capcom se une a GeForce NOW

- Cómo se puede utilizar el Aprendizaje Automático para reducir las facturas de energía

Llama 2 de Meta representa una evolución sofisticada en LLM. Esta suite abarca modelos preentrenados y ajustados en un espectro de parámetros de 7 mil millones a 70 mil millones. Una derivada especializada, Llama 2-Chat, ha sido diseñada específicamente para aplicaciones centradas en el diálogo.

Las pruebas de referencia revelaron el rendimiento superior de Llama 2 en comparación con la mayoría de los modelos de chat de código abierto existentes. Las evaluaciones centradas en el ser humano, enfocadas en métricas de seguridad y utilidad, posicionaron a Llama 2-Chat como un posible competidor frente a contrapartes propietarias y cerradas de código fuente.

La trayectoria de desarrollo de Llama 2 enfatizó metodologías rigurosas de ajuste fino. La delimitación transparente de estos procesos por parte de Meta tiene como objetivo catalizar los avances impulsados por la comunidad en LLM, destacando un compromiso con el desarrollo colaborativo y responsable de la IA.

Code Llama se construye sobre Llama 2 y está disponible en tres modelos:

- Code Llama, el modelo de código fundamental;

- Code Llama – Python especializado para Python;

- y Code Llama – Instruct, que se ajusta fino para comprender instrucciones en lenguaje natural.

Según las pruebas de referencia, Code Llama superó a los LLM disponibles públicamente más avanzados (excepto GPT-4) en tareas de código.

Llama 2, Llama 2-Chat y Code Llama son pasos clave en el desarrollo de LLM, pero aún tienen un camino por recorrer en comparación con GPT-4. El acceso abierto y el compromiso de Meta para mejorar estos modelos prometen un progreso transparente y más rápido en LLM en el futuro.

Consulta las variantes de LLM y Llama a continuación:

De LLM a Multimodal

Los LLM, como ChatGPT de OpenAI (GPT-3.5), se centran principalmente en comprender y generar lenguaje humano. Han sido fundamentales en tareas como la generación de texto, la traducción e incluso la escritura creativa. Sin embargo, su alcance se limita al texto.

Ingresa a los modelos multimodales como GPT-4. Estos son una nueva generación de modelos de IA que pueden comprender y generar no solo texto, sino también imágenes, sonidos y potencialmente otros tipos de datos. El término “multimodal” se refiere a su capacidad para procesar múltiples modos o tipos de datos simultáneamente. Esto marca un cambio importante. ¡Imagina una IA que no solo pueda leer una descripción de un vestido, sino también visualizarlo o incluso diseñarlo!

El cambio hacia modelos multimodales significa un movimiento hacia sistemas de IA más holísticos. Estos sistemas pueden comprender potencialmente nuestro mundo de una manera más completa, cerrando la brecha entre diferentes formas de datos y proporcionando soluciones más ricas e integradas.

A medida que nos encontramos en el umbral de esta nueva era, es emocionante imaginar la gran cantidad de aplicaciones e innovaciones que los modelos multimodales traerán a la mesa. El futuro de la IA parece más integrado y versátil que nunca.

De conexiones a Vector DB

El panorama de la IA está presenciando una transición fascinante: de las conexiones del modelo de lenguaje (LLM), ejemplificado por herramientas como LangChain y LlamaIndex, al surgimiento de las bases de datos vectoriales (Vector DB) como Weaviate, Milvus, Pinecone, Chroma y Vespa.ai. Pero ¿qué impulsa este cambio y por qué es importante?

Las conexiones del LLM, como el LlamaIndex, se centran principalmente en vincular y comprender grandes cantidades de datos textuales. Han sido fundamentales en la creación de conexiones semánticas, permitiendo experiencias de búsqueda más intuitivas y mejorando la accesibilidad de los datos. Sin embargo, a medida que aumenta el volumen y la variedad de los datos, se hace evidente la necesidad de mecanismos de almacenamiento y recuperación más avanzados.

Aquí es donde entran en juego las bases de datos vectoriales. A diferencia de las bases de datos tradicionales que almacenan datos en filas y columnas, las bases de datos vectoriales almacenan datos en un espacio de alta dimensionalidad, lo que permite búsquedas de similitud más eficientes y precisas. Herramientas como Weaviate y Milvus están diseñadas para manejar conjuntos de datos masivos, lo que las hace ideales para tareas como reconocimiento de imágenes, sistemas de recomendación y más.

El movimiento hacia las bases de datos vectoriales representa una tendencia más amplia en la IA: la búsqueda de soluciones de manejo de datos más eficientes, escalables y versátiles. A medida que navegamos por esta evolución, queda claro que la combinación de LLM y bases de datos vectoriales redefinirá cómo almacenamos, accedemos y comprendemos los datos en el futuro impulsado por la IA.

De agentes a sistemas operativos

El ámbito de la IA está lleno de innovaciones y uno de los cambios más intrigantes que estamos presenciando es la transición de los agentes del LLM a utilizar LLM como sistemas operativos (OS). Sumergámonos en esta evolución y sus implicaciones.

Los agentes del LLM, como AutoGPT, AgentGPT, BabyAGI y HuggingGPT, han sido revolucionarios en la automatización de tareas basadas en solicitudes de usuarios. Estos agentes aprovechan el poder de los modelos de lenguaje (LLMs) para comprender y ejecutar comandos, lo que los hace invaluables en tareas que van desde la generación de contenido hasta el análisis de datos. Su adaptabilidad e inteligencia los han convertido en elementos básicos en muchas herramientas de IA.

Sin embargo, la visión de la IA no se detiene ahí. El concepto de LLM como OS está emergiendo como la próxima gran cosa. Imagina un sistema operativo donde el núcleo es un modelo de lenguaje, orquestando todo a su alrededor. Un sistema así no solo ejecutaría tareas, sino que comprendería el contexto, anticiparía las necesidades y ofrecería soluciones en tiempo real. Es como convertir el LLM en el cerebro del ecosistema digital, haciendo que los dispositivos y aplicaciones sean más intuitivos y receptivos que nunca.

El movimiento hacia LLM como OS significa un cambio de paradigma en cómo percibimos y utilizamos la IA. Ya no se trata solo de automatización, se trata de crear una interfaz fluida e inteligente entre los humanos y la tecnología. A medida que nos encontramos al borde de esta transformación, el potencial de los OS impulsados por LLM para revolucionar nuestras interacciones digitales es inmenso.

De ajuste fino a plugins

El mundo de los LLM está experimentando un cambio transformador, pasando de procesos de ajuste fino intrincados a la esfera más dinámica de los plugins. Desentrañemos esta evolución.

Históricamente, el ajuste fino ha sido la piedra angular de la optimización de los LLM. Hay dos formas principales de ajustar finamente los LLM: alimentando datos en tiempo real en el LLM y ajustando directamente sobre el LLM. Desde un punto de vista técnico, esto implica tres métodos:

- Aprendizaje por transferencia: adaptar un modelo preentrenado a nuevas tareas.

- Ajuste fino secuencial: refinar modelos en etapas para tareas específicas.

- Ajuste fino específico de la tarea: adaptar modelos para una función particular.

Además, técnicas de LLM como aprendizaje en contexto, aprendizaje con pocos ejemplos y aprendizaje con cero ejemplos han mejorado aún más la adaptabilidad del modelo, permitiéndoles comprender y generar contenido con datos mínimos.

Sin embargo, el futuro de los LLM se inclina hacia los plugins. Con la introducción de herramientas como GPT-4 Plugins, el enfoque se centra en extender los LLM de manera transparente. En lugar de ejecutar los LLM como un servicio, se conciben como plataformas. Esto significa integrar los LLM con varias herramientas, mejorar sus capacidades y ofrecer un enfoque más modular y escalable para las aplicaciones de IA.

El viaje desde el ajuste fino hasta los plugins representa un movimiento desde la optimización estática hacia la adaptabilidad dinámica, asegurando que los LLMs se mantengan en la vanguardia de la innovación en IA.

En pocas palabras

El dominio de la IA está presenciando cambios rápidos, con los LLMs desempeñando un papel central. Inicialmente, el movimiento fue desde los LLMs hacia los modelos multimodales, expandiéndose desde el texto para incluir imágenes y sonidos. Simultáneamente, la tendencia cambió desde las conexiones de LLM, que enlazaban datos externos, hacia las Bases de Datos Vectoriales para un almacenamiento eficiente de alta dimensionalidad.

Otra evolución vio a los agentes LLM, que automatizaban tareas, transicionando hacia los LLMs como Sistemas Operativos. Este cambio busca dispositivos y aplicaciones más intuitivas y conscientes del contexto. Además, los procesos tradicionales de ajuste fino de los LLMs ahora están siendo reemplazados por plugins dinámicos, convirtiendo a los LLMs en plataformas integradas con varias herramientas.

Liderando esta revolución de los LLMs se encuentran el GPT-4 de OpenAI y el LLaMA2 de Meta. Sus esfuerzos pioneros están sentando las bases para un futuro de IA más integrado, receptivo y acorde a las interacciones humanas.

Más lecturas

- Aprovechando el poder de los LLMs en la práctica: Un estudio sobre ChatGPT y más allá: https://arxiv.org/abs/2304.13712

- Destellos de la Inteligencia Artificial General: Primeros experimentos con GPT-4: https://arxiv.org/abs/2303.12712

- https://huggingface.co/nomic-ai/gpt4all-j

- https://generativeai.pub/gpt4all-j-the-knowledge-of-humankind-that-fits-on-a-usb-stick-415bdab11ab4

- Introduciendo a Code Llama, un modelo de lenguaje grande de última generación para programar: https://ai.meta.com/blog/code-llama-large-language-model-coding/

- Llama 2: Fundación Abierta y Modelos de Chat Ajustados Fino: https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Persigue una Maestría en Ciencia de Datos con el 3er mejor programa en línea

- Ciencia de Datos vs Ingeniero de Software ¿Cuál es una Mejor Carrera?

- Visión general de los algoritmos de ordenamiento Merge Sort

- Visión general de los algoritmos de ordenamiento Heap Sort

- La Guía Definitiva para Entrenar BERT desde Cero Preparar el Conjunto de Datos

- Representación de caminos en Python

- Regresión lineal desde cero con NumPy