¿Podrían ser los Parches? Este enfoque de IA analiza el principal contribuyente al éxito de los Transformadores de Visión

¿Podrían ser los Parches? Análisis de IA del éxito de los Transformadores de Visión

Las redes neuronales convolucionales (CNN) han sido la columna vertebral de los sistemas para tareas de visión por computadora. Han sido la arquitectura preferida para todo tipo de problemas, desde la detección de objetos hasta la superresolución de imágenes. De hecho, los famosos avances (por ejemplo, AlexNet) en el dominio del aprendizaje profundo han sido posibles gracias a las redes neuronales convolucionales.

Sin embargo, las cosas cambiaron cuando una nueva arquitectura basada en modelos Transformer, llamada Vision Transformer (ViT), mostró resultados prometedores y superó a las arquitecturas convolucionales clásicas, especialmente para conjuntos de datos grandes. Desde entonces, el campo ha estado buscando habilitar soluciones basadas en ViT para problemas que se han abordado con CNN durante años.

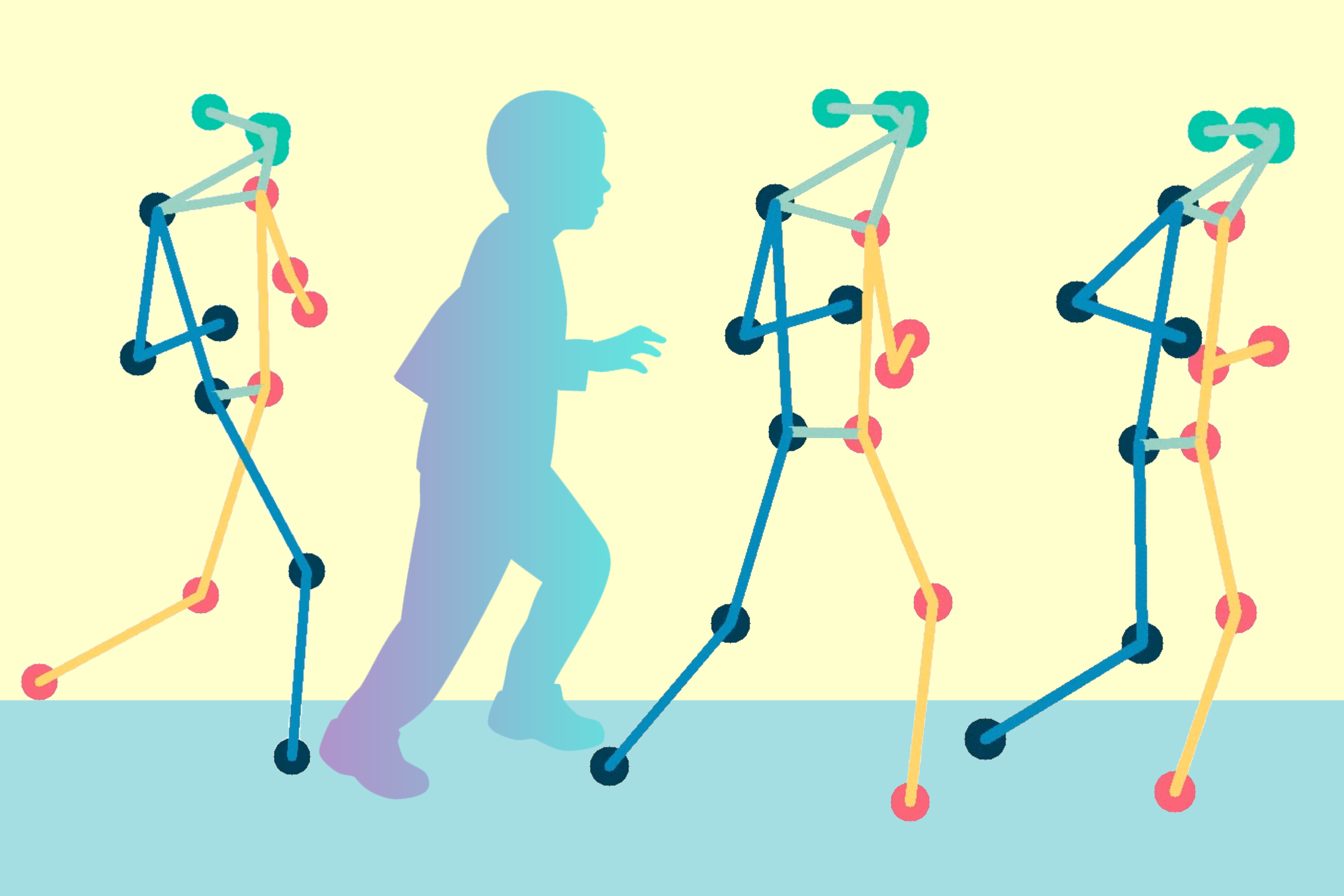

ViT utiliza capas de autoatención para procesar imágenes, pero el costo computacional de estas capas se escalaría de forma cuadrática con el número de píxeles por imagen si se aplicara de manera ingenua a nivel de píxel. Por lo tanto, ViT primero divide la imagen en varios parches, los incrusta linealmente y luego aplica el transformer directamente a esta colección de parches.

- Ecualización del histograma Una guía paso a paso (06)

- Protocolos en Python

- Este artículo de IA propone inyectar el mundo 3D en los grandes modelos de lenguaje y presentar una nueva familia completa de modelos de lenguaje 3D (3D-LLMs).

Después del éxito del ViT original, muchos trabajos han modificado la arquitectura de ViT para mejorar su rendimiento. Reemplazando la autoatención con operaciones novedosas, realizando otros cambios pequeños, etc. Aunque, a pesar de todos estos cambios, casi todas las arquitecturas de ViT siguen una plantilla común y simple. Mantienen un tamaño y resolución iguales en toda la red y presentan un comportamiento isotrópico, logrado mediante la implementación de mezcla espacial y de canal en pasos alternos. Además, todas las redes utilizan incrustaciones de parche que permiten el muestreo descendente al inicio de la red y facilitan el diseño de mezcla directa y uniforme.

Este enfoque basado en parches es la elección de diseño común para todas las arquitecturas de ViT, lo que simplifica el proceso de diseño general. Entonces, surge la pregunta. ¿Es el éxito de los transformers de visión principalmente debido a la representación basada en parches? ¿O se debe al uso de técnicas avanzadas y expresivas como la autoatención y las MLP? ¿Cuál es el factor principal que contribuye al rendimiento superior de los transformers de visión?

Hay una forma de descubrirlo y se llama ConvMixer.

ConvMixer es una arquitectura convolucional desarrollada para analizar el rendimiento de los ViT. Es muy similar al ViT en muchos aspectos: trabaja directamente en los parches de imagen, mantiene una resolución constante en toda la red y separa la mezcla de canales de la mezcla espacial de información en diferentes partes de la imagen.

Sin embargo, la diferencia clave es que ConvMixer logra estas operaciones utilizando capas convolucionales estándar, en lugar de los mecanismos de autoatención utilizados en los modelos Vision Transformer y MLP-Mixer. Al final, el modelo resultante es más económico en términos de potencia de cálculo porque las operaciones de convolución en profundidad y en puntos son más económicas que las capas de autoatención y MLP.

A pesar de su extrema simplicidad, ConvMixer supera tanto a los modelos de visión por computadora “estándar”, como ResNets de recuentos de parámetros similares, como a algunas variantes correspondientes de ViT y MLP-Mixer. Esto sugiere que la arquitectura de mezcla isotrópica basada en parches es un primitivo poderoso que funciona bien con casi cualquier elección de operaciones de mezcla bien comportadas.

ConvMixer es una clase extremadamente simple de modelos que mezcla de manera independiente las ubicaciones espaciales y de canal de las incrustaciones de parches utilizando solo convoluciones estándar. Se puede lograr un impulso de rendimiento sustancial mediante el uso de tamaños de kernel grandes inspirados en los grandes campos receptivos de ViTs y MLP-Mixers. Finalmente, ConvMixer puede servir como punto de referencia para futuras arquitecturas basadas en parches con operaciones novedosas.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- El equipo de IA de Microsoft presenta NaturalSpeech 2 un sistema TTS de vanguardia con modelos de difusión latente para una potente síntesis de voz sin necesidad de entrenamiento previo y prosodias expresivas mejoradas.

- Generación rápida y precisa de hologramas acústicos utilizando un marco basado en aprendizaje profundo

- Este artículo de Inteligencia Artificial (IA) de Corea del Sur propone FFNeRV una nueva representación de video por cuadros utilizando mapas de flujo por cuadros y cuadrículas temporales de múltiple resolución

- Conoce a Rodin un nuevo marco de inteligencia artificial (IA) para generar avatares digitales en 3D a partir de diversas fuentes de entrada.

- Los creativos están luchando contra la inteligencia artificial con demandas legales

- Potenciando la IA en Dispositivos Qualcomm y Meta colaboran con la tecnología Llama 2

- Microsoft lanza TypeChat una biblioteca de IA que facilita la creación de interfaces de lenguaje natural utilizando tipos.