CarperAI presenta OpenELM una biblioteca de código abierto diseñada para permitir la búsqueda evolutiva con modelos de lenguaje tanto en código como en lenguaje natural.

OpenELM es una biblioteca de código abierto de CarperAI que permite la búsqueda evolutiva en modelos de lenguaje en código y lenguaje natural.

El Procesamiento del Lenguaje Natural, uno de los principales subcampos de la Inteligencia Artificial, está avanzando a un ritmo extraordinario. Con su capacidad para permitir que una computadora comprenda el lenguaje humano tal como se habla y se escribe, el PLN tiene varios casos de uso. Uno de estos desarrollos es la introducción de los Modelos de Lenguaje Grandes, que son modelos de aprendizaje profundo entrenados basados en el Procesamiento del Lenguaje Natural, la Comprensión del Lenguaje Natural y la Generación del Lenguaje Natural. Estos modelos imitan a los seres humanos respondiendo preguntas, generando contenido textual preciso, completando códigos, resumiendo largos párrafos de texto, traduciendo lenguajes, y mucho más.

Recientemente, CarperAI, una destacada organización de investigación en IA, ha presentado OpenELM, una biblioteca de código abierto que promete transformar el campo de la búsqueda evolutiva. OpenELM, en el que ELM significa Evolución a través de Modelos Grandes, combina el poder de los modelos de lenguaje grandes con algoritmos evolutivos para permitir la generación de texto y código diversos y de alta calidad. La versión 0.9 de OpenELM ha sido propuesta con el objetivo de proporcionar a los desarrolladores e investigadores una herramienta excepcional para resolver problemas complejos en diversos dominios. Junto con OpenELM, el equipo también ha publicado su paper en GPTP 2023.

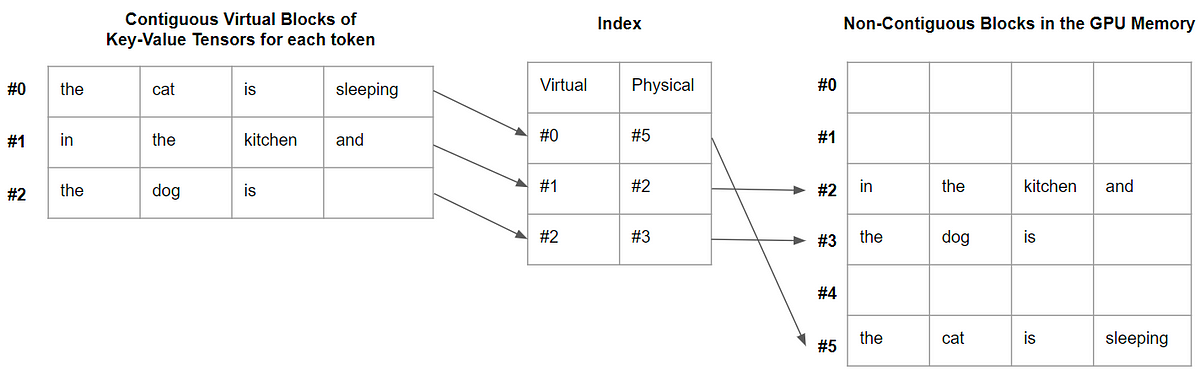

La Evolución a través de Modelos Grandes (ELM) demuestra cómo los LLM pueden mejorar, criticar y mejorar iterativamente su salida. Esta habilidad se puede utilizar para mejorar la capacidad de los modelos de lenguaje para resolver problemas y demuestra su potencial como operadores de búsqueda inteligentes tanto para el lenguaje como para el código. La idea principal detrás de ELM es que los LLM pueden actuar como operadores inteligentes de variación en algoritmos evolutivos. OpenELM aprovecha este potencial para mejorar las habilidades de resolución de problemas de los modelos de lenguaje, permitiendo la creación de contenido variado y de alta calidad en áreas que el modelo podría no haber visto durante el entrenamiento. El equipo ha introducido OpenELM con cuatro objetivos principales, que son los siguientes.

- Productividad impulsada por IA la IA generativa abre una nueva era de eficiencia en todas las industrias

- La evolución automatizada aborda tareas difíciles

- La IA está haciendo que la política sea más fácil, más barata y más peligrosa

- Código abierto: OpenELM ofrece una versión de código abierto de ELM y los modelos diferenciales que lo acompañan, lo que permite a los desarrolladores utilizar libremente la biblioteca y contribuir.

- Integración de modelos: OpenELM está diseñado para funcionar fácilmente tanto con modelos cerrados, que solo se pueden utilizar con APIs comerciales como la API de OpenAI, como con modelos de lenguaje de código abierto, que se pueden utilizar localmente o en plataformas como Colab.

- Interfaz fácil de usar y entornos de muestra: OpenELM tiene como objetivo proporcionar una interfaz de usuario sencilla junto con una variedad de entornos de muestra para la búsqueda evolutiva.

- Potencial evolutivo: OpenELM pretende demostrar el potencial evolutivo de los modelos de lenguaje en combinación con la evolución, y muestra cómo los operadores de variación inteligentes pueden ayudar a los algoritmos evolutivos, especialmente en campos como la creación de código en texto plano y la escritura creativa, aprovechando las posibilidades de los enormes modelos de lenguaje.

Centrándose en métodos de calidad-diversidad (QD) como MAP-Elites, CVT-MAP-Elites y Deep Grid MAP-Elites, OpenELM, al ser una biblioteca rica en funciones, interactúa sin problemas con técnicas evolutivas conocidas. Esto permite crear soluciones de alta calidad y diversificadas al fomentar la diversidad y preservar los mejores individuos dentro de cada especialidad. En conclusión, OpenELM marca un hito significativo en el campo de la búsqueda evolutiva al utilizar el potencial de los modelos de lenguaje grandes para generar texto y código diversos y de alta calidad.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- La FTC investiga si ChatGPT perjudica a los consumidores

- Investigadores cultivan matrices precisas de nanoLEDs

- Calculadora de números determina si las ballenas están actuando de manera extraña

- Los robots de IA podrían desempeñar un papel futuro como compañeros en hogares de cuidado

- El aumento de los costos de los centros de datos vinculados a las demandas de la inteligencia artificial

- Informe China finaliza las reglas de gobierno para los servicios de IA generativa

- ¿Cómo sabemos qué tan inteligentes son los sistemas de IA?