Amplios horizontes La presentación de NVIDIA señala el camino hacia nuevos avances en Inteligencia Artificial

NVIDIA presenta nuevos avances en IA

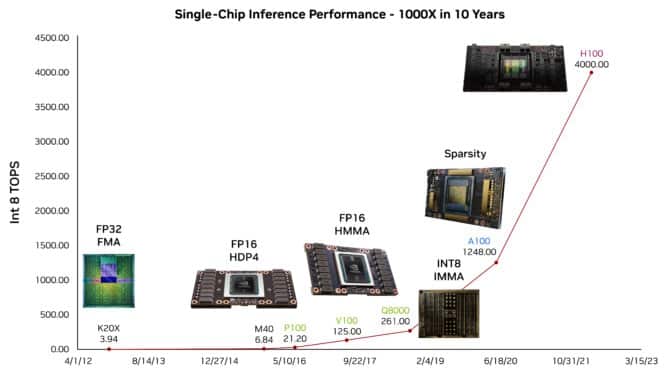

Los avances dramáticos en el rendimiento del hardware han dado lugar a la IA generativa y a una rica variedad de ideas para futuras mejoras de velocidad que llevarán el aprendizaje automático a nuevas alturas, dijo hoy Bill Dally, científico jefe y vicepresidente senior de investigación de NVIDIA, en una presentación principal.

Dally describió una serie de técnicas en desarrollo, algunas de las cuales ya están mostrando resultados impresionantes, en una charla en Hot Chips, un evento anual para arquitectos de procesadores y sistemas.

“El progreso en la IA ha sido enorme, ha sido habilitado por el hardware y aún está limitado por el hardware de aprendizaje profundo”, dijo Dally, uno de los principales científicos informáticos del mundo y ex director del departamento de ciencias de la computación de la Universidad de Stanford.

Mostró, por ejemplo, cómo ChatGPT, el modelo de lenguaje grande (LLM) utilizado por millones de personas, podría sugerir un esquema para su charla. Estas capacidades se deben en gran parte a los avances de las GPU en el rendimiento de la inferencia de IA en la última década, dijo.

- Estas herramientas podrían ayudar a proteger nuestras imágenes de la IA

- Superando la productividad en el desarrollo de microservicios con herramientas de IA

- Inserción de objetos con conciencia de profundidad en videos usando Python

La investigación ofrece 100 TOPS/Watt

Los investigadores están preparando la próxima ola de avances. Dally describió un chip de prueba que demostró casi 100 billones de operaciones por vatio en un LLM.

El experimento mostró una forma eficiente en términos de energía de acelerar aún más los modelos transformadores utilizados en la IA generativa. Se aplicó aritmética de cuatro bits, uno de varios enfoques numéricos simplificados que prometen ganancias futuras.

Mirando más hacia el futuro, Dally habló sobre formas de acelerar los cálculos y ahorrar energía utilizando matemáticas logarítmicas, un enfoque que NVIDIA detalló en una patente de 2021.

Diseño de hardware para IA

Exploró media docena de técnicas adicionales para adaptar el hardware a tareas específicas de IA, a menudo definiendo nuevos tipos de datos u operaciones.

Dally describió formas de simplificar las redes neuronales, podando sinapsis y neuronas en un enfoque llamado esparcidad estructural, adoptado por primera vez en las GPU Tensor Core A100 de NVIDIA.

“No hemos terminado con la esparcidad”, dijo. “Necesitamos hacer algo con las activaciones y también podemos tener una mayor esparcidad en los pesos”.

Los investigadores deben diseñar hardware y software de manera conjunta, tomando decisiones cuidadosas sobre dónde gastar la energía preciosa, dijo. Por ejemplo, los circuitos de memoria y comunicaciones deben minimizar los movimientos de datos.

“Es un momento divertido para ser ingeniero informático porque estamos habilitando esta gran revolución en la IA y ni siquiera hemos comprendido completamente qué tan grande será esta revolución”, dijo Dally.

Redes más flexibles

En una charla separada, Kevin Deierling, vicepresidente de redes de NVIDIA, describió la flexibilidad única de los DPU BlueField de NVIDIA y los interruptores de red Spectrum de NVIDIA para asignar recursos en función del tráfico de red cambiante o las reglas de usuario.

La capacidad de los chips para cambiar dinámicamente las canalizaciones de aceleración de hardware en segundos permite el equilibrio de carga con el máximo rendimiento y proporciona a las redes centrales un nuevo nivel de adaptabilidad. Esto es especialmente útil para defenderse contra amenazas de ciberseguridad.

“Hoy en día, con las cargas de trabajo de IA generativa y la ciberseguridad, todo es dinámico, las cosas cambian constantemente”, dijo Deierling. “Así que nos estamos moviendo hacia la programabilidad en tiempo de ejecución y los recursos que podemos cambiar sobre la marcha”.

Además, los investigadores de NVIDIA y Rice University están desarrollando formas en que los usuarios puedan aprovechar la flexibilidad en tiempo de ejecución utilizando el popular lenguaje de programación P4.

Grace lidera las CPUs de servidor

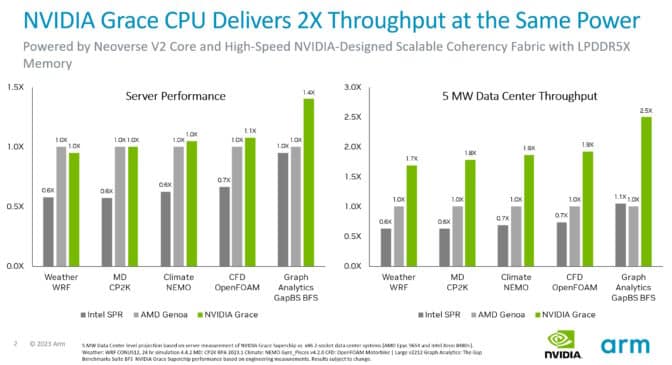

Una charla de Arm sobre sus núcleos Neoverse V2 incluyó una actualización sobre el rendimiento del superchip de CPU Grace de NVIDIA, el primer procesador que los implementa.

Las pruebas muestran que, con la misma potencia, los sistemas Grace ofrecen hasta 2 veces más rendimiento que los servidores x86 actuales en una variedad de cargas de trabajo de CPU. Además, el programa SystemReady de Arm certifica que los sistemas Grace ejecutarán sistemas operativos, contenedores y aplicaciones Arm existentes sin modificaciones.

Grace utiliza una tela ultrarrápida para conectar 72 núcleos Arm Neoverse V2 en una sola matriz, luego una versión de NVLink conecta dos de esas matrices en un paquete, ofreciendo un ancho de banda de 900 GB/s. Es la primera CPU de centro de datos que utiliza memoria LPDDR5X de clase de servidor, ofreciendo un 50% más de ancho de banda de memoria a un costo similar pero una octava parte de la potencia de la memoria de servidor típica.

Hot Chips comenzó el 27 de agosto con un día completo de tutoriales, que incluyeron charlas de expertos de NVIDIA sobre inferencia de inteligencia artificial y protocolos para interconexiones de chip a chip, y se extenderá hasta hoy.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Estas nuevas herramientas podrían ayudar a proteger nuestras imágenes de la IA

- Asistente de Voz Personal impulsado por IA para el Aprendizaje de Idiomas

- Dentro de GPT – I Comprendiendo la generación de texto.

- Aprendizaje automático a gran escala Paralelismo de modelos frente a paralelismo de datos

- Visión del PM Modi sobre la regulación de la IA en India Cumbre B20 2023

- IA y el futuro del fútbol universitario

- Solucionando cuellos de botella en la tubería de entrada de datos con PyTorch Profiler y TensorBoard