Las GPUs NVIDIA H100 establecen el estándar para la IA generativa en el primer benchmark MLPerf.

NVIDIA H100 GPUs set the standard for generative AI in the first MLPerf benchmark.

Los usuarios líderes y las pruebas de referencia de la industria están de acuerdo: las GPUs NVIDIA H100 Tensor Core ofrecen el mejor rendimiento de IA, especialmente en los grandes modelos de lenguaje (LLMs) que impulsan la IA generativa.

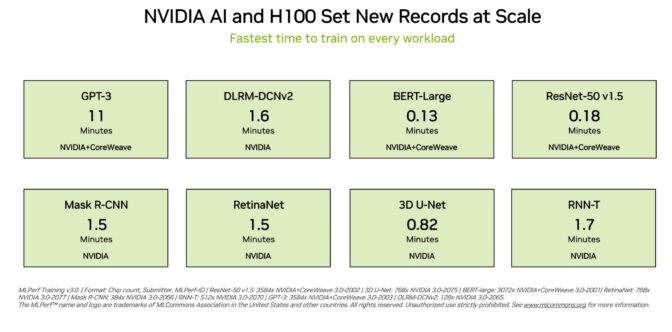

Las GPUs H100 establecieron nuevos récords en las ocho pruebas de referencia de entrenamiento MLPerf más recientes lanzadas hoy, destacándose en una nueva prueba de MLPerf para IA generativa. Esta excelencia se logra tanto por acelerador como a escala en servidores masivos.

Por ejemplo, en un clúster comercialmente disponible de 3.584 GPUs H100 co-desarrollado por la startup Inflection AI y operado por CoreWeave, un proveedor de servicios en la nube especializado en cargas de trabajo aceleradas por GPU, el sistema completó el extenso benchmark de entrenamiento basado en GPT-3 en menos de once minutos.

“Nuestros clientes están construyendo IA generativa y LLM de última generación a escala hoy, gracias a nuestras miles de GPUs H100 en redes InfiniBand rápidas y de baja latencia”, dijo Brian Venturo, co-fundador y CTO de CoreWeave. “Nuestra presentación conjunta de MLPerf con NVIDIA demuestra claramente el gran rendimiento que disfrutan nuestros clientes”.

- La carrera para evitar el peor escenario para el aprendizaje automático

- 8 cosas potencialmente sorprendentes que debes saber sobre los Modelos de Lenguaje Grandes (LLMs)

- Segmentación de Imágenes Eficiente utilizando PyTorch Parte 1

El mejor rendimiento disponible hoy

Inflection AI aprovechó ese rendimiento para construir el LLM avanzado detrás de su primer IA personal, Pi, que significa inteligencia personal. La compañía actuará como un estudio de IA, creando AIs personales con los que los usuarios pueden interactuar de manera simple y natural.

“Cualquiera puede experimentar el poder de una IA personal hoy en función de nuestro modelo de lenguaje grande de última generación que fue entrenado en la potente red de H100 GPUs de CoreWeave”, dijo Mustafa Suleyman, CEO de Inflection AI.

Fundada a principios de 2022 por Mustafa y Karén Simonyan de DeepMind y Reid Hoffman, Inflection AI tiene como objetivo trabajar con CoreWeave para construir uno de los mayores clusters de computación del mundo usando GPUs NVIDIA.

Comparación de resultados

Estas experiencias de usuario reflejan el rendimiento demostrado en las pruebas de referencia de MLPerf anunciadas hoy.

Las GPUs H100 ofrecieron el mejor rendimiento en cada prueba de referencia, incluyendo modelos de lenguaje grandes, recomendaciones, visión por computadora, imágenes médicas y reconocimiento de voz. Fueron las únicas chips que ejecutaron las ocho pruebas, demostrando la versatilidad de la plataforma de IA de NVIDIA.

Excelencia a escala

El entrenamiento es típicamente un trabajo que se ejecuta a escala por muchas GPUs trabajando en conjunto. En cada prueba de referencia de MLPerf, las GPUs H100 establecieron nuevos récords de rendimiento a escala para el entrenamiento de IA.

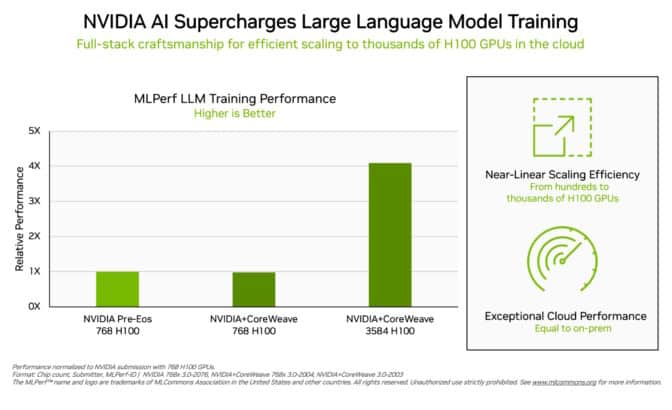

Las optimizaciones en toda la pila de tecnología permitieron una escalabilidad de rendimiento casi lineal en la exigente prueba de LLM a medida que las presentaciones se escalaban de cientos a miles de GPUs H100.

Además, CoreWeave entregó desde la nube un rendimiento similar al que NVIDIA logró desde un supercomputador de IA que se ejecuta en un centro de datos local. Eso es un testimonio de la baja latencia de la red de InfiniBand Quantum-2 de NVIDIA que utiliza CoreWeave.

En esta ronda, MLPerf también actualizó su prueba de referencia para sistemas de recomendación.

La nueva prueba utiliza un conjunto de datos más grande y un modelo de IA más moderno para reflejar mejor los desafíos que enfrentan los proveedores de servicios en la nube. NVIDIA fue la única empresa que presentó resultados en la prueba mejorada.

Un ecosistema de IA de NVIDIA en expansión

Casi una docena de empresas presentaron resultados en la plataforma de NVIDIA en esta ronda. Su trabajo muestra que la IA de NVIDIA está respaldada por el ecosistema más amplio de la industria en el aprendizaje automático.

Las presentaciones provienen de los principales fabricantes de sistemas que incluyen ASUS, Dell Technologies, GIGABYTE, Lenovo y QCT. Más de 30 presentaciones se ejecutaron en GPUs H100.

Este nivel de participación permite a los usuarios saber que pueden obtener un gran rendimiento con la IA de NVIDIA tanto en la nube como en los servidores que se ejecutan en sus propios centros de datos.

Rendimiento en todas las cargas de trabajo

Los socios del ecosistema de NVIDIA participan en MLPerf porque saben que es una herramienta valiosa para los clientes que evalúan plataformas y proveedores de IA.

Las pruebas de referencia cubren las cargas de trabajo que a los usuarios les importan: visión por computadora, traducción y aprendizaje por refuerzo, además de IA generativa y sistemas de recomendación.

Los usuarios pueden confiar en los resultados de MLPerf para tomar decisiones de compra informadas, porque las pruebas son transparentes y objetivas. Las pruebas cuentan con el respaldo de un amplio grupo que incluye Arm, Baidu, Facebook AI, Google, Harvard, Intel, Microsoft, Stanford y la Universidad de Toronto.

Los resultados de MLPerf están disponibles hoy en las plataformas H100, L4 y NVIDIA Jetson en referencia a benchmarks de entrenamiento de IA, inferencia y HPC. También realizaremos envíos en sistemas NVIDIA Grace Hopper en futuras rondas de MLPerf.

La importancia de la eficiencia energética

A medida que los requisitos de rendimiento de la IA crecen, es esencial expandir la eficiencia de cómo se logra ese rendimiento. Eso es lo que hace la computación acelerada.

Los centros de datos acelerados con GPUs NVIDIA utilizan menos nodos de servidor, por lo que ocupan menos espacio en rack y consumen menos energía. Además, la aceleración de la red mejora la eficiencia y el rendimiento, y las optimizaciones continuas del software brindan ganancias adicionales en el mismo hardware.

El rendimiento energéticamente eficiente es bueno para el planeta y los negocios. Un mayor rendimiento puede acelerar el tiempo de comercialización y permitir que las organizaciones construyan aplicaciones más avanzadas.

La eficiencia energética también reduce costos, ya que los centros de datos acelerados con GPUs NVIDIA utilizan menos nodos de servidor. De hecho, NVIDIA alimenta 22 de las 30 supercomputadoras principales en la última lista Green500.

Software disponible para todos

NVIDIA AI Enterprise, la capa de software de la plataforma de IA de NVIDIA, permite un rendimiento optimizado en una infraestructura de computación acelerada líder. El software viene con el soporte empresarial, la seguridad y la confiabilidad de grado empresarial necesarios para ejecutar la IA en el centro de datos corporativo.

Todo el software utilizado para estas pruebas está disponible en el repositorio de MLPerf, por lo que prácticamente cualquier persona puede obtener estos resultados de clase mundial.

Las optimizaciones se incorporan continuamente en los contenedores disponibles en NGC, el catálogo de software acelerado por GPU de NVIDIA.

Lea este blog técnico para profundizar en las optimizaciones que impulsan el rendimiento y la eficiencia de MLPerf de NVIDIA.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Segmentación de Imágenes Eficiente Utilizando PyTorch Parte 2

- Segmentación de Imágenes Eficiente utilizando PyTorch Parte 4

- La importancia de la reproducibilidad en el aprendizaje automático

- SiMa.ai traerá el chip de inteligencia artificial más poderoso del mundo a la India.

- Toma esto y conviértelo en una marioneta digital GenMM es un modelo de IA que puede sintetizar movimiento usando un solo ejemplo.

- Batalla de los gigantes de LLM Google PaLM 2 vs OpenAI GPT-3.5.

- Conoce Video-ControlNet Un nuevo modelo de difusión de texto a video que cambiará el juego y dará forma al futuro de la generación de video controlable.