¿Desvelando el poder de Meta’s Llama 2 ¿Un salto adelante en la IA generativa?

¿Meta's Llama 2 Un avance en la IA generativa?

Introducción

Los avances recientes en inteligencia artificial (IA), particularmente en IA generativa, han capturado la imaginación del público y demostrado el potencial de estas tecnologías para impulsar una nueva era de oportunidades económicas y sociales. Uno de estos avances es Llama 2 de Meta, la próxima generación de su modelo de lenguaje grande de código abierto.

- GPT-Engineer Tu nuevo asistente de programación de IA

- OmniSpeech se convierte en socio de software de audio de Cadence Tensilica para los algoritmos de voz de IA de próxima generación para satisfacer mejor a los clientes de automoción, móviles, consumo y IoT.

- UNESCO Expresa Preocupaciones Sobre la Implantación de Chips de IA en Relación a la Privacidad

Llama 2 de Meta se entrena con una combinación de datos de acceso público y está diseñado para impulsar aplicaciones como ChatGPT de OpenAI, Bing Chat y otros chatbots modernos. Entrenado con una combinación de datos de acceso público, Meta afirma que el rendimiento de Llama 2 ha mejorado significativamente en comparación con modelos anteriores de Llama. El modelo está disponible para ajuste fino en AWS, Azure y la plataforma de alojamiento de modelos de IA de Hugging Face en forma preentrenada, lo que lo hace más accesible y fácil de ejecutar. También puedes descargar el modelo aquí.

Pero, ¿qué diferencia a Llama 2 de su predecesor y otros modelos de lenguaje grande? Vamos a adentrarnos en sus detalles técnicos e implicaciones.

Detalles Técnicos y Rendimiento

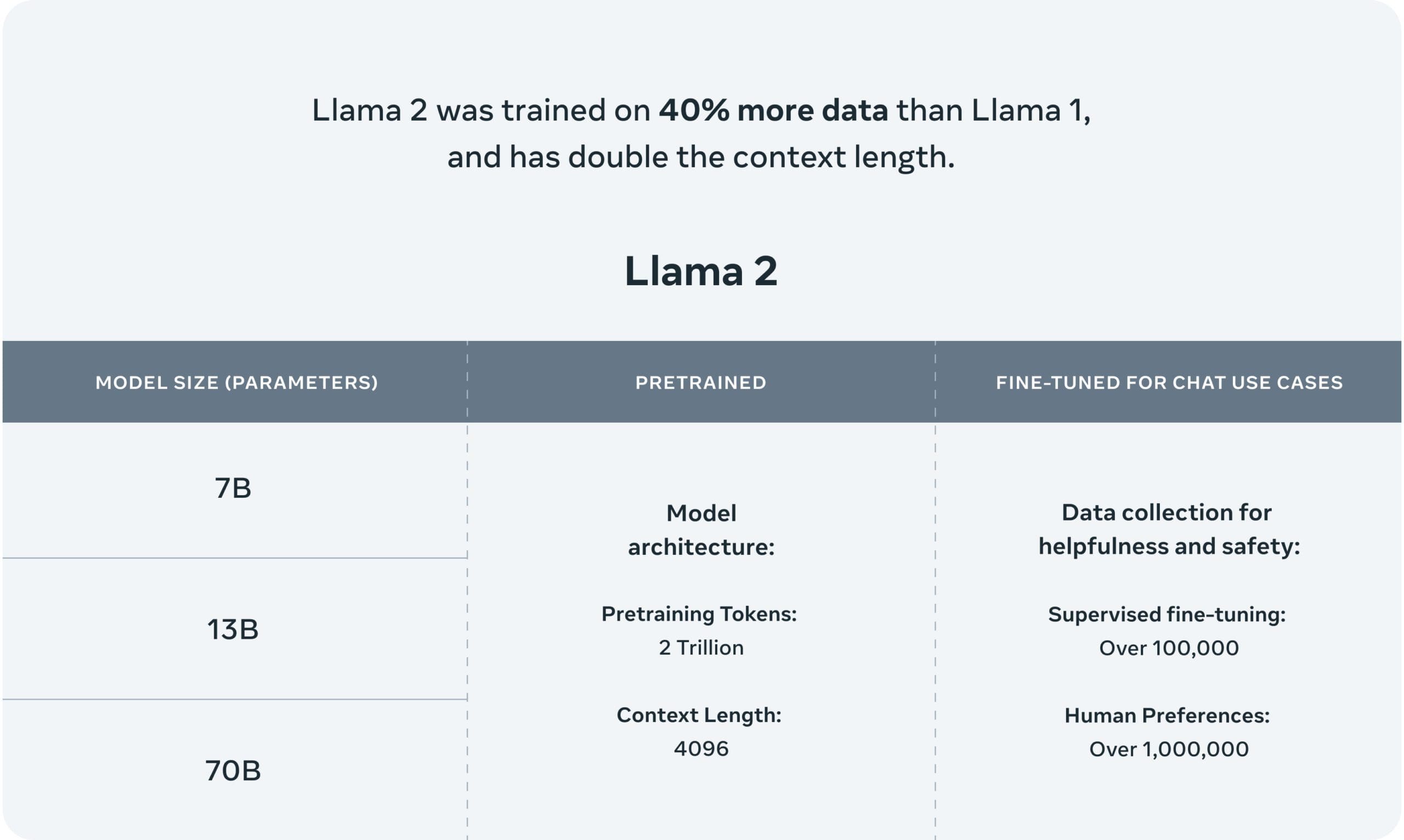

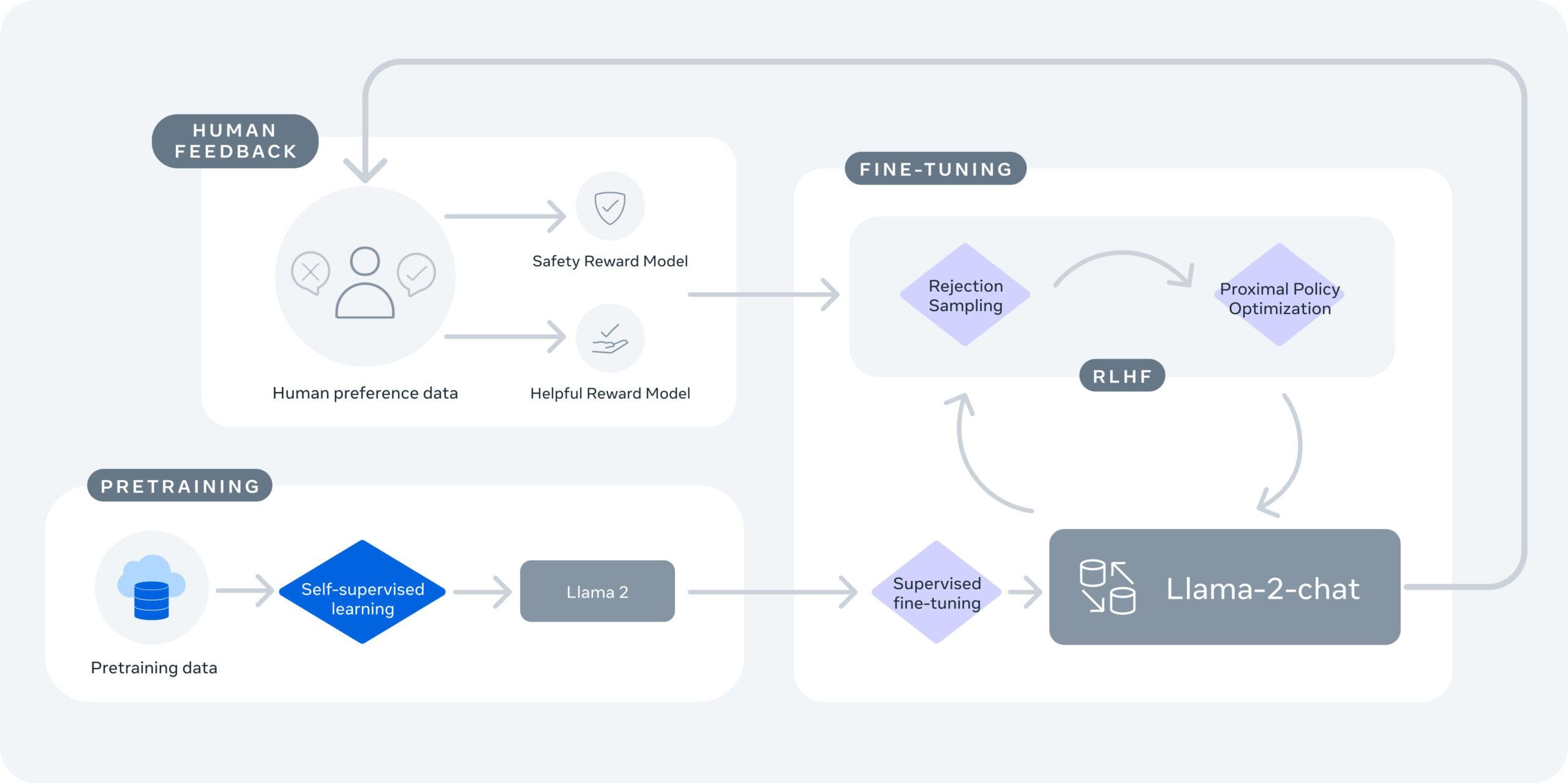

Hay dos versiones de Llama 2: Llama 2 y Llama-2-Chat. Llama-2-Chat ha sido ajustado fino para conversaciones de dos vías. Ambas versiones se dividen aún más en modelos de diferentes sofisticaciones: modelos de 7 mil millones de parámetros, 13 mil millones de parámetros y 70 mil millones de parámetros. Los modelos se entrenaron con dos billones de tokens, lo que es un 40% más que el primer modelo de Llama, e incluyen más de 1 millón de anotaciones humanas.

Llama 2 tiene una longitud de contexto de 4096 y utiliza aprendizaje por refuerzo a partir de retroalimentación humana específicamente para seguridad y utilidad en el caso del entrenamiento de Llama-Chat-2. Llama 2 supera a otros LLM, como Falcon y MPT, en áreas como razonamiento, codificación, competencia y pruebas de conocimiento, según Meta.

Además, Llama 2 está optimizado para funcionar localmente en Windows y en teléfonos inteligentes y computadoras con la tecnología Qualcomm Snapdragon en el dispositivo, lo que significa que podemos esperar aplicaciones con IA que funcionen sin depender de servicios en la nube a partir de 2024.

“Estas nuevas experiencias de IA en el dispositivo, alimentadas por Snapdragon, pueden funcionar en áreas sin conectividad o incluso en modo avión.”

—Qualcomm (fuente: CNET)

Código Abierto y Seguridad

Uno de los aspectos clave de Llama 2 es su naturaleza de código abierto. Meta cree que al poner a disposición modelos de IA de manera abierta, todos pueden beneficiarse. Este desarrollo permite tanto al mundo empresarial como al mundo de la investigación acceder a herramientas que serían prohibitivas de construir y escalar por sí mismos, lo que abre un sinfín de oportunidades para la investigación, experimentación y desarrollo.

Meta también enfatiza la seguridad y la transparencia. Llama 2 ha sido sometido a pruebas de seguridad mediante la generación de estímulos adversarios con el fin de ajustar fino el modelo, tanto internamente como externamente. Meta revela cómo se evalúan y ajustan los modelos, promoviendo la transparencia en el proceso de desarrollo.

Conclusión

Llama 2 hace todo lo posible para continuar con la perspectiva de Meta en el campo de la IA generativa. Su mejora en el rendimiento, su naturaleza de código abierto y su compromiso con la seguridad y la transparencia hacen de Llama 2 un modelo prometedor para una amplia gama de aplicaciones. A medida que más desarrolladores e investigadores tengan acceso a él, podemos esperar un aumento en soluciones innovadoras impulsadas por IA.

A medida que avanzamos, seguirá siendo crucial abordar los desafíos y sesgos inherentes a los modelos de IA. Sin embargo, el compromiso de Meta con la seguridad y la transparencia establece un precedente positivo para la industria. Con el lanzamiento de Llama 2, ahora tenemos otra herramienta disponible en nuestro arsenal de IA generativa, y una que mantiene el compromiso de acceso abierto de manera continua.

Matthew Mayo (@mattmayo13) es un científico de datos y el Editor en Jefe de VoAGI, el recurso en línea fundamental de Ciencia de Datos y Aprendizaje Automático. Sus intereses se centran en el procesamiento del lenguaje natural, el diseño y optimización de algoritmos, el aprendizaje no supervisado, las redes neuronales y los enfoques automatizados para el aprendizaje automático. Matthew tiene una maestría en ciencias de la computación y un diploma de posgrado en minería de datos. Puedes contactarlo en editor1 en VoAGI[punto]com.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Investigadores del MIT y UC Berkeley presentaron un marco de trabajo que permite a los humanos enseñar rápidamente a un robot lo que quieren que haga con un esfuerzo mínimo.

- Microsoft AI propone MM-REACT un paradigma del sistema que combina ChatGPT y expertos en visión para un razonamiento y acción multimodal avanzados.

- Conoce Automated Reasoning And Tool-Use (ART) Un marco de trabajo que utiliza modelos de lenguaje grandes congelados (LLMs) para producir rápidamente etapas intermedias en programas de razonamiento.

- Ex CEO de Google empoderará al ejército de Estados Unidos con IA y el Metaverso

- Un nuevo marco de Aprendizaje por Reforzamiento Profundo (DRL) puede reaccionar ante atacantes en un entorno simulado y bloquear el 95% de los ciberataques antes de que se intensifiquen.

- Democratización de los datos 5 estrategias de Datos para todos adoptadas por las grandes empresas

- Un nuevo artículo de IA explica los diferentes niveles de experiencia que pueden tener los modelos de lenguaje grandes como máquinas de patrones generales