Meta AI anuncia Purple Llama para ayudar a la comunidad a construir de manera ética con modelos de IA abiertos y generativos.

Meta AI presenta Purple Llama construcción ética de modelos abiertos y generativos de IA para la comunidad.

Gracias al éxito en el aumento de los datos, el tamaño del modelo y la capacidad computacional para la modelización del lenguaje auto-regresivo, los agentes de IA conversacional han experimentado un salto notable en su capacidad en los últimos años. Los chatbots a menudo utilizan modelos de lenguaje grandes (LLMs), conocidos por sus muchas habilidades útiles, como el procesamiento del lenguaje natural, el razonamiento y la competencia en herramientas.

Estas nuevas aplicaciones necesitan pruebas exhaustivas y despliegues cautelosos para reducir los posibles peligros. En consecuencia, se recomienda que los productos alimentados por IA generativa implementen salvaguardias para evitar la generación de contenido de alto riesgo que viole políticas, así como para prevenir entradas adversarias e intentos de liberación del modelo. Esto se puede ver en recursos como la Guía de Uso Responsable de Llama 2.

La API de Perspectiva1, la API de Moderación de Contenido de OpenAI2 y la API de Seguridad de Contenido de Azure3 son buenos lugares para comenzar cuando se busca herramientas para controlar el contenido en línea. Sin embargo, cuando se utilizan como barreras de entrada/salida, estas tecnologías de moderación en línea fallan por varias razones. El primer problema es que actualmente no hay forma de diferenciar entre el usuario y el agente de IA en cuanto a los peligros que representan; después de todo, los usuarios solicitan información y asistencia, mientras que los agentes de IA son más propensos a proporcionarla. Además, los usuarios no pueden cambiar las herramientas para adaptarlas a nuevas políticas porque todas tienen políticas establecidas que aplican. En tercer lugar, ajustarlos a casos de uso específicos es imposible porque cada herramienta ofrece simplemente acceso a la API. Por último, todas las herramientas existentes se basan en modelos transformadores modestos y tradicionales. En comparación con los LLMs más potentes, esto restringe severamente su potencial.

- Investigadores de Google DeepMind proponen Código de Cadena (CoC) una extensión simple pero sorprendentemente efectiva que mejora el razonamiento del Modelo de Lenguaje (LM) impulsado por código

- Enseñando a la IA a jugar juegos de mesa

- Investigadores de UCLA y CMU presentan Stormer Una red neuronal Transformadora escalable para una pronóstico meteorológico de mediano alcance hábil y confiable.

Una nueva investigación de Meta revela una herramienta para la protección de entrada y salida que categoriza los posibles peligros en las indicaciones y respuestas de los agentes de IA conversacional. Esto satisface una necesidad en el campo al utilizar LLMs como base para la moderación.

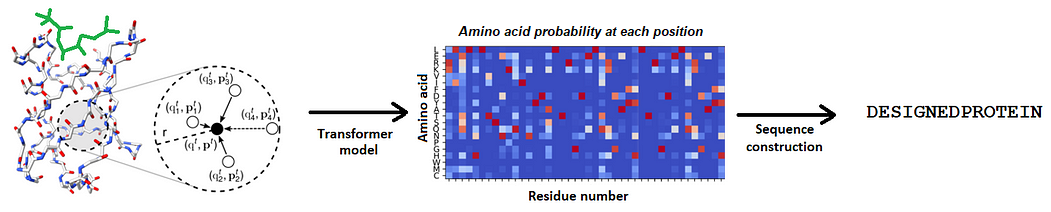

Se utiliza su base de datos basada en taxonomía para ajustar finamente a Llama Guard, un modelo de protección de entrada y salida basado en regresión logística. Llama Guard toma la taxonomía relevante como entrada para clasificar a las Llamas y aplica funciones de instrucción. Los usuarios pueden personalizar la entrada del modelo con palabras clave de cero o pocas ocurrencias para adaptarse a las diferentes taxonomías apropiadas para cada caso de uso. En el momento de la inferencia, se puede elegir entre varias taxonomías ajustadas finamente y aplicar Llama Guard en consecuencia.

Proponen directrices distintas para etiquetar la salida de LLM (respuestas del modelo de IA) y las solicitudes humanas (entrada al LLM). De esta manera, se puede capturar la diferencia semántica entre las responsabilidades del usuario y el agente de IA. Utilizando la capacidad de los modelos LLM para obedecer comandos, pueden lograr esto con solo un modelo.

También han lanzado Purple Llama. A su debido tiempo, será un proyecto paraguas que compilará recursos y evaluaciones para ayudar a la comunidad a construir de manera ética con modelos de IA generativos abiertos. La ciberseguridad y las herramientas y evaluaciones de protección de entrada/salida serán parte de la primera versión, con más herramientas por venir.

Presentan el primer conjunto completo de evaluaciones de seguridad de ciberseguridad para LLMs en la industria. Estas directrices fueron desarrolladas con la ayuda de sus especialistas en seguridad y se basan en recomendaciones y estándares de la industria (como CWE y MITRE ATT&CK). En esta primera versión, esperan ofrecer recursos que ayuden a mitigar algunos de los peligros mencionados en los compromisos de la Casa Blanca para crear IA responsable, como:

- Métricas para cuantificar las amenazas de ciberseguridad de LLM.

- Herramientas para evaluar la prevalencia de propuestas de código inseguro.

- Instrumentos para evaluar si los LLMs dificultan la escritura de código malicioso o ayudan a realizar ataques cibernéticos.

Prevén que estas herramientas reduzcan la utilidad de los LLMs para los ciberatacantes al disminuir la frecuencia con la que proponen código generado por IA inseguro. Sus estudios demuestran que los LLMs plantean problemas graves de ciberseguridad cuando sugieren código inseguro o cooperan con solicitudes maliciosas.

Todos los datos de entrada y salida al LLM deben ser revisados y filtrados de acuerdo con las restricciones de contenido específicas de la aplicación, como se especifica en la Guía de Uso Responsable de Llama 2.

Este modelo ha sido entrenado utilizando una combinación de conjuntos de datos disponibles públicamente para detectar categorías comunes de información potencialmente dañina o infractora que podría ser pertinente para diferentes casos de uso de desarrolladores. Al hacer públicos los pesos del modelo, se elimina la necesidad de que los profesionales e investigadores dependan de costosas API con ancho de banda limitado. Esto abre la puerta a más experimentación y la capacidad de adaptar Llama Guard a necesidades individuales.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Mejores funciones de manipulación de datos en PySpark

- Streaming en Ingeniería de Datos

- Acuerdo preliminar de la UE sobre la regulación de la IA Implicaciones para ChatGPT

- Investigación de Google revela Transformadores Generativos de Vocabulario Infinito (GIVT) Pioneros en secuencias de vectores de valor real en IA

- Regresando a lo humano El viaje de la IA desde el código hasta los abrazos

- Rastreando la memoria de la sesión de Python usando Tracemem

- Potenciando la fiabilidad del aprendizaje automático Cómo la atipicidad mejora el rendimiento del modelo y la cuantificación de la incertidumbre