Los investigadores de la Universidad de Pennsylvania presentaron un enfoque alternativo de IA para diseñar y programar computadoras de depósito basadas en RNN.

Investigadores de la Universidad de Pennsylvania presentaron un enfoque de IA alternativo para diseñar y programar computadoras de depósito basadas en RNN.

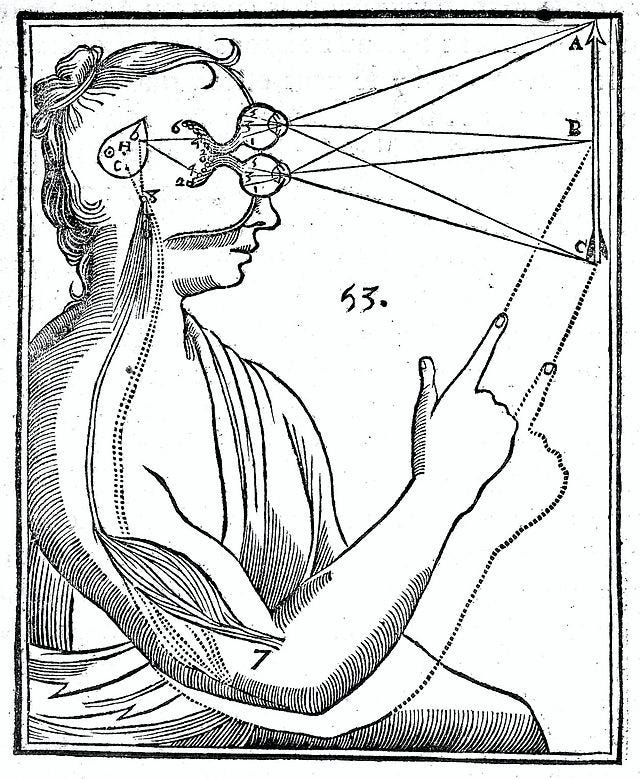

El cerebro humano es uno de los sistemas más complejos que la naturaleza ha creado. Los neuronas interactúan entre sí formando enlaces neurales recurrentes y transmitiendo información a través de impulsos. Debido a sus increíbles métodos de razonamiento lógico y análisis numérico, los investigadores intentan implementar estos métodos biológicos de redes neuronales en los sistemas neurales artificiales actuales. Los métodos de computación neuronal implican las RNN en sistemas dinámicos y réplicas neurales de arquitecturas informáticas en el aprendizaje automático.

El grupo de investigación afirma que los avances en la tecnología actual de redes neuronales podrían permitir la ejecución neural distribuida completa de la virtualización de software y los circuitos lógicos. Esto se lograría sin la necesidad de datos de ejemplo o muestreo del espacio de estados, que generalmente se requieren para entrenar y refinar estas redes neuronales. Esencialmente, esto sugiere la posibilidad de una aplicación más eficiente y robusta de la inteligencia artificial en áreas como la virtualización y el diseño de circuitos digitales.

El acceso actual a la computación neuronal está limitado debido a la necesidad de comprender la relación entre las computadoras neuronales y las computadoras de silicio modernas. Esto requiere una red neuronal con un conjunto simple de ecuaciones que gestionen muchas capacidades similares a las de una computadora. Como consecuencia del conjunto simple de ecuaciones, se comprenden bien teóricamente redes como el ordenador de depósito (RC), que es una red neuronal recurrente (RNN). Al recibir las entradas, estas evolucionan como un conjunto de estados internos, y la salida es una suma ponderada de esos estados.

- Red Neuronal Recurrente con Puertas desde Cero en Julia

- 8 Razones por las que no renuncié a mi sueño de ser un científico de datos y por qué tú tampoco deberías hacerlo

- CarperAI presenta OpenELM una biblioteca de código abierto diseñada para permitir la búsqueda evolutiva con modelos de lenguaje tanto en código como en lenguaje natural.

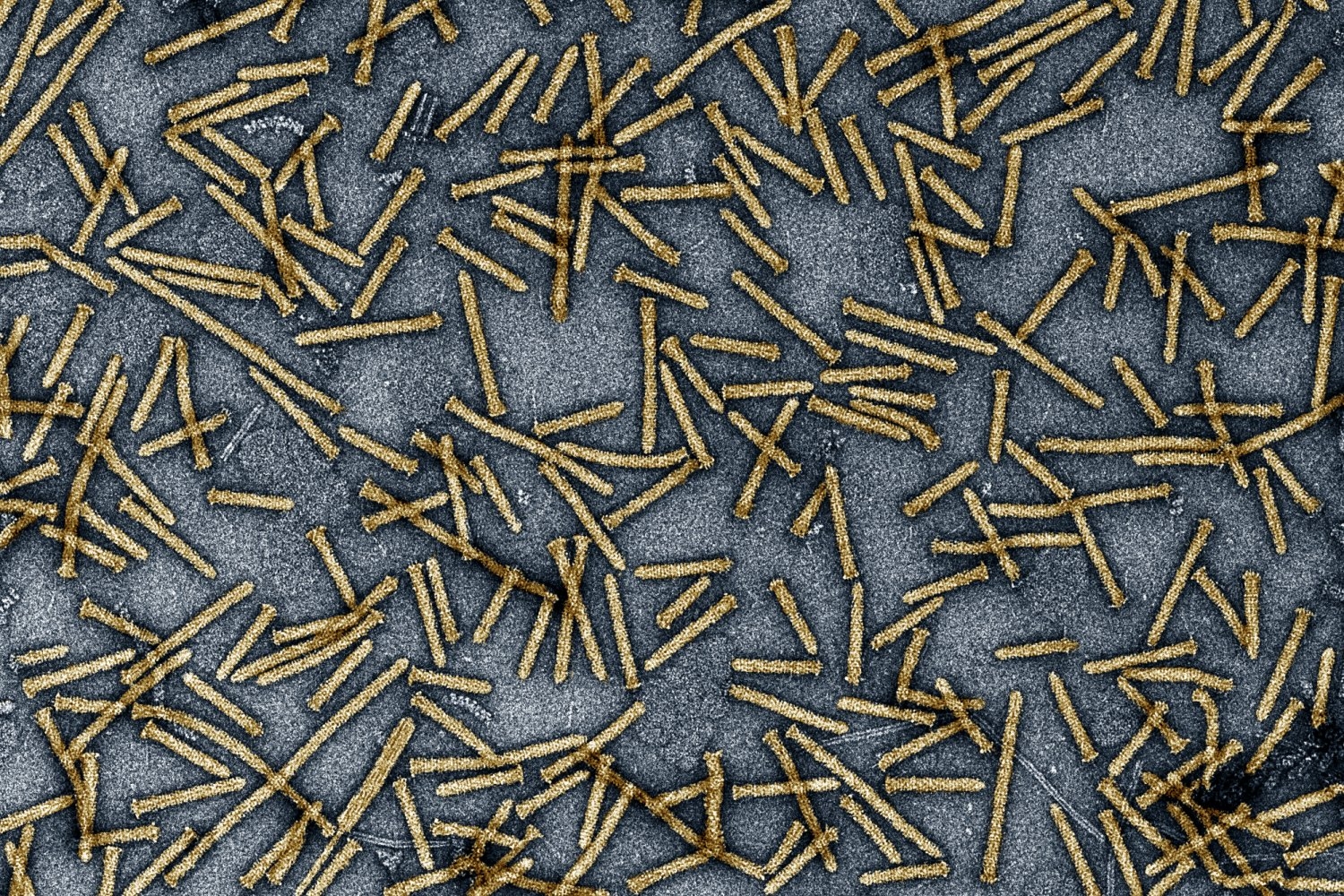

El equipo de investigación de la Universidad de Pennsylvania desarrolló dos marcos llamados programación neural de estado (SNP) y programación neural dinámica (DNP). Se utiliza SNP para resolver ecuaciones analíticas y realizar operaciones con RCs. Se utiliza DNP para programar RCs para almacenar sistemas dinámicos caóticos como memorias de acceso aleatorio, implementando la lógica neural AND, NAND, OR, NOR, XOR y XNOR.

A través de la “arquitectura de bucle abierto con SNP”, los investigadores obtuvieron una matriz de programación con potencias polinómicas de entradas con retraso de tiempo, que se puede utilizar en operaciones como un filtro pasaaltos. Para resolver algoritmos, se utiliza la “arquitectura de bucle cerrado con SNP” en la que se programa una RNN para almacenar el historial de tiempo sustancial de una serie temporal estocástica y no diferenciable, y se realiza una transformada de Fourier de tiempo corto.

La simulación y virtualización requieren la programación del historial de tiempo para RNN de tiempo continuo, por lo que se implementa una RNN de bucle cerrado con el método DNP. Los investigadores intentaron emular la dinámica de la retroalimentación de una RNN de host de 2000 estados y una RNN de invitado de 15 estados. Descubrieron que solo se estaba simulando un atractor de Lorentz caótico sin ninguna muestra. Esto concluye que:

Los investigadores han descubierto que se puede programar completamente un marco de computación alternativo, lo que desafía los enfoques actuales que imitan el hardware de silicio. En cambio, proponen centrarse en la creación de sistemas de programación específicos que maximicen las capacidades computacionales completas de cada sistema único.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Productividad impulsada por IA la IA generativa abre una nueva era de eficiencia en todas las industrias

- La evolución automatizada aborda tareas difíciles

- La IA está haciendo que la política sea más fácil, más barata y más peligrosa

- La FTC investiga si ChatGPT perjudica a los consumidores

- Investigadores cultivan matrices precisas de nanoLEDs

- Calculadora de números determina si las ballenas están actuando de manera extraña

- Los robots de IA podrían desempeñar un papel futuro como compañeros en hogares de cuidado