¿Qué es la innatismo y importa para la inteligencia artificial? (Parte 2)

Innatismo y su importancia para la IA (Parte 2)

La cuestión de la innatitud, tanto en biología como en inteligencia artificial, es fundamental para el futuro de la IA similar a la humana. Esta inmersión profunda en dos partes sobre el concepto y su aplicación puede ayudar a despejar el aire.

Por Vincent J. Carchidi

(Esto es una continuación de una serie de dos partes sobre la innatitud en biología y en inteligencia artificial. La primera parte se puede encontrar aquí.)

Innatitud en la Inteligencia Artificial

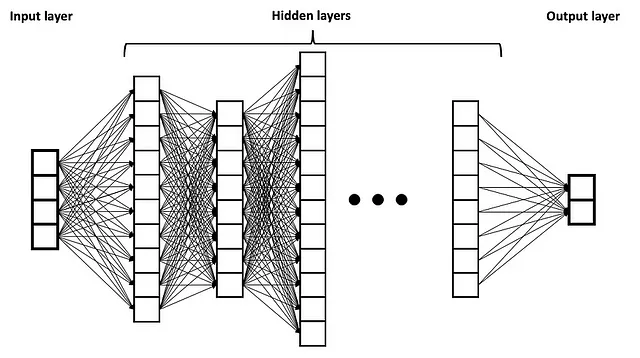

La revolución del aprendizaje profundo ha venido acompañada de un cambio en la relación entre la IA y el estudio de la mente humana. Las redes neuronales artificiales (ANNs, por sus siglas en inglés) se inspiraron originalmente, de manera vaga, en las interconexiones masivas de neuronas en los cerebros de mamíferos. Si bien el ejemplo típico utilizado para audiencias amplias es una red de alimentación directa simplista, en la que hay una capa de entrada, capas ocultas en el medio y luego una capa de salida a través de la cual la información fluye solo en una dirección, las redes neuronales profundas (DNNs) que poseen cientos de estas capas ocultas se han vuelto más “internamente heterogéneas” que sus predecesoras más superficiales (como se muestra a continuación).

- Hacia una IA de nivel Dios desde una IA de nivel Perro

- ¿Dónde ocurre la IA?

- Revolucionando el Desarrollo de Software La Dupla Dinámica de la IA y el Código

Fuente: Wikimedia Commons con licencia Creative Commons Attribution-Share Alike 4.0 International.

Con el tiempo, sin embargo, se produjo un cambio en la idea en el discurso popular de IA: que el cerebro humano en realidad es como las DNNs. El cambio de la inspiración biológica para las ANNs a los cerebros biológicos que están al mismo nivel que las DNNs no es solo una peculiaridad lingüística, sino que revela tanto una comprensión sofisticada de la innatitud en las mentes humanas como una interdisciplinariedad adecuada en el estudio de la IA. A pesar de sus méritos, la revolución del aprendizaje profundo trajo consigo una tendencia a reducir los estándares de rigor necesarios para comprender la única categoría de ejemplos que tenemos de inteligencia: la inteligencia biológica (una falta de marco cognitivo recientemente lamentada por Peter Voss como un obstáculo en el camino hacia la inteligencia artificial general, o AGI).

No es sorprendente, entonces, que figuras como Gary Marcus expresen una frustración repetida con los investigadores de aprendizaje automático que parecen resistirse a la idea de construir sistemas altamente estructurados, especificados con un nivel significativo de conocimiento específico del dominio. Marcus es, después de todo, un psicólogo cognitivo de profesión. Y no es sorprendente que el único debate público entre Gary Marcus y Yann LeCun en 2017 se centrara en la pregunta: “¿Necesita la IA más maquinaria innata?”

Pero esto fue en la era previa a los modelos de lenguaje grandes (LLM). Más recientemente, en junio de 2022, Yann LeCun y Jacob Browning, argumentando que podemos aprender cosas nuevas sobre la inteligencia humana a través de la IA, afirman que los LLMs han aprendido a manipular símbolos, “mostrando cierto nivel de razonamiento de sentido común, composicionalidad, competencia multilingüe, algunas habilidades lógicas y matemáticas e incluso capacidades inquietantes para imitar a los muertos”. La trampa: “no lo hacen de manera confiable”. Desde entonces, LeCun ha expresado su pesimismo sobre los LLMs en la búsqueda de AGI, pero no ha conectado esto claramente, al menos, con el pesimismo sobre el aprendizaje profundo en sí mismo (sin importar las confusiones que uno tenga sobre las posiciones de LeCun, este último sigue siendo algo así como un empirista, aunque no radical).

La falta de confiabilidad no ha sido un obstáculo para otros que se inclinan hacia la idea de que los LLMs pueden contribuir a los debates sobre la innatitud en los humanos. El lingüista Steven Piantadosi escribió un artículo altamente difundido argumentando que el éxito de los LLMs “socava prácticamente todas las afirmaciones fuertes sobre la innatitud del lenguaje propuestas por la lingüística generativa” (p. 1). Caracteriza a los LLMs como “científicos automatizados o lingüistas automatizados, que también trabajan en espacios relativamente no restringidos, buscando encontrar teorías que hagan el mejor trabajo de predecir de manera parsimoniosa los datos observados” (p. 19).

Si el argumento de Piantadosi fuera al menos parcialmente correcto y los LLMs de alguna manera explicaran cómo los humanos adquieren lenguajes naturales, esto tendría una influencia directa en la necesidad (o falta de ella en este caso) de innatitud para la inteligencia biológica y artificial. Sin duda, otros han puesto en duda el argumento. El lingüista Roni Katzir, al probar él mismo GPT-4, encuentra que el sistema no logra demostrar que está “adecuadamente sesgado” (p. 2) hacia las restricciones establecidas en el uso del lenguaje humano, argumentando que no modelan tanto la cognición lingüística humana como el texto lingüístico. Él sostiene que sería extraño esperar incluso que los LLMs expliquen la adquisición del lenguaje humano dada la diferencia de propósitos detrás de su diseño. Los investigadores Jon Rawski y Lucie Baumont argumentan sin rodeos que el argumento de Piantadosi es falaz, además de dar prioridad al poder predictivo sobre el poder explicativo.

IA de juego como ventanas hacia la inteligencia artificial general

En muchos aspectos, el debate sobre la innatitud en la IA en contraste con los humanos es una rareza. Si bien el aprendizaje automático a menudo ha visto un esfuerzo por minimizar la cantidad de componentes innatos necesarios para que un sistema tenga éxito, el debate asume que los éxitos de la era del aprendizaje profundo son una especie de racha de empirismo. La innatitud ha sido importante para el campo en formas relevantes para la búsqueda de la IA general. El problema es que cuando la innatitud es un factor en sistemas exitosos, a menudo se minimiza o se ignora, y la importancia conceptual de los avances se pierde incluso para aquellos que los promueven más.

Ningún lugar esto es más evidente que en las IA de juego. Una de las cosas más desconcertantes sobre el artículo de investigación que acompaña a AlphaGo Zero fue la insistencia de los autores en que el sistema comienza a aprender a jugar al Go desde un estado de “tabula rasa”. Por supuesto, AlphaGo Zero es notable por lograr un rendimiento sobrehumano en el Go a través del aprendizaje por refuerzo mediante el autojuego, pero fue Gary Marcus quien explicó detalladamente cuánto contenido incorporado —es decir, innato, antes de aprender algo sobre el Go— poseía AlphaGo Zero.

De hecho, el conocimiento del dominio utilizado por AlphaGo Zero es el siguiente, extraído directamente del artículo de investigación de 2017 (p. 360):

(1) Conocimiento perfecto de las reglas del juego utilizadas durante la búsqueda del árbol de Monte Carlo (MCTS).

(2) El uso de la puntuación de Tromp-Taylor durante las simulaciones de MCTS y el entrenamiento mediante autojuego —esto es una lista de 10 reglas lógicas que especifican varias características del juego, incluyendo la cuadrícula de 19×19, las piedras negras y blancas, qué cuenta como “limpiar” un color, y así sucesivamente.

(3) Las características de entrada que describen la posición se estructuran como una imagen de 19×19; “es decir, la arquitectura de la red neuronal se adapta a la estructura de la cuadrícula del tablero”.

(4) “Las reglas del Go son invariantes bajo rotación y reflexión” —esta extraña formulación significa dos cosas: que el conjunto de datos se aumentó durante el entrenamiento “para incluir rotaciones y reflexiones de cada posición” y que “rotaciones o reflexiones aleatorias de la posición durante el MCTS” se muestrearon utilizando un algoritmo específico.

Al igual que un individuo humano no puede enmarcar el mundo en términos morales sin una capacidad moral distintiva incorporada desde el principio, AlphaGo Zero no podría ni siquiera reconocer el tablero de Go, las piedras, los movimientos tanto del tablero como de las piedras, y las reglas del juego sin este don innato. Además de esto, como señala Marcus, el aparato MCTS no se aprendió de los datos, sino que se programó desde el principio, y la elección de qué aumentos incluirse “se hizo con conocimiento humano, en lugar de aprender” (p. 8).

Describir a AlphaGo Zero como una pizarra en blanco porque se entrena mediante aprendizaje por refuerzo mediante autojuego es enormemente engañoso y no fue una victoria del empirismo. Más bien, como explica correctamente Marcus, es una “ilustración… del poder de construir las cosas adecuadas desde el principio… La convolución es el prerrequisito que ha hecho que el campo del aprendizaje profundo funcione; la búsqueda por árbol ha sido vital para jugar juegos. AlphaZero ha combinado las dos” (p. 8-9). De hecho, al igual que los juicios morales humanos resultan de un proceso estructurado en la mente que se basa principalmente en un sistema dedicado a las intuiciones morales mientras se interactúa con otros sistemas, AlphaGo Zero no podría manejar la complejidad del Go simplemente dejando caer uno de sus componentes innatos. Y, como señalan Artur d’Avila Garcez y Luís C. Lamb, MCTS es un solucionador simbólico de problemas, lo que hace que su acoplamiento con la red neuronal de AlphaGo Zero sea un elemento de IA neuro-simbólica.

Este aspecto combinatorio del don innato de AlphaGo Zero es lo que lo hace tan impresionante y debemos apreciar su conocimiento incorporado antes del entrenamiento, así como la maravilla del entrenamiento en sí.

Las elecciones de diseño únicas y combinatorias que estructuran ricamente el sistema para un problema específico a menudo son responsables de los mayores éxitos de las IA de juego, aunque técnicas como el aprendizaje por refuerzo y el autojuego se inflan en los comentarios a expensas de estas elecciones. Esto es especialmente evidente en “Cicero” de Meta, el agente que juega a Diplomacy cuyo trueno fue robado al ser lanzado ocho días antes que ChatGPT.

Cicero, el primer agente en alcanzar un rendimiento a nivel humano —no sobrehumano— en Diplomacy, ejemplifica estos elementos combinatorios de dos maneras: en primer lugar, a un nivel alto, el sistema combina el razonamiento estratégico y la comunicación en lenguaje natural durante el juego. En segundo lugar, la arquitectura del sistema depende de una combinación de investigación y técnicas extraídas de áreas que incluyen el razonamiento estratégico, el procesamiento del lenguaje natural y la teoría de juegos. El resultado, como describen Gary Marcus y Ernest Davis, es “una colección de algoritmos altamente complejos e interactivos”.

Para tener éxito en Diplomacia, los jugadores deben emplear un razonamiento estratégico mientras buscan adquirir la mayoría de los centros de suministro en el mapa. Este elemento del juego, que incorpora habilidad táctica de un movimiento al siguiente en servicio de un objetivo general, es similar a otros juegos como el Ajedrez, Go y el Póker, cada uno de los cuales, a estas alturas, ha sido dominado de una manera u otra por la IA. Lo que diferencia a la Diplomacia es que los jugadores pasan mucho tiempo negociando entre sí en diálogos basados en texto abiertos o verbales.

Suena bastante simple, ¿verdad? Los jugadores negocian entre sí para obtener resultados favorables, fácil. Pero no lo es. Recuerda, hay una tendencia a subestimar la complejidad tanto de las situaciones a las que responden nuestros juicios morales como de los juicios en sí. La Diplomacia puede ser engañosa de manera análoga si no la observamos desde la distancia. Alinear las capacidades de razonamiento estratégico de un agente con la comunicación en lenguaje natural es enormemente complejo.

La arquitectura de Cicero se puede dividir en un motor de planificación y un agente de diálogo. El motor de planificación es responsable del razonamiento estratégico, mientras que el agente de diálogo maneja la comunicación en lenguaje natural. Crucialmente, estas dos divisiones están mediadas por un mecanismo altamente específico (un “modelo de acción condicionado por el diálogo”), y el agente de diálogo es controlado por el motor de planificación. Esta estructura de alto nivel asegura que el motor de planificación pueda generar intenciones que luego se utilizan para construir los objetivos del agente. Esta información se alimenta luego al agente de diálogo para que la generación de mensajes entre Cicero y otros jugadores se mantenga alineada con los objetivos estratégicos del agente. Aunque Cicero a veces se contradice a sí mismo, sus diseñadores informan que ningún humano identificó al agente como una IA durante el juego anónimo y multijugador, lo que destaca el éxito similar al de un humano del sistema.

La estructura de nivel inferior tiene su propia peculiaridad. Uno podría sospechar que, dado el éxito de AlphaGo Zero a través del autoaprendizaje, un agente de Diplomacia también debería entrenarse con esta técnica. Pero, la investigación previa a Cicero encontró que entrenar a un agente de Diplomacia sin datos humanos llevaba a un juego relativamente pobre contra humanos.

Tampoco es particularmente útil aquí el algoritmo de búsqueda de árbol de Monte Carlo (MCTS, por sus siglas en inglés). Aunque MCTS se había probado en Diplomacia antes de Cicero (según mi conocimiento, principalmente en el aspecto estratégico del juego, no tanto en el aspecto de negociación), las diferencias entre Go y Diplomacia lo hacen menos efectivo. Go es un juego asíncrono en el que los jugadores toman sus turnos uno a la vez, transmitiendo toda la información relevante en el tablero para cuando el siguiente jugador se mueve. La Diplomacia es simultánea: los jugadores negocian y luego ingresan sus acciones de forma privada, que se revelan a todos simultáneamente. MCTS no puede lidiar bien con esta estructura.

Esto es lo que hizo el equipo de Meta AI en su lugar: basándose en investigaciones previas en IA que juegan Diplomacia, construyeron un algoritmo llamado “piKL” (pronunciado de forma aceptable como “pickle”). piKL está diseñado para “interpolarse” entre la necesidad de buscar estrategias novedosas e imitar a los humanos. Este algoritmo es fundamental para el motor de planificación. Siguiendo la investigación realizada para el agente de póker Libratus, Meta AI informa que “piKL trata cada turno en Diplomacia como su propio subjuego…”

Además, un modelo generativo de lenguaje grande (LLM, por sus siglas en inglés) respalda al agente de diálogo. Este LLM se ajustó en función de diálogos de juego existentes. Sin embargo, los modelos de lenguaje están desconectados del contexto del mundo de la Diplomacia y, por lo tanto, generan resultados inconsistentes con los objetivos estratégicos del agente (además de ser fácilmente manipulables por los humanos). Para solucionar esto, algunos mensajes humanos en los que se entrenó se etiquetaron con acciones propuestas, que representan las intenciones de los jugadores. El modelo de lenguaje se condicionó a estas intenciones.

Podemos empezar a ver cómo todo esto encaja. Durante el juego, el motor de planificación selecciona las intenciones relevantes para controlar el modelo de lenguaje. Este control se basa en acciones verídicas para el sistema y acciones mutuamente beneficiosas para el destinatario de la comunicación (el sistema modela acciones para cada jugador).

Implicaciones

Cicero es una proeza en ingeniería. Además, es uno de los ejemplos más destacados de un sistema de IA que logra una hazaña distintivamente humana con un rico y altamente estructurado conjunto de conocimientos en el dominio. Estos componentes internos se interfazan de manera relativamente productiva en la alineación del razonamiento estratégico y la comunicación en lenguaje natural. Marcus y Davis fueron algunos de los pocos que reconocieron inmediatamente la importancia de este sistema más allá del juego de Diplomacia: “Si Cicero sirve como guía, el aprendizaje automático podría resultar aún más valioso si se incorpora en sistemas altamente estructurados con una cantidad considerable de maquinaria innata, a veces neurosimbólica”.

Sin embargo, muchos en IA creen que esto pasa por alto el punto: sí, la inteligencia biológica puede tener todo tipo de características innatas, pero los sistemas de inteligencia artificial pueden no necesitarlas. La idea es que hay otras formas de realizar un comportamiento inteligente diferentes a las formas en que los humanos lo hacen. Solo basta con ver a AlphaGo Zero: este sistema, cuyos componentes internos son comparativamente más simples que el cerebro humano, juega al Go mejor que cualquier humano en el mundo. ¿Por qué centrarse en agregar más cosas innatas a dicho sistema cuando ya hace su trabajo tan bien? Y ¿por qué no tratar de minimizar el número de componentes en funcionamiento en Cicero mientras estamos en ello?

Este interlocutor hipotético no ve el bosque por los árboles. Como explica Marcus en su artículo de 2018: “mientras que un humano puede aprender muchos juegos sin características representativas innatas específicas para ningún juego en particular, cada implementación de [AlphaGo Zero] está dotada innatamente de características específicas del juego que encierran el sistema en una realización particular de un juego particular, enfocándose en un problema particular. Los humanos son mucho más flexibles en cómo abordan los problemas” (p. 9).

El salto de la IA “estrecha” a la IA “general” está directamente relacionado con el problema de la innatitud. Y la inteligencia biológica muestra por qué: si bien es cierto que ningún individuo humano puede jugar al Go al nivel de AlphaGo Zero (asumiendo que no se replique algo como KataGo vs. Kellin Pelrine con AlphaGo Zero), el sistema no podría haber llegado a este punto sin una estructura innata altamente específica, de la misma manera que el juicio moral humano adquiere su carácter específico debido a nuestra estructura innata.

Las ideas de la biología sobre la IA van más allá de esto. Los AIs de juegos a menudo son notables porque permiten a los investigadores probar técnicas en entornos donde hay objetivos bien definidos (es decir, condiciones claras para la victoria) junto con restricciones estables (es decir, las reglas del juego, el tablero en el que se juega, el número de jugadores, etc.). Estos juegos son explotaciones aisladas de las habilidades cognitivas humanas, incluida la destreza táctica, el razonamiento estratégico, la comunicación en lenguaje natural, el engaño, la cooperación y la colaboración, y la honestidad y la deshonestidad, entre otros.

El problema es que AlphaGo Zero, Cicero y otros AIs de juegos no están haciendo lo mismo que nosotros cuando jugamos al Go, Diplomacy o cualquier otro juego de estrategia. Como señala el interlocutor, encuentran formas diferentes de tener éxito: AlphaGo Zero puede jugar contra sí mismo millones de veces con un algoritmo de búsqueda cuidadosamente mejorado diseñado especialmente para el Go; Cicero puede negociar sin la sensación de traición que guíe sus acciones con un conocimiento sustancial de “metajuego”. Pero AlphaGo Zero no puede idear estrategias fuera del Go, ni siquiera reconocer un tablero de Go que no cumpla con las dimensiones exactas para las que fue programado innatamente reconocer; Cicero no puede negociar fuera de Diplomacy porque no sabe cómo leer intenciones tanto como optimiza los acuerdos que cada uno encontraría aceptables.

Y aquí radica el problema: cuando los humanos idean estrategias en el Go, pueden poner esta habilidad en práctica en cualquier otro juego o contexto; cuando los humanos leen intenciones en Diplomacy, pueden utilizar esa misma capacidad cognitiva en cualquier lugar fuera del juego con flexibilidad y solidez, ya sea en diplomacia cara a cara real o en una conversación casual.

El punto central es el siguiente:

Las formas “diferentes” en que los AIs utilizan para tener éxito en los juegos de manera superior a los humanos mientras permanecen confinados a estos dominios se deben al poder de su estructura innata. Se necesitará un nuevo tipo de estructura innata que se mezcle con los elementos exitosos del aprendizaje profundo para dar el salto de la IA estrecha a la IA general.

Conclusión

La idea de la innatitud, en mi experiencia, molesta a las personas. Pero lo interesante no es que a las personas les moleste la idea de que los brazos, las piernas, los sistemas circulatorios o las médulas espinales humanas sean innatos, porque no lo son. Más bien, a las personas les molesta la idea de que las facultades de orden superior de la mente sean innatas, como los valores morales, los idiomas, el sentido musical y cosas similares.

Este doble estándar se ha identificado como un obstáculo potencial en las ciencias cognitivas y neurociencias, un sesgo implícito de cierta manera, que he argumentado que probablemente sea responsable de alguna de la resistencia a la innatitud en la IA. La “fetichización” del aprendizaje de extremo a extremo de la que tuiteó Rodney Brooks puede ser, en parte, el resultado de este extraño doble estándar que simplemente se ha infiltrado en la IA, en lugar de ser único en el campo.

Pero identificarlo solo aumenta las apuestas al ilustrar por qué las separaciones claras entre la ingeniería y la ciencia en el esfuerzo por construir una IA similar a la humana, o la AGI misma, no serán suficientes en el futuro. La mentalidad que dice “Veamos qué funciona y qué no funciona” tiene tremendas ventajas creativas, pero la IA similar a la humana es una montaña demasiado alta para eso solo. La IA similar a la humana es, como se ilustra, probablemente una serie de problemas de investigación bien estructurados que no pueden darse el lujo de dar por sentadas suposiciones implícitas sobre la biología y la cognición en humanos o animales.

Referencias:

[1] B. Alloui-Cros, Dominando tanto la pluma como la espada? Cicero en el juego de Diplomacy (2023), Substack

[2] A. Bakhtin, et al., Diplomacia sin prensa desde cero (2021), ArXiv

[3] N. Brown y T. Sandholm, Superhuman AI para Heads-Up No-Limit Poker (2017), Ciencia

[4] V.J. Carchidi, ¿Los submarinos nadan? (2022), AI & Society

[5] N. Chomsky, Naturalismo y dualismo en el estudio del lenguaje y la mente (1994), International Journal of Philosophical Studies

[6] D. Silver, et al., Dominando el juego de Go sin conocimiento humano (2017), Nature

[7] G. Dupre, (¿Qué) puede contribuir el aprendizaje profundo a la lingüística teórica? (2021), Minds and Machines

[8] A. Garcez y L. Lamb, Neurosimbólica IA: La tercera ola (2023), Artificial Intelligence Review

[9] M. Holmes, Diplomacia cara a cara (2018), Cambridge University Press

[10] A.P. Jacob, et al., Modelando una jugabilidad fuerte y similar a la humana con búsqueda regularizada de KL (2021), ArXiv

[11] R. Katzir, ¿Por qué los modelos de lenguaje grandes son malas teorías de la cognición lingüística humana? Una respuesta a Piantadosi (2023), LingBuzz

[12] G. Marcus y E. Davis, ¿Qué significa para la IA el éxito de Diplomacy-Winning Cicero de Meta AI? (2022), Communications of the ACM

[13] G. Marcus, Innatismo, AlphaZero e Inteligencia Artificial, ArXiv

[14] Equipo de Investigación Fundamental de IA de Meta (FAIR), et al., Juego a nivel humano en el juego de Diplomacy combinando modelos de lenguaje con razonamiento estratégico (2022), Ciencia

[15] S. Piantadosi, Los modelos de lenguaje modernos refutan el enfoque de Chomsky sobre el lenguaje (2023), LingBuzz

[16] J. Rawski y L. Baumont, Los modelos de lenguaje modernos no refutan nada (2023), LingBuzz

[17] A. Theodoridis y G. Chalkiadakis, Búsqueda de árbol de Monte Carlo para el juego de Diplomacy (2020), 11th Hellenic Conference on Artificial Intelligence

[18] S. Ullman, Utilizando la neurociencia para desarrollar inteligencia artificial (2019), Ciencia

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Microsoft AI Research presenta un nuevo marco de aprendizaje profundo llamado Distributional Graphormer (DiG) para predecir la distribución de equilibrio de sistemas moleculares.

- ChatGPT obtiene una puntuación en el 1% superior en la prueba de creatividad humana

- Una forma sencilla de mejorar las entrevistas de ciencia de datos

- Este documento de IA evalúa la capacidad de los LLM para adaptarse a nuevas variantes de tareas existentes

- Optimizando el rendimiento de las máquinas virtuales de Azure mientras se reducen los costos Estrategias probadas para una eficiencia óptima

- Uplift Modeling – Una guía para científicos de datos sobre cómo optimizar una campaña de renovación de tarjetas de crédito

- Conoce DeepOnto Un paquete de Python para la ingeniería de ontologías con Aprendizaje Profundo