Descenso del Gradiente La Guía del Excursionista de Montaña para la Optimización con Matemáticas

Descenso del Gradiente La Guía del Excursionista de Montaña para Optimizar con Matemáticas

La analogía del excursionista de montaña:

Imagínate que eres un excursionista de montaña, parado en alguna parte de las laderas de una vasta cadena montañosa. Tu objetivo es llegar al punto más bajo del valle, pero hay un problema: estás vendado. Sin la capacidad de ver el paisaje completo, ¿cómo encontrarías el camino hacia abajo?

Instintivamente, quizás sientas el terreno a tu alrededor con tus pies, percibiendo qué camino está cuesta abajo. Luego darías un paso en esa dirección, el descenso más empinado. Repitiendo este proceso, te acercarías gradualmente al punto más bajo del valle.

- Repositorios de IA más populares en GitHub Semana del 16 de octubre de 2023

- Una guía completa para usar cadenas en Langchain

- Más consejos para navegar con éxito las entrevistas de trabajo de ciencia de datos para principiantes

Traduciendo la analogía a Gradient Descent

En el ámbito del aprendizaje automático, el viaje de este excursionista refleja el algoritmo de descenso de gradiente. Esto es cómo:

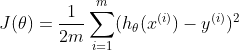

1) El paisaje: El terreno montañoso representa nuestra función de costo (o pérdida),

J(θ). Esta función mide el error o discrepancia entre las predicciones de nuestro modelo y los datos reales. Matemáticamente, se podría representar como:  donde

donde

m es el número de puntos de datos, hθ(x) es la predicción de nuestro modelo, y

y es el valor actual.

2) La posición del excursionista: Tu posición actual en la montaña corresponde a los valores actuales de los parámetros del modelo, θ. A medida que te mueves, estos valores cambian, alterando las predicciones del modelo.

3) Sintiendo el terreno: Al igual que tú sientes el descenso más empinado con tus pies, en el descenso de gradiente, calculamos el gradiente,

∇J(θ). Este gradiente nos indica la dirección del aumento más pronunciado en nuestra función de costo. Para minimizar el costo, nos movemos en dirección opuesta. El gradiente viene dado por:  Donde:

Donde:

m es el número de ejemplos de entrenamiento.

ejemplo de entrenamiento.

ejemplo de entrenamiento.

4) Pasos: El tamaño de los pasos que das es análogo a la tasa de aprendizaje en el descenso de gradiente, denotada por ?. Un paso grande podría ayudarte a descender más rápido, pero corres el riesgo de pasar por alto el fondo del valle. Un paso más pequeño es más cauteloso, pero podría llevar más tiempo alcanzar el mínimo. La regla de actualización es:

5) Alcanzar el fondo: El proceso iterativo continúa hasta que llegues a un punto donde no sientas ningún descenso significativo en ninguna dirección. En el descenso de gradiente, esto ocurre cuando el cambio en la función de costo se vuelve insignificante, lo que indica que el algoritmo ha encontrado (esperemos) el mínimo.

En conclusión

El descenso de gradiente es un proceso metódico e iterativo, similar a nuestro excursionista vendado tratando de encontrar el punto más bajo del valle. Al combinar intuición con rigor matemático, podemos comprender mejor cómo los modelos de aprendizaje automático aprenden, ajustan sus parámetros y mejoran sus predicciones.

Descenso de gradiente en lote (Batch Gradient Descent)

El descenso de gradiente en lote calcula el gradiente utilizando todo el conjunto de datos. Este método proporciona una convergencia estable y un gradiente de error consistente, pero puede ser computacionalmente costoso y lento para conjuntos de datos grandes.

Descenso de gradiente estocástico (SGD)

SGD estima el gradiente utilizando un solo punto de datos elegido al azar. Si bien puede ser más rápido y capaz de escapar de mínimos locales, tiene un patrón de convergencia más errático debido a su aleatoriedad inherente, lo que potencialmente puede llevar a oscilaciones en la función de costo.

Descenso de gradiente por mini lotes

El descenso de gradiente por mini lotes encuentra un equilibrio entre los dos métodos mencionados anteriormente. Calcula el gradiente utilizando un subconjunto (o “mini lote”) del conjunto de datos. Este método acelera la convergencia al beneficiarse de las ventajas computacionales de las operaciones matriz y ofrece un compromiso entre la estabilidad del descenso de gradiente por lotes y la velocidad del SGD.

Desafíos y soluciones

Mínimos locales

A veces, el descenso de gradiente puede converger a un mínimo local, que no es la solución óptima para la función completa. Esto es particularmente problemático en paisajes complejos con múltiples valles. Para superar esto, incorporar momentum ayuda al algoritmo a navegar por los valles sin quedar atrapado. Además, los algoritmos de optimización avanzados como Adam combinan los beneficios del momentum y las tasas de aprendizaje adaptativas para garantizar una convergencia más robusta hacia los mínimos globales.

Gradientes que desaparecen y explotan

En redes neuronales profundas, a medida que los gradientes se retropropagan, pueden disminuir hasta casi cero (desaparecer) o crecer de manera exponencial (explotar). Los gradientes que desaparecen ralentizan el entrenamiento, dificultando el aprendizaje de la red, mientras que los gradientes que explotan pueden hacer que el modelo diverja. Para mitigar estos problemas, el recorte de gradientes establece un valor límite para evitar que los gradientes se vuelvan demasiado grandes. Por otro lado, las técnicas de inicialización normalizadas, como la inicialización He o Xavier, aseguran que los pesos se establezcan en valores óptimos al principio, reduciendo el riesgo de estos desafíos.

Código de ejemplo para el algoritmo de descenso de gradiente

import numpy as npdef gradient_descent(X, y, learning_rate=0.01, num_iterations=1000): m, n = X.shape theta = np.zeros(n) # Inicializa los pesos/parámetros cost_history = [] # Para almacenar los valores de la función de costo a lo largo de las iteraciones for _ in range(num_iterations): predictions = X.dot(theta) errors = predictions - y gradient = (1/m) * X.T.dot(errors) theta -= learning_rate * gradient # Calcula y almacena el costo para la iteración actual cost = (1/(2*m)) * np.sum(errors**2) cost_history.append(cost) return theta, cost_history# Ejemplo de uso:# Suponiendo que X es una matriz de características con m muestras y n características# y y es un vector objetivo con m muestras.# Nota: Si deseas un término de sesgo en tu modelo, debes agregar un término de sesgo (columna de unos) a X.# Datos de ejemploX = np.array([[1, 1], [1, 2], [1, 3], [1, 4], [1, 5]])y = np.array([2, 4, 5, 4, 5])theta, cost_history = gradient_descent(X, y)print("Parámetros óptimos:", theta)print("Historial de costo:", cost_history)

Este código proporciona un algoritmo básico de descenso de gradiente para regresión lineal. La función gradient_descent toma la matriz de características X, el vector objetivo y, una tasa de aprendizaje y el número de iteraciones. Devuelve los parámetros optimizados (theta) y el historial de la función de costo a lo largo de las iteraciones.

La subparcela izquierda muestra la disminución de la función de costo a lo largo de las iteraciones.

La subparcela derecha muestra los puntos de datos y la línea de mejor ajuste obtenida mediante el descenso de gradiente.

un gráfico 3D de la función  y superponer la ruta tomada por el descenso de gradiente en rojo. El descenso de gradiente comienza desde un punto aleatorio y se mueve hacia el mínimo de la función.

y superponer la ruta tomada por el descenso de gradiente en rojo. El descenso de gradiente comienza desde un punto aleatorio y se mueve hacia el mínimo de la función.

Aplicaciones

Predicción de precios de acciones

Los analistas financieros utilizan el descenso de gradiente en conjunto con algoritmos como la regresión lineal para predecir futuros precios de acciones basados en datos históricos. Al minimizar el error entre los precios de acciones predichos y reales, pueden refinar sus modelos para realizar predicciones más precisas.

Reconocimiento de imágenes

Los modelos de aprendizaje profundo, especialmente las Redes Neuronales Convolucionales (CNNs), emplean el descenso de gradiente para optimizar los pesos mientras se entrenan en vastos conjuntos de datos de imágenes. Por ejemplo, plataformas como Facebook utilizan dichos modelos para etiquetar automáticamente a personas en fotos reconociendo características faciales. La optimización de estos modelos asegura un reconocimiento facial preciso y eficiente.

Análisis de sentimientos

Las empresas utilizan el descenso de gradiente para entrenar modelos que analizan opiniones de clientes, comentarios o menciones en redes sociales para determinar el sentimiento público acerca de sus productos o servicios. Al minimizar la diferencia entre los sentimientos predichos y los reales, estos modelos pueden clasificar de manera precisa el feedback como positivo, negativo o neutral, ayudando a las empresas a evaluar la satisfacción del cliente y adaptar sus estrategias en consecuencia.

Arun es un experimentado Senior Data Scientist con más de 8 años de experiencia en aprovechar el poder de los datos para generar soluciones empresariales impactantes. Sobresale en el uso de análisis avanzados, modelado predictivo y aprendizaje automático para transformar datos complejos en conocimientos accionables y narrativas estratégicas. Posee un PGP en Machine Learning y Artificial Intelligence de una institución reconocida, la experiencia de Arun abarca una amplia variedad de dominios técnicos y estratégicos, lo que lo convierte en un activo valioso en cualquier proyecto impulsado por datos.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- ¿Cómo acelerará la ciencia de datos la economía circular?

- Guía en profundidad para crear y publicar un paquete de datos de R utilizando Devtools

- Utilizando la ciencia de datos clínicos para mejorar los resultados clínicos

- 5 principales herramientas de IA para profesionales de ciencia de datos

- ¿Podemos superar la fragilidad inmediata en los modelos de lenguaje grandes? La IA de Google presenta la calibración por lotes para un rendimiento mejorado.

- Cómo construir una base segura para el liderazgo estadounidense en IA

- NVIDIA amplía su plataforma de robótica para enfrentar el aumento de la IA generativa