Google AI propone PixelLLM un modelo de visión y lenguaje capaz de localización de gran precisión y alineación de visión y lenguaje.

Google AI presenta PixelLLM un modelo de visión y lenguaje con localización precisa y alineación perfecta.

Los Modelos de Lenguaje Grande (LLMs) han utilizado con éxito el poder de los subcampos de Inteligencia Artificial (IA), incluyendo el Procesamiento del Lenguaje Natural (NLP), la Generación de Lenguaje Natural (NLG) y la Visión por Computadora. Con los LLMs, se ha logrado la creación de modelos de visión-lenguaje que pueden razonar de manera compleja sobre imágenes, responder a consultas relacionadas con imágenes y describir imágenes en lenguaje natural. Sin embargo, aún no se sabe si los LLMs pueden realizar tareas de localización como la asociación de palabras o la referencia a la localización.

Para superar este desafío, un equipo de investigadores de Google Research y UC San Diego ha presentado un modelo inteligente llamado PixelLLM que puede lograr una localización detallada y una alineación visión-lenguaje. Este enfoque se ha inspirado en la forma en que las personas se comportan naturalmente, especialmente los bebés, que describen su entorno visual con gestos, señalando y nombrando. El equipo ha compartido que el objetivo es descubrir cómo los LLMs pueden obtener comprensión espacial y razonamiento a partir de la entrada visual.

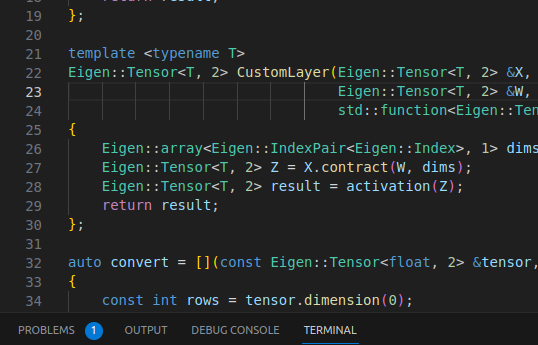

PixelLLM alinea densamente cada palabra producida por el modelo de lenguaje a una ubicación de píxel. Para lograr esto, se ha añadido un pequeño Perceptrón Multicapa (MLP) encima de las características de las palabras, lo que le permite asignar la ubicación de píxel de cada palabra. Se ha utilizado el ajuste fino de rango bajo (LoRA), que permite que los pesos del modelo de lenguaje se actualicen o se congelen. El modelo también puede recibir indicaciones de texto o de ubicación, lo que le permite proporcionar salidas adaptadas a la indicación.

- 2023, año de los LLMs abiertos

- Acelerando el tiempo para obtener conocimientos con las colecciones de series temporales de MongoDB y Amazon SageMaker Canvas

- Tesla retira 2 millones de autos con controles de seguridad de ‘autoguiado’ insuficientes

La arquitectura del modelo consta de un codificador de imágenes, un codificador de indicaciones y un extractor de características de indicaciones. Un modelo de lenguaje grande recibe las características de la imagen condicionadas por la indicación y una posible indicación de texto, con salidas en forma de localización por palabra y subtítulos. Con la capacidad de tomar combinaciones diversas de lenguaje o ubicación como entrada o salida, la arquitectura es versátil y adaptable a una amplia gama de actividades visión-lenguaje.

El equipo ha evaluado el modelo utilizando tareas de visión conocidas como la generación densa de subtítulos de objetos, la generación de subtítulos condicionada por ubicación y la referencia a la localización. Con métricas de rendimiento destacadas, que incluyen 89.8 [email protected] en la referencia a la localización de RefCOCO, 19.9 CIDEr en la generación de subtítulos condicionada por la ubicación de Visual Genome y 17.0 mAP en la generación densa de subtítulos de objetos, PixelLLM ha demostrado resultados de vanguardia en diversos desafíos. La formulación de localización densa por píxel es importante, como se demuestra en los estudios de ablación en RefCOCO, que muestran una ganancia de 3.7 puntos sobre otras formulaciones de localización. Por lo tanto, se ha demostrado que PixelLLM tiene éxito en lograr una alineación y una localización precisas visión-lenguaje.

El equipo ha resumido sus principales contribuciones de la siguiente manera.

- Se ha presentado un nuevo modelo visión-lenguaje llamado PixelLLM, que produce localización de palabras y puede generar subtítulos de imágenes.

- El modelo admite indicaciones de texto o ubicación opcionales además de la entrada de imágenes.

- Se ha utilizado un conjunto de datos narrativos localizados para el entrenamiento de localización por palabra.

- El modelo es capaz de adaptarse a una variedad de tareas visión-lenguaje, que incluyen segmentación, generación de subtítulos condicionada por ubicación, referencia a la localización y generación densa de subtítulos.

- El modelo ha mostrado resultados superiores en la generación de subtítulos condicionada por ubicación, generación densa de subtítulos y referencia a la localización y segmentación.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Asesores y herramientas de planificación de IA Transformando Finanzas, Logística y más allá

- El socio tecnológico que toda startup necesita servicios de desarrollo de software

- 2023 en revisión Recapitulando la era posterior a ChatGPT y qué esperar en 2024

- Creando visualizaciones dinámicas de coropletas utilizando Plotly

- Todas las Ofertas de Asociación entre Microsoft y ODSC

- Anunciando las Cumbres de Ingeniería de Datos e Innovación en IA X 2024

- Ensamble Apilado para Modelado Predictivo Avanzado con H2O.ai y Optuna