Generative AI Desatado Estrategias de implementación de MLOps y LLM para Ingenieros de Software

Generative AI Desatado Implementación de MLOps y LLM para Ingenieros de Software

La reciente explosión de la IA generativa marca un cambio sísmico en lo que es posible con los modelos de aprendizaje automático. Sistemas como DALL-E 2, GPT-3 y Codex apuntan a un futuro en el que la IA puede imitar habilidades humanas únicas como crear arte, mantener conversaciones e incluso escribir software. Sin embargo, desplegar y gestionar de manera efectiva estos emergentes Modelos de Lenguaje Grandes (LLMs) presenta desafíos monumentales para las organizaciones. Este artículo proporcionará a los ingenieros de software tácticas de solución respaldadas por investigación para integrar suavemente la IA generativa mediante el aprovechamiento de las mejores prácticas de MLOps. Se detallan técnicas probadas para implementar LLMs para una eficiencia optimizada, supervisarlos una vez en producción, actualizarlos continuamente para mejorar el rendimiento con el tiempo y garantizar que funcionen de manera cohesiva en diversos productos y aplicaciones. Siguiendo la metodología presentada, los profesionales de IA pueden evitar obstáculos comunes y aprovechar con éxito el poder de la IA generativa para crear valor empresarial y usuarios satisfechos.

La Era de la IA Generativa

La IA generativa es un testimonio de los avances en inteligencia artificial, marcando una partida significativa de los modelos tradicionales. Este enfoque se centra en generar nuevo contenido, ya sea texto, imágenes o incluso sonido, basado en patrones que distingue de vastas cantidades de datos. Las implicaciones de estas capacidades son profundas. Industrias de todo tipo, desde la industria de ciencias de la vida hasta el entretenimiento, están presenciando cambios transformadores debido a las aplicaciones de la IA generativa. Ya sea creando nuevos compuestos farmacéuticos o produciendo música, la influencia de esta tecnología es innegable y continúa dando forma a la trayectoria futura de numerosos sectores.

Comprendiendo LLMs (Modelos de Lenguaje Grandes)

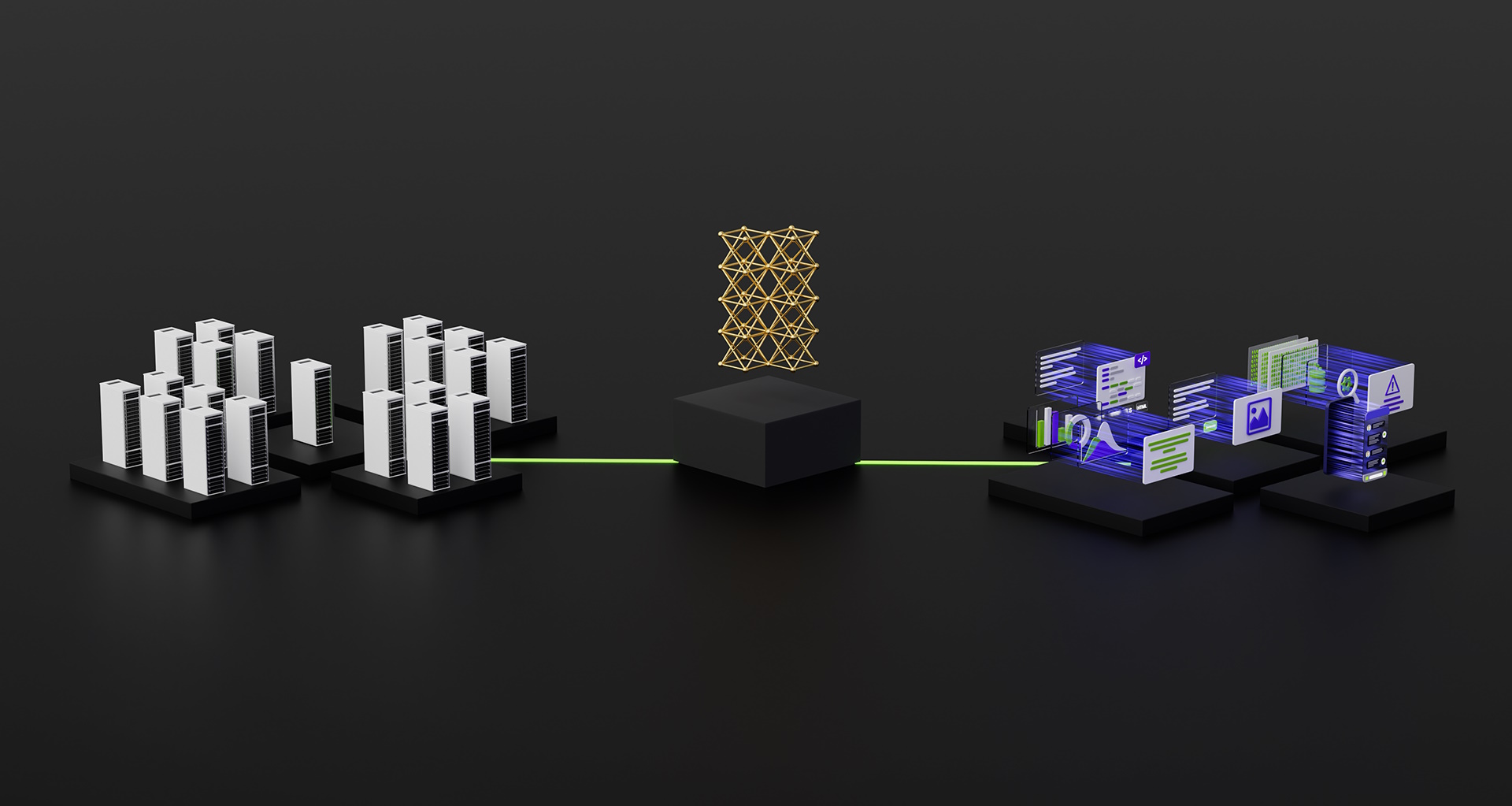

Los Modelos de Lenguaje Grandes, comúnmente llamados LLMs, son un subconjunto de modelos de inteligencia artificial diseñados para entender y generar texto similar al humano. Su capacidad para procesar y producir vastas cantidades de texto coherente y contextualmente relevante los distingue. Sin embargo, los mismos atributos que hacen que los LLMs sean revolucionarios también introducen complejidades. Desplegar y servir estos modelos de manera eficiente requiere un enfoque matizado, dadas su tamaño y requisitos computacionales. Las complejidades de integrar LLMs en aplicaciones subrayan la necesidad de estrategias y herramientas especializadas.

Frameworks de Despliegue de LLM

vLLM Optimizado para IA

El vLLM Optimizado para IA es un framework especializado diseñado para satisfacer las demandas de las aplicaciones de IA contemporáneas. Su arquitectura está meticulosamente diseñada para manejar conjuntos de datos vastos, garantizando tiempos de respuesta rápidos incluso en condiciones difíciles.

- Construye una aplicación de búsqueda de texto e imágenes con NodeJS y IA

- Stephen DeAngelis, Fundador y CEO de Enterra Solutions – Serie de entrevistas

- Estrategias digitales lideradas por IA para el desarrollo ágil de productos

Características Clave

- Manejo eficiente de datos: Capaz de procesar grandes conjuntos de datos sin una latencia significativa

- Tiempos de respuesta rápidos: Optimizado para entregas rápidas, asegurando resultados oportunos

- Integración flexible: Diseñado para ser compatible con varias aplicaciones y plataformas

Ventajas

- Escalabilidad: Puede manejar fácilmente cargas de datos crecientes sin comprometer el rendimiento

- Interfaz fácil de usar: Simplifica el proceso de integración y predicción del modelo

Desventajas

- Requiere muchos recursos: Esto puede requerir recursos computacionales sustanciales para un rendimiento óptimo.

- Curva de aprendizaje: Aunque es fácil de usar, puede llevar tiempo para que los recién llegados aprovechen completamente sus capacidades.

Código de Ejemplo

Servicio por Lotes sin Conexión:

Servidor de API:

Inferencia de Texto de GenAI

Inferencia de Texto de GenAI es un framework que se destaca por su adaptabilidad y eficiencia en el procesamiento de tareas basadas en lenguaje. Ofrece un enfoque de generación de texto simplificado, enfatizando la velocidad y la coherencia.

Características Clave

- Generación de texto adaptativa: Capaz de producir texto contextualmente relevante y coherente

- Arquitectura optimizada: Diseñada para tareas rápidas de generación de texto

- Aplicación versátil: Adecuada para diversas tareas de IA basadas en texto más allá de la mera generación

Ventajas

- Salida de alta calidad: Produce consistentemente texto coherente y contextualmente relevante

- Fácil integración: APIs y funciones simplificadas facilitan su incorporación en proyectos

Desventajas

- Especificidad: Si bien es excelente para tareas de texto, puede ser menos versátil para operaciones de IA no textuales.

- Requisitos de recursos: Un rendimiento óptimo puede requerir una considerable potencia de cálculo.

Código de ejemplo para el servidor web con integración de Docker

1. Código del servidor web (app.py)

2. Dockerfile

3. Construcción y ejecución del contenedor Docker: Para construir la imagen de Docker y ejecutar el contenedor, normalmente se utilizarían los siguientes comandos:

4. Realización de llamadas a la API: Una vez que el servidor esté en funcionamiento dentro del contenedor Docker, se pueden realizar llamadas a la API al punto final /generate_text utilizando herramientas como curl o cualquier cliente HTTP:

Plataforma MLOps OpenLLM: Un análisis en profundidad

La Plataforma MLOps OpenLLM es un faro en el vasto mar de marcos de IA, especialmente diseñada para Modelos de Lenguaje Grandes. Su diseño facilita el despliegue, la gestión y la escalabilidad sin problemas de los LLM en diversos entornos.

Características clave

- Arquitectura escalable: Diseñada para manejar las demandas tanto de aplicaciones a pequeña escala como de sistemas a nivel empresarial

- APIs intuitivas: Interfaces simplificadas que reducen la curva de aprendizaje y mejoran la productividad del desarrollador

- Optimizada para LLMs: Componentes especializados que satisfacen los requisitos únicos de los Modelos de Lenguaje Grandes

Ventajas

- Versatilidad: Adecuada para muchas aplicaciones, desde chatbots hasta sistemas de generación de contenido

- Eficiencia: Operaciones optimizadas que garantizan tiempos de respuesta rápidos y alto rendimiento

- Soporte de la comunidad: Respaldado por una comunidad vibrante que contribuye a la mejora continua

Desventajas

- Complejidad de la configuración inicial: Si bien la plataforma es fácil de usar, la configuración inicial puede requerir un mayor nivel de comprensión.

- Intensidad de recursos: La plataforma puede requerir recursos computacionales significativos para modelos más grandes.

Código del servidor web (server.py):

Realización de llamadas a la API: Con el servidor en funcionamiento, se pueden dirigir llamadas a la API al punto final /generate. Aquí tienes un ejemplo sencillo utilizando el comando curl:

RayServe: Un examen perspicaz

RayServe, un componente integral del ecosistema Ray, ha ido ganando popularidad entre desarrolladores e investigadores. Es un sistema de servicio de modelos diseñado desde cero para llevar rápidamente modelos de aprendizaje automático, incluidos los Modelos de Lenguaje Grandes, a producción.

Características clave

- Escalabilidad sin problemas: RayServe puede escalar desde una sola máquina hasta un gran clúster sin necesidad de realizar modificaciones en el código.

- Agnóstico del marco de trabajo: Admite modelos de cualquier marco de aprendizaje automático sin restricciones.

- Agrupación y programación: Tiene funciones avanzadas como agrupación y programación adaptativa incorporadas, optimizando el proceso de servicio.

Ventajas

- Flexibilidad: RayServe puede servir simultáneamente varios modelos o incluso múltiples versiones del mismo modelo.

- Rendimiento: Diseñado para un alto rendimiento, garantizando bajos tiempos de latencia y alto rendimiento

- Integración con el ecosistema Ray: Al ser parte del ecosistema Ray, se beneficia de las capacidades de Ray, como el entrenamiento distribuido y el paralelismo fino.

Desventajas

- Curva de aprendizaje: Aunque es potente, los recién llegados pueden encontrarlo desafiante inicialmente debido a sus extensas características.

- Gestión de recursos: En un entorno de clúster, es esencial una asignación cuidadosa de recursos para evitar cuellos de botella.

Código del servidor web (serve.py):

Consultas para las llamadas a la API: Con el servidor RayServe en funcionamiento, se pueden enviar consultas a la API al punto final /generate. Aquí tienes un ejemplo utilizando el comando curl:

Consideraciones para Ingenieros de Software

A medida que el panorama tecnológico evoluciona, los ingenieros de software se encuentran en la encrucijada de la innovación y la practicidad. La implementación de Modelos de Lenguaje de Gran Escala (LLMs) no es una excepción a esta dinámica. Con sus vastas capacidades, estos modelos plantean desafíos y consideraciones que los ingenieros deben abordar para aprovechar su máximo potencial.

Consejos y Mejores Prácticas para la Implementación de LLMs:

- Asignación de recursos: Dada la carga computacional de los LLMs, es imperativo garantizar una asignación adecuada de recursos. Esto incluye tanto la memoria como las capacidades de procesamiento, para que el modelo funcione de manera óptima.

- Versionado del modelo: A medida que los LLMs evolucionan, mantener un sistema de versionado transparente puede ayudar a realizar un seguimiento de los cambios, solucionar problemas y garantizar la reproducibilidad.

- Monitoreo y registro: Mantener un ojo vigilante en las métricas de rendimiento del modelo y registrar anomalías puede prevenir posibles problemas, garantizando un funcionamiento fluido.

- Protocolos de seguridad: Dada la naturaleza sensible de los datos que los LLMs pueden manejar, implementar medidas de seguridad sólidas es innegociable. Esto incluye el cifrado de datos, puntos finales de API seguros y evaluaciones regulares de vulnerabilidades.

El Rol de CI/CD en MLOps

La Integración Continua y la Implementación Continua (CI/CD) son pilares en la implementación de MLOps. Su importancia es multifacética:

- Actualizaciones simplificadas: Con la evolución continua de los LLMs, los pipelines de CI/CD aseguran que las actualizaciones, mejoras o correcciones de errores se integren y desplieguen sin interrumpir los servicios existentes.

- Pruebas automatizadas: Antes de cualquier implementación, las pruebas automatizadas pueden validar el rendimiento del modelo, asegurando que los nuevos cambios no afecten negativamente su funcionalidad.

- Consistencia: CI/CD asegura un entorno consistente desde el desarrollo hasta la producción, mitigando el infame “funciona en mi máquina”.

- Bucle de retroalimentación rápida: Cualquier problema, ya sea en el modelo o en la infraestructura, se identifica y se corrige rápidamente, lo que conduce a un sistema más resistente.

En resumen, para los ingenieros de software que se aventuran en el despliegue de LLMs, una combinación de las mejores prácticas junto con la solidez de CI/CD puede allanar el camino hacia el éxito en el siempre cambiante panorama de MLOps.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Candle Aprendizaje Automático Minimalista en Rust

- Perfilando el código de Python utilizando timeit y cProfile

- Un Enfoque Integral para Mejorar la Seguridad del IoT con Inteligencia Artificial

- Descifrando los desafíos empresariales El arte de crear soluciones analíticas

- Entendiendo Flash-Atención y Flash-Atención-2 El camino para ampliar la longitud del contexto de los modelos de lenguaje

- 9 Tipos Comunes de Ataques en Sistemas de Inteligencia Artificial

- Generación automática de música utilizando Aprendizaje Profundo