GenAIOps Evolucionando el marco de MLOps

GenAIOps Evolving the MLOps framework

La IA generativa requiere nuevas capacidades de implementación y monitoreo

Allá por 2019, publiqué un blog en LinkedIn titulado “Por qué necesitas ML Ops para una innovación exitosa”. Avanzando rápidamente hasta hoy, operacionalizar modelos analíticos, de aprendizaje automático (ML) e inteligencia artificial (AI) sigue siendo un desafío para muchas organizaciones. Sin embargo, dicho esto, la tecnología ha evolucionado y han surgido nuevas empresas para ayudar a abordar los desafíos de implementar, monitorear y actualizar modelos en entornos de producción. Sin embargo, con el reciente avance de la IA generativa utilizando grandes modelos de lenguaje (LLMs) como el GPT-4 de OpenAI, el PaLM 2 de Google, el LLaMA de Meta y el GitHub Copilot, las organizaciones se han apresurado a comprender el valor, los costos, los plazos de implementación y los riesgos asociados con los LLMs. Las empresas deben proceder con cautela, ya que estamos apenas al comienzo de este viaje y diría que la mayoría de las organizaciones aún no están preparadas para ajustar, implementar, monitorear y mantener los LLMs.

¿Qué es MLOps?

Las operaciones de aprendizaje automático (también conocidas como MLOps) se pueden definir como:

MLOps es un proceso continuo, colaborativo y multidisciplinario que se centra en la operacionalización de la ciencia de datos mediante la gestión de modelos estadísticos, de ciencia de datos y de aprendizaje automático como artefactos de software reutilizables y altamente disponibles, a través de un proceso de implementación repetible. Incluye aspectos de gestión únicos que abarcan la inferencia de modelos, la escalabilidad, el mantenimiento, la auditoría y el gobierno, así como el monitoreo continuo de los modelos en producción para garantizar que sigan aportando un valor empresarial positivo a medida que cambian las condiciones subyacentes.[1]

Ahora que tenemos una definición clara de MLOps, discutamos por qué es importante para las organizaciones.

- Las dos caras de la alineación de la IA

- Energía Solar da un nuevo giro

- El gemelo malévolo de ChatGPT, ‘WormGPT’, está entrando silenciosamente en correos electrónicos y saqueando bancos.

¿Por qué es importante MLOps?

En el entorno empresarial impulsado por algoritmos de hoy, la importancia de MLOps no puede ser exagerada. A medida que las organizaciones dependen cada vez más de modelos de ML cada vez más sofisticados para impulsar la toma de decisiones y la eficiencia operativa diaria, la necesidad de un sistema robusto, escalable y eficiente para implementar, gestionar, monitorear y actualizar estos modelos se vuelve primordial. MLOps proporciona un marco y un conjunto de procesos para la colaboración entre científicos de datos e informáticos, que desarrollan los modelos, y los equipos de operaciones de TI, que los implementan, gestionan y mantienen, asegurando que los modelos sean confiables, estén actualizados y aporten valor empresarial.

Funcionalidades clave de MLOps

Hablando en términos generales, las funcionalidades de MLOps incluyen flujos de trabajo de aprendizaje automático automatizados, versionado de modelos, monitoreo de modelos y gobierno de modelos.

● Flujos de trabajo automatizados agilizan el proceso de entrenar, validar e implementar modelos; reduciendo el esfuerzo manual y aumentando la velocidad.

● Versionado de modelos permite rastrear cambios y mantener un registro de las iteraciones del modelo.

● Monitoreo de modelos es crucial para asegurarse de que los modelos estén funcionando como se espera en los sistemas de producción.

● Gobierno de modelos proporciona cumplimiento de regulaciones y políticas organizativas.

En conjunto, estas funcionalidades permiten a las organizaciones operacionalizar el ML y la IA a gran escala, impulsando el valor empresarial y la ventaja competitiva para sus organizaciones.

MLOps: Métricas y KPIs

Para asegurarse de que los modelos estén funcionando como se espera y brinden predicciones óptimas en los sistemas de producción, existen varios tipos de métricas e indicadores clave de rendimiento (KPIs) que se utilizan para rastrear su eficacia. Hable con un científico de datos y a menudo destacará las siguientes métricas:

● Métricas de rendimiento del modelo: Estas son las métricas que miden el rendimiento predictivo de un modelo. Pueden incluir precisión, exactitud, recall, puntuación F1, área bajo la curva ROC (AUC-ROC), error absoluto medio (MAE), error cuadrado medio (MSE), etc. La elección de la métrica depende del tipo de problema (clasificación, regresión, etc.) y del contexto empresarial.

● Deriva de datos: Esto mide cuánto se desvían los datos de entrada en el flujo de trabajo de producción de los datos en los que se entrenó el modelo. Una deriva de datos significativa puede indicar que las predicciones del modelo podrían volverse menos confiables con el tiempo. ¡Vimos un gran ejemplo de esto en ese pequeño “bache” conocido como COVID. Los hábitos de consumo y las normas comerciales cambiaron de la noche a la mañana, haciendo que los modelos de todos se rompieran!

● Desviación del modelo: Similar a la desviación de datos, esto mide cuánto cambia (a menudo degradándose) el rendimiento del modelo con el tiempo en lugar de medir cómo se desvía la distribución de datos de la norma. Esto puede ocurrir si la distribución subyacente de datos cambia, lo que hace que las suposiciones del modelo sean menos precisas.

● Distribución de predicciones: Seguir la distribución de las predicciones del modelo puede ayudar a detectar anomalías. Por ejemplo, si un modelo de clasificación binaria comienza repentinamente a predecir muchas más positivas de lo habitual, podría indicar un problema. Estas a menudo se alinean más estrechamente con las métricas empresariales.

● Uso de recursos: El uso de recursos de TI incluye métricas como el uso de CPU, el uso de memoria y la latencia. Estas métricas son importantes para garantizar que el modelo se esté ejecutando de manera eficiente y dentro de las limitaciones de infraestructura y arquitectura del sistema.

● Métricas empresariales: Las más importantes de todas las métricas, estas métricas miden el impacto del modelo en los resultados empresariales. Podrían incluir métricas como ingresos, tasas de pérdida de clientes, tasas de conversión y, genéricamente, tasas de respuesta. Estas métricas ayudan a evaluar si el modelo está proporcionando el valor empresarial esperado.

Entonces, ahora que tenemos una comprensión de alto nivel de MLOps, por qué es importante, las capacidades clave y las métricas, ¿cómo se relaciona esto con la IA generativa?

IA generativa: casos de uso primarios interfuncionales

Antes de que la IA generativa se volviera común, las organizaciones habían implementado principalmente sistemas de IA que actuaban sobre datos estructurados y semiestructurados. Estos sistemas se entrenaban principalmente en números y generaban salidas numéricas: predicciones, probabilidades y asignaciones de grupos (piense en segmentación y agrupación). En otras palabras, entrenábamos nuestros modelos de IA con datos numéricos históricos como datos transaccionales, de comportamiento, demográficos, tecnográficos, firmográficos, geoespaciales y generados por máquinas, y generábamos probabilidades de pérdida, respuesta o interacción con una oferta. Esto no significa que no hayamos utilizado datos de texto, audio o video, lo hemos hecho; análisis de sentimientos, registros de mantenimiento de equipos y otros; pero estos casos de uso eran mucho menos comunes que los enfoques basados en números. La IA generativa tiene un nuevo conjunto de capacidades que permiten a las organizaciones aprovechar los datos que han estado ignorando durante todos estos años: datos de texto, audio y video.

Los usos y aplicaciones son muchos, pero he resumido los principales casos de uso interfuncionales para la IA generativa (hasta la fecha).

Generación de contenido

La IA generativa puede generar contenido de calidad similar al de los humanos, desde audio, video/imagen y texto.

● Generación de contenido de audio: la IA generativa puede crear pistas de audio adecuadas para plataformas de redes sociales como YouTube, o agregar narraciones con IA a su contenido escrito, mejorando la experiencia multimedia. De hecho, mis dos primeras guías de TinyTech tienen narraciones en Google Play que fueron generadas completamente por IA. Podía elegir el acento, el sexo, la edad y el ritmo, y algunos otros atributos clave para los libros narrados por IA. Echa un vistazo a los audiolibros narrados por IA aquí.

○ Inteligencia Artificial: Una guía ejecutiva para que la IA funcione en su negocio

○ Marketing B2B moderno: una guía del profesional para la excelencia en marketing

● Generación de contenido de texto: esta es probablemente la forma más popular de IA generativa en este momento, desde la creación de publicaciones de blog, actualizaciones en redes sociales, descripciones de productos, borradores de correos electrónicos, cartas de clientes, hasta propuestas de RFP, la IA generativa puede producir sin esfuerzo una amplia gama de contenido de texto, ahorrando a las empresas tiempo y recursos significativos. Sin embargo, ten cuidado, solo porque el contenido esté generado y suene autoritario no significa que sea factualmente preciso.

● Generación de imágenes y videos: Hemos visto que esto se está desarrollando gradualmente en Hollywood, popularizado por personajes generados por IA en la franquicia de Star Wars o rejuveneciendo a Harrison Ford en la última película de “Indiana Jones”, la IA puede crear imágenes y películas realistas. La IA generativa puede acelerar los servicios creativos generando contenido para anuncios, presentaciones y blogs. Hemos visto que empresas como Adobe y Canva hacen un esfuerzo concertado en el frente de los servicios creativos.

● Generación de código de software: La IA generativa puede generar código de software (como Python) y SQL que se puede integrar en sistemas de análisis y BI, así como en aplicaciones de IA en sí mismas. De hecho, Microsoft continúa investigando el uso de ‘libros de texto’ para entrenar LLMs y crear código de software más preciso.

Resumen y personalización de contenido

Además de crear contenido realista y nuevo para las empresas, la IA generativa también se puede utilizar para resumir y personalizar contenido. Además de ChatGPT, empresas como Writer, Jasper y Grammarly están enfocadas en funciones de marketing y organizaciones para resumir y personalizar contenido. Esto permitirá a las organizaciones de marketing dedicar tiempo a crear un calendario y un proceso de contenido bien pensado, y luego estos diversos servicios se pueden ajustar para crear una cantidad aparentemente infinita de variaciones del contenido aprobado para que se entregue a la persona adecuada en el canal correcto en el momento adecuado.

Descubrimiento de contenido y preguntas y respuestas (Q&A)

El tercer ámbito en el que la IA generativa está ganando terreno es en el descubrimiento de contenido y en las preguntas y respuestas (Q&A). Desde una perspectiva de software de datos y análisis, varios proveedores están incorporando capacidades de IA generativa para crear interfaces más naturales (en lenguaje sencillo) que faciliten el descubrimiento automático de nuevos conjuntos de datos dentro de una organización, así como la redacción de consultas y fórmulas basadas en conjuntos de datos existentes. Esto permitirá a los usuarios de inteligencia empresarial (BI) no expertos hacer preguntas simples como “¿cuáles son mis ventas en la región noreste?” y luego profundizar y hacer preguntas cada vez más refinadas. Las herramientas de BI y análisis generarán automáticamente los gráficos relevantes en base a sus consultas.

También observamos un aumento en el uso de esto en la industria de la salud, así como en la industria legal. Dentro del sector de la salud, la IA generativa puede analizar grandes cantidades de datos y ayudar a resumir notas de médicos y personalizar comunicaciones y correspondencia con los pacientes a través de chatbots, correos electrónicos y similares. Existe una reticencia a utilizar la IA generativa únicamente para capacidades de diagnóstico, pero con la intervención humana, veremos un aumento en su uso. También veremos un aumento en el uso de la IA generativa en el ámbito legal. Nuevamente, siendo una industria centrada en documentos, la IA generativa podrá encontrar rápidamente términos clave dentro de contratos, ayudar en la investigación legal, resumir contratos y crear documentos legales personalizados para abogados. McKinsey lo llamó el copiloto legal.

Ahora que entendemos los usos principales asociados con la IA generativa, pasemos a las principales preocupaciones.

IA Generativa: Desafíos y consideraciones clave

La IA generativa, aunque prometedora, tiene sus propios desafíos y posibles obstáculos. Las organizaciones deben considerar cuidadosamente varios factores antes de integrar la tecnología de IA generativa en sus procesos comerciales. Los principales desafíos incluyen:

● Problemas de precisión (alucinaciones): Los LLMs a menudo pueden generar información engañosa o completamente falsa. Estas respuestas pueden parecer creíbles pero son completamente fabricadas. ¿Qué medidas de seguridad pueden establecer las empresas para detectar y prevenir esta desinformación?

● Sesgo: Las organizaciones deben comprender las fuentes de sesgo en el modelo e implementar estrategias de mitigación para controlarlo. ¿Qué políticas empresariales o requisitos legales están en vigencia para abordar posibles sesgos sistemáticos?

● Déficit de transparencia: Para muchas aplicaciones, especialmente en sectores como servicios financieros, seguros y salud, la transparencia del modelo suele ser un requisito empresarial. Sin embargo, los LLM no son inherentemente explicables o predecibles, lo que puede llevar a “alucinaciones” y otros posibles problemas. Si su empresa necesita cumplir con auditores o reguladores, debe preguntarse, ¿podemos incluso usar LLMs?

● Riesgo de propiedad intelectual (PI): Los datos utilizados para entrenar muchos LLMs fundamentales a menudo incluyen información de dominio público; hemos visto litigios por el uso indebido de imágenes (por ejemplo, HBR – Generative AI tiene un problema de propiedad intelectual), música (The Verge – AI Drake acaba de poner una trampa legal imposible para Google) y libros (LA Times – Sara Silverman y otros autores más vendidos demandan a MEta y OpenAI por infracción de derechos de autor). En muchos casos, el proceso de entrenamiento absorbe indiscriminadamente todos los datos disponibles, lo que puede llevar a litigios por exposición a PI e infracción de derechos de autor. Esto plantea la pregunta, ¿qué datos se utilizaron para entrenar su modelo base y cuáles se utilizaron para ajustarlo?

● Ciberseguridad y fraude: Con el uso generalizado de servicios de IA generativa, las organizaciones deben estar preparadas para posibles usos indebidos por parte de actores maliciosos. La IA generativa se puede utilizar para crear falsificaciones profundas para ataques de ingeniería social. ¿Cómo puede su organización asegurarse de que los datos utilizados para el entrenamiento no hayan sido manipulados por estafadores y actores malintencionados?

● Impacto ambiental: El entrenamiento de modelos de IA a gran escala requiere recursos computacionales significativos, lo que a su vez conlleva un consumo energético considerable. Esto tiene implicaciones para el medio ambiente, ya que la energía utilizada a menudo proviene de fuentes no renovables, lo que contribuye a las emisiones de carbono. Para las organizaciones que tienen iniciativas ambientales, sociales y de gobernanza (ESG) en marcha, ¿cómo se tendrá en cuenta el uso de LLMs en su programa?

Ahora, hay una multitud de otras cosas que las empresas deben considerar, pero se han capturado las principales. Esto plantea la siguiente pregunta, ¿cómo operativizar los modelos de IA generativa?

GenAIOps: Se necesitan un conjunto de capacidades nuevas

Ahora que tenemos una mejor comprensión de la IA generativa, sus usos clave, desafíos y consideraciones, pasemos a cómo debe evolucionar el marco de MLOps, a lo que he llamado GenAIOps y, según mi conocimiento, soy el primero en acuñar este término.

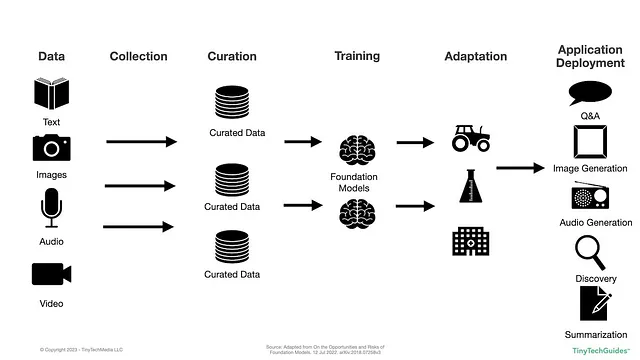

Veamos el proceso de alto nivel para la creación de LLMs; el gráfico se adaptó de “Sobre las oportunidades y riesgos de los modelos base”.

Figura 1.1: Proceso para entrenar e implementar LLMs

En lo anterior vemos que se crea, recopila, organiza y luego se entrenan, adaptan e implementan modelos. Dado esto, ¿qué consideraciones se deben tener en cuenta para un marco GenAIOps integral?

GenAIOps: Lista de verificación

Recientemente, Stanford publicó un artículo ¿Los proveedores de modelos base cumplen con el proyecto de Ley de IA de la UE? Después de leer eso, utilicé eso como inspiración para generar la Lista de verificación del marco GenAIOps a continuación.

Datos:

○ ¿Qué fuentes de datos se utilizaron para entrenar el modelo?

○ ¿Cómo se generaron los datos que se utilizaron para entrenar el modelo?

○ ¿Los entrenadores tenían permiso para utilizar los datos en el contexto?

○ ¿Los datos contienen material con derechos de autor?

○ ¿Los datos contienen información confidencial o sensible?

○ ¿Los datos contienen datos individuales o PII?

○ ¿Los datos han sido envenenados? ¿Está sujeto a envenenamiento?

○ ¿Los datos eran auténticos o incluían contenido generado por IA?

Modelado:

○ ¿Qué limitaciones tiene el modelo?

○ ¿Existen riesgos asociados con el modelo?

○ ¿Cuáles son los puntos de referencia del rendimiento del modelo?

○ ¿Podemos recrear el modelo si fuera necesario?

○ ¿Los modelos son transparentes?

○ ¿Qué otros modelos base se utilizaron para crear el modelo actual?

○ ¿Cuánta energía y recursos computacionales se utilizaron para entrenar el modelo?

Implementación:

○ ¿Dónde se implementarán los modelos?

○ ¿Las aplicaciones de implementación objetivo comprenden que están utilizando IA generativa?

○ ¿Tenemos la documentación adecuada para satisfacer a auditores y reguladores?

Ahora que tenemos un punto de partida, examinemos más de cerca las métricas

GenAIOps: Métricas y consideraciones del proceso

Usando las métricas y KPIs de MLOps como punto de partida, examinemos cómo se pueden aplicar a las métricas de IA generativa. Esperamos que GenAIOps ayude a abordar los desafíos específicos de la IA generativa, como la generación de contenido falso, engañoso o tendencioso.

Métricas de rendimiento del modelo

En el contexto de la IA generativa, ¿cómo podría una organización medir el rendimiento del modelo? Sospecho que la mayoría de las organizaciones probablemente utilizarán un LLM pre-entrenado disponible comercialmente y utilizarán sus propios datos para ajustar y adaptar sus modelos.

Ahora bien, ciertamente existen métricas técnicas de rendimiento asociadas con LLMs basados en texto como BLEU, ROUGE o METEOR y ciertamente las hay para imágenes, audio y video, pero estoy más preocupado por la generación de contenido falso, engañoso o tendencioso. ¿Qué controles puede implementar una organización para monitorear, detectar y mitigar estas situaciones?

Ciertamente hemos visto la proliferación de propaganda en el pasado y los gigantes de las redes sociales como Facebook, Google y Twitter no han logrado implementar una herramienta que prevenga consistentemente y de manera confiable que esto ocurra. Si este es el caso, ¿cómo medirá su organización el rendimiento del modelo de IA generativa? ¿Tendrá verificadores de hechos? ¿Y para imágenes, audio y video? ¿Cómo puede medir el rendimiento de estos modelos?

Deriva de datos

Dado que los modelos requieren recursos y tiempo significativos para entrenarse, ¿cómo determinarán los creadores de modelos si los datos del mundo están cambiando y necesitamos un nuevo modelo? ¿Cómo entenderá una organización si sus datos están evolucionando hasta el punto en que necesitarán recalibrar su modelo? Esto es relativamente sencillo con datos numéricos, pero creo que todavía estamos aprendiendo cómo manejar datos no estructurados como texto, imágenes, audio y video.

Suponiendo que podemos crear un mecanismo para ajustar periódicamente nuestros modelos, también debemos tener un control para detectar si los datos cambiantes se deben a eventos reales o a una proliferación de contenido generado por IA. En mi publicación sobre la Entropía de la IA: El círculo vicioso del contenido generado por IA, discutí el hecho de que cuando entrenas IA con IA, se vuelve más tonta con el tiempo.

Deriva del modelo

Similar a tus preocupaciones por el rendimiento del modelo y el cambio de datos, ¿cómo detectará y entenderá tu organización si el rendimiento de tu modelo comienza a desviarse? ¿Tendrás monitores humanos de la salida o enviarás encuestas a los usuarios finales? Quizás una de las formas más sencillas de hacer esto es no solo implementar controles para monitorear el rendimiento técnico de un modelo, sino que tu empresa siempre debe rastrear las salidas del modelo. Esto va sin decir, pero estás utilizando un modelo para resolver un desafío empresarial específico y necesitas monitorear las métricas empresariales. ¿Estás viendo un aumento en el abandono del carrito, un aumento / disminución en las llamadas de servicio al cliente o un cambio en las calificaciones de satisfacción del cliente?

Distribución de predicciones

Nuevamente, creo que tenemos herramientas y técnicas decentes para rastrear esto en predicciones basadas en números. Pero ahora que estamos tratando con texto, imágenes, audio y video, ¿cómo piensas en monitorear las distribuciones de predicción? ¿Podremos entender si la salida del modelo en su destino de implementación está generando correlaciones espurias? Si es así, ¿qué puedes implementar para medir este fenómeno?

Uso de recursos

A primera vista, este parece relativamente sencillo. Sin embargo, a medida que el uso generativo crece dentro de una empresa, tu organización necesitará tener un sistema para rastrear y gobernar ese uso. Los modelos de precios aún están evolucionando en el segmento de IA generativa, por lo que debemos tener cuidado aquí. Similar a lo que estamos viendo en el espacio de almacén de datos en la nube, estamos comenzando a ver costos fuera de control. Entonces, si tu empresa tiene precios basados en el uso, ¿cómo establecerás controles financieros y mecanismos de gobierno para asegurarte de que tus costos sean predecibles y no se descontrolen?

Métricas empresariales

Ya he mencionado esto anteriormente, pero el conjunto más importante de monitores y controles que puedes implementar están relacionados con las métricas empresariales. Tu empresa debe estar siempre vigilante para monitorear cómo tus modelos están impactando realmente tu negocio a diario. Si estás utilizando esto para procesos empresariales críticos, ¿qué garantías de nivel de servicio tienes para garantizar el tiempo de actividad?

El sesgo es una gran preocupación con cualquier modelo de IA, pero esto puede ser aún más agudo con la IA generativa. ¿Cómo detectarás si las salidas de tu modelo tienen sesgos y si están perpetuando desigualdades? Hubo un gran blog sobre esto de Tim O’Reilly titulado Ya hemos dejado salir al genio de la botella, que te animo a leer.

Desde una perspectiva de propiedad intelectual, ¿cómo garantizarás que la información propietaria, confidencial o personal no escape ni se filtre de tu organización? Dada toda la litigación sobre infracción de derechos de autor que está ocurriendo ahora, este es un conjunto importante de factores con los que tu organización tendrá que lidiar. ¿Deberías pedirle a los proveedores que garanticen que estos no están en tu modelo, al igual que Adobe (FastCompany – Adobe está tan seguro de que su IA generativa Firefly no violará los derechos de autor que cubrirá tus gastos legales)? Ahora, está bien que cubran tus gastos legales, pero ¿a qué riesgo reputacional se expone tu empresa? Si pierdes la confianza de tus clientes, es posible que nunca los recuperes.

Por último, la contaminación de datos es sin duda un tema candente. Cuando utilizas los datos de tu organización para adaptar y ajustar el modelo, ¿cómo puedes garantizar que los datos no sean tóxicos? ¿Cómo puedes garantizar que los datos utilizados para entrenar los modelos base no estén contaminados?

Resumen

En última instancia, el objetivo de esto no era proporcionar métodos y métricas específicos sobre cómo abordar GenAIOps, sino más bien plantear una serie de preguntas sobre lo que las organizaciones deben considerar antes de implementar un LLM. Como cualquier otra cosa, la IA generativa tiene un gran potencial para ayudar a tu organización a alcanzar una ventaja competitiva, pero también tiene un conjunto de desafíos y riesgos que deben abordarse. Al final, GenAIOps deberá tener un conjunto de principios y capacidades que abarquen tanto la organización adoptante como el proveedor que proporciona el LLM. En palabras de Spiderman, con un gran poder viene una gran responsabilidad.

Si quieres aprender más sobre Inteligencia Artificial, echa un vistazo a mi libro Artificial Intelligence: An Executive Guide to Make AI Work for Your Business en Amazon.

[1] Sweenor, David, Steven Hillion, Dan Rope, Dev Kannabiran, Thomas Hill, y Michael O’Connell. 2020. ML Ops: Operationalizing Data Science. O’Reilly Media. https://www.oreilly.com/library/view/ml-ops-operationalizing/9781492074663/.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Los modelos base Llama 2 de Meta ahora están disponibles en Amazon SageMaker JumpStart

- Primeras sesiones y ponentes anunciados para ODSC West 2023

- Los emojis son cada vez más legalmente vinculantes. Pero todavía están abiertos a una amplia interpretación

- ¿Puede la inteligencia artificial inventar?

- La IA escribió un proyecto de ley de vivienda. Los críticos dicen que no es inteligente

- Las etiquetas de ciberseguridad para dispositivos inteligentes están en camino

- Sorprendente descubrimiento magnético revelado en el grafeno de ángulo mágico