Entropía de IA El círculo vicioso del contenido generado por IA

Entropía de IA El círculo vicioso del contenido generado por IA

Comprendiendo y Mitigando el Colapso del Modelo

Introducción

Imagina si pudieras clonarte para estar en múltiples lugares a la vez, manejando todas tus responsabilidades sin esfuerzo. Recuerda la película de comedia de ciencia ficción Multiplicidad (circa 1996), donde Doug Kinney (interpretado por Michael Keaton) se clona a sí mismo para manejar su trabajo y vida personal. Sin embargo, a medida que se crean más Dougs, cada clon subsiguiente muestra rasgos exagerados e inteligencia disminuida en comparación con la versión anterior. Los clones, inicialmente creados para reducir el caos, terminan creando más confusión y entropía en la vida de Kinney.

En el mundo de la inteligencia artificial (IA), ocurre un fenómeno similar cuando los grandes modelos de lenguaje (LLMs, por sus siglas en inglés) se entrenan con datos generados por versiones anteriores de sí mismos. Al igual que los clones en Multiplicidad, los modelos de IA comienzan a perder contacto con la distribución original de datos, lo que lleva a un aumento del caos y la confusión, una especie de entropía en el mundo de la IA conocida como “colapso del modelo”.

El Fenómeno del Colapso del Modelo

Al igual que Doug en Multiplicidad, quien enfrenta el caos al crear más clones, los modelos de IA enfrentan un destino similar cuando se entrenan recursivamente con datos generados por versiones anteriores de sí mismos. Se vuelven más tontos y exagerados con el tiempo.

¿Qué es el Colapso del Modelo?

El colapso del modelo se refiere a un proceso degenerativo en el cual, con el tiempo, los modelos de IA pierden información sobre la distribución original del contenido (datos). A medida que los modelos de IA se entrenan con datos generados por sus predecesores, comienzan a “olvidar” la verdadera distribución subyacente de los datos, lo que lleva a una reducción de sus capacidades generativas.

- Potencia tu código en Python con extensiones de Rust

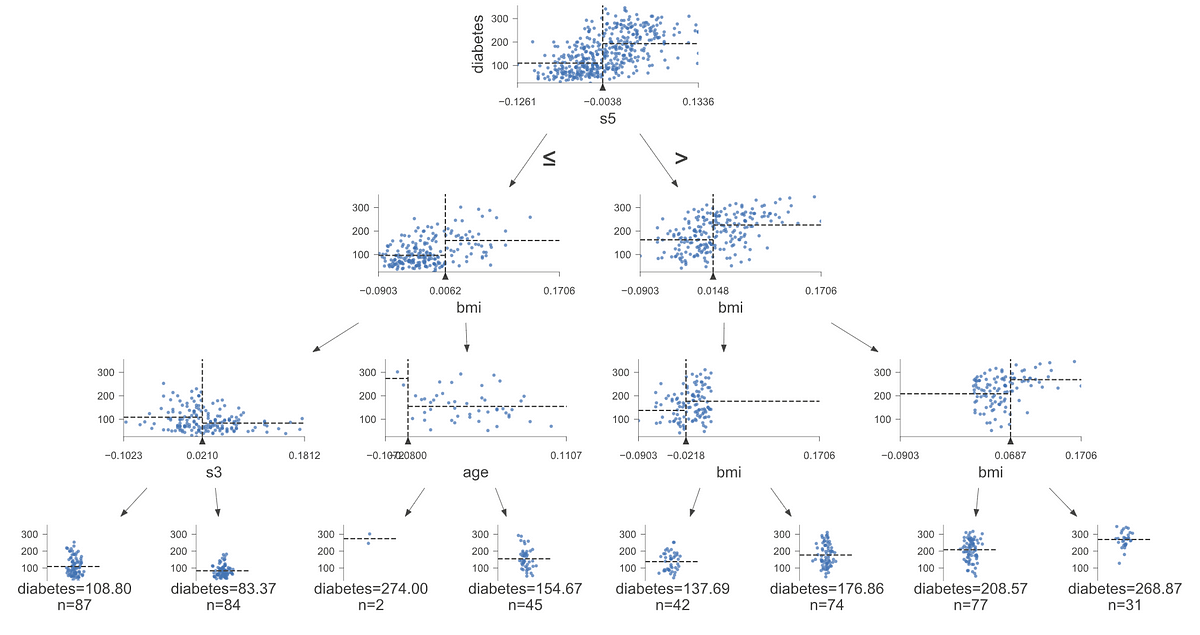

- Araucana XAI Explicabilidad Local con Árboles de Decisión para la Salud

- Revisión de Pictory (julio de 2023) ¿El mejor generador de video de IA?

Aunque la explicación técnica de esto está más allá del alcance de este blog, es posible que notes esto en algunos generadores de imágenes de IA: cuando comienzan a producir imágenes casi idénticas, es probable que el modelo haya colapsado. Quizás un ejemplo más familiar se encuentra en los sitios web de noticias generadas por IA, reseñas y granjas de contenido. Estos sitios están generando automáticamente artículos inexactos desde el punto de vista factual y tienen la capacidad de propagar desinformación a una velocidad alarmante.[1]

Ahora bien, parte de esto puede estar relacionado con alucinaciones de IA, pero también es muy probable que estos generadores de contenido de IA estén recopilando artículos de otros artículos generados por IA y reescribiéndolos automáticamente. Muchos de ellos son instantáneamente reconocibles: típicamente están llenos de anuncios emergentes y tienen muy poco contenido significativo.

Esto es similar a cómo los clones en Multiplicidad se vuelven menos inteligentes y más exagerados con cada generación.

¿Cómo Sucede?

El colapso del modelo puede ocurrir debido a muchos factores, como la falta de diversidad en los datos de entrenamiento, la amplificación de sesgos y el sobreajuste del modelo. Cuando un modelo de IA se entrena con datos generados por IA, esencialmente está aprendiendo de un reflejo de sí mismo. Este reflejo, al igual que en el juego del “teléfono descompuesto”, se distorsiona cada vez más con cada iteración.

Cuando entrenamos IA con IA, se vuelve más y más tonta.

Por ejemplo, toma esta foto de un surfista.

Aquí tienes una de las cuatro descripciones que Midjourney creó a partir de la foto:

“estatua de lei vistiendo un surfista en honolulu, hawaii, con un estilo de bronce claro y rosa, frank frazetta, artes tradicionales de áfrica, oceanía y las américas, arreglos simétricos, ramas retorcidas, estética del arte callejero, narración visual impulsada – ar 4:3”

Aquí están las cuatro versiones generadas por IA de mi foto:

Sí, estos son bastante rosados, pero el primero se ve más cercano al original y no tenía idea de quién era Frank Frazetta, pero luego le pedí que describiera esa imagen y simplemente tomé la primera.

“una estatua para un surfista en la parte superior de una tabla de surf rosa entre algunas flores, al estilo de trazado de rayos, composiciones monocromáticas, olas de arrecife, tomas de ángulo bajo, escenas callejeras llamativas y vibrantes, rtx on – ar 77:58”

Usando lo anterior como descripción, se generaron las cuatro imágenes a continuación.

Ahora esto es bastante interesante pero no parece representar de ninguna manera el original. Eso fue solo dos generaciones alejadas del original… ¿qué sucede si hacemos esto 100, 1000 o 10,000 veces? Ahora, este no es un ejemplo perfecto de aprendizaje degenerativo, sino más bien un ejemplo de entropía de IA. El sistema tiende hacia un estado de cada vez más desorden.

Ideas de las Personas Inteligentes

En un artículo de investigación titulado “La Maldición de la Recursión: Entrenamiento de Datos sobre Datos Generados Hace que los Modelos Olviden”, se discuten los aspectos técnicos del colapso del modelo. Los autores demuestran que puede ocurrir en todos los modelos, no solo en modelos de IA generativos.

Los Modelos se Vuelven Más Tontos (Aprendizaje Degenerativo)

Una de las ideas clave de la investigación es el concepto de “aprendizaje degenerativo”. En el contexto de los modelos de IA, el aprendizaje degenerativo se refiere al proceso en el que, con el tiempo, los modelos pierden su capacidad para representar con precisión la diversidad y complejidad de la distribución original de datos.

Los autores citaron el siguiente ejemplo:

Como puedes ver, dado un texto de entrada, si entrenas cada modelo con datos producidos a partir de generaciones anteriores, se vuelve absurdo.

Esto sucede por varias razones, incluyendo:

- Pérdida de Eventos Raros: A medida que los modelos se entrenan con datos generados por versiones anteriores de sí mismos, tienden a enfocarse en los patrones más comunes y comienzan a olvidar eventos raros o improbables. Esto es similar a los modelos perdiendo su “memoria a largo plazo”, similar a Doug en Multiplicity. A menudo, los eventos raros son singles importantes en los datos, ya sea que representen anomalías en los procesos de fabricación o transacciones fraudulentas. Los eventos raros son importantes para comprender y mantener. Por ejemplo, una práctica común en proyectos de análisis de texto es eliminar palabras “basura”, que pueden ser pronombres, artículos definidos e indefinidos, y así sucesivamente. Sin embargo, para casos de uso de fraude, son los pronombres los que señalan el fraude. Los estafadores tienden a hablar en tercera persona en lugar de primera.

- Amplificación de Sesgos: Cada iteración de entrenamiento con datos generados por IA puede amplificar los sesgos existentes. Dado que la salida del modelo se basa en los datos en los que fue entrenado, cualquier sesgo en los datos de entrenamiento puede ser reforzado y exagerado con el tiempo, también similar a los múltiples Dougs. Ya hemos visto la amplificación de sesgos en el mundo de la IA tradicional, lo que ha llevado a contratación discriminatoria, sesgo racial en la atención médica o tweets discriminatorios. Necesitamos tener controles para detectar y mitigar su perpetuación.

- Estrechamiento de las Capacidades Generativas: Las capacidades generativas del modelo comienzan a estrecharse a medida que se ve más influenciado por sus propias proyecciones de la realidad. El modelo comienza a producir contenido cada vez más homogéneo y menos representativo de la diversidad y los eventos raros que se encuentran en los datos originales. A medida que todo comienza a regresar a la media y a un estado de homogeneidad, esto llevará a una pérdida de originalidad (ya lo vemos en sitios web de recetas). Para LLMs, es la variación la que le da a cada escritor o artista su tono y estilo particular.

- Error de Aproximación Funcional: El artículo menciona que puede ocurrir un error de aproximación funcional si los aproximadores de funciones no son suficientemente expresivos. Este error se puede minimizar utilizando modelos más expresivos, pero demasiada expresividad puede aumentar el ruido y llevar al sobreajuste.

El aprendizaje degenerativo se caracteriza como un ciclo vicioso donde la capacidad del modelo de aprender y representar datos con precisión se deteriora con cada iteración de entrenamiento en contenido generado por AI.

Esto tiene implicaciones significativas para la calidad y confiabilidad del contenido generado por modelos de AI.

Implicaciones del colapso del modelo

Comprender el fenómeno del colapso del modelo es interesante, pero es igualmente importante reconocer sus implicaciones. El colapso del modelo puede tener consecuencias de largo alcance, afectando la calidad, confiabilidad y equidad del contenido generado por AI. Si no se tiene en cuenta adecuadamente, su organización podría estar en riesgo.

Calidad y confiabilidad

A medida que los modelos de AI experimentan aprendizaje degenerativo, la calidad y confiabilidad del contenido que generan puede deteriorarse significativamente. Esto se debe a que los modelos pierden contacto con la distribución de datos original y se ven más influenciados por sus propias proyecciones de la realidad. Por ejemplo, un modelo de AI utilizado para generar artículos de noticias podría comenzar a producir contenido que no es factualmente preciso, excesivamente homogéneo o simplemente noticias falsas.

Equidad y representación

El colapso del modelo puede tener implicaciones serias para la equidad y la representación. A medida que los modelos olvidan eventos raros y sus capacidades generativas se estrechan, es posible que el contenido relacionado con comunidades marginadas o temas menos comunes esté subrepresentado o distorsionado. Esto puede perpetuar sesgos y estereotipos, y contribuir a la exclusión de ciertas voces y perspectivas.

Preocupaciones éticas

Las preocupaciones éticas en torno al colapso del modelo son significativas. Cuando el contenido generado por AI se utiliza en la toma de decisiones, la educación o la difusión de información, la integridad del contenido es primordial. El colapso del modelo puede conducir a la difusión de contenido sesgado, inexacto o homogeneizado, lo cual puede tener implicaciones éticas, especialmente si afecta la vida, las opiniones o el acceso a oportunidades de las personas.

Impacto económico y social

A nivel económico y social, el colapso del modelo puede afectar la confianza y la adopción de tecnologías de AI. Si las empresas y los consumidores no pueden confiar en el contenido generado por modelos de AI, es posible que sean menos propensos a adoptar estas tecnologías. Esto puede tener implicaciones económicas para las industrias que dependen en gran medida de la AI, y implicaciones sociales en términos de percepción pública y confianza en la AI.

Estrategias para mitigar el colapso del modelo

El colapso del modelo, con sus implicaciones de largo alcance, requiere el desarrollo de estrategias para mitigar sus efectos. Aquí hay algunas estrategias que se pueden emplear para prevenir o mitigar el colapso del modelo en sistemas de AI:

Conservar conjuntos de datos originales producidos por humanos

Una de las ideas clave del documento de investigación es la importancia de conservar una copia del conjunto de datos original producido por humanos. Volver a entrenar periódicamente el modelo con estos datos puede ayudar a asegurar que el modelo siga estando fundamentado en la realidad y continúe representando la diversidad y complejidad de las experiencias humanas. Un reciente documento de investigación de Microsoft Research sugirió que entrenar LLMs con datos confiables como libros de texto puede ayudar a mejorar la precisión de los LLMs.

Introducir nuevos conjuntos de datos generados por humanos

Además de conservar conjuntos de datos originales, introducir nuevos conjuntos de datos generados por humanos limpios en el proceso de entrenamiento es beneficioso. Esto puede ayudar a prevenir que el modelo estreche sus capacidades generativas y asegurarse de que continúe aprendiendo y adaptándose a nueva información. A medida que las empresas comienzan a ajustar finamente los LLMs con sus datos corporativos propietarios, esto puede ayudar a evitar la degradación de los LLMs.

Monitoreo y evaluación regular

Monitorear y evaluar regularmente el rendimiento de los modelos de AI es crucial. Al establecer métricas de evaluación y puntos de referencia, es posible detectar signos tempranos de colapso del modelo. Esto permite intervenciones oportunas, como ajustar los datos de entrenamiento o ajustar los parámetros del modelo. Esto no es diferente de nuestra guía tradicional sobre monitoreo de modelos, las empresas deben implementar un marco de MLOps para monitorear continuamente los modelos y los datos en busca de desviaciones. No solo necesitan detectar esto, también necesitarán mecanismos adicionales para asegurarse de que los modelos no estén alucinando y estén produciendo resultados que estén alineados con los objetivos de la empresa, lo cual será una nueva capacidad para muchas organizaciones.

Diversificar los datos de entrenamiento

Asegurarse de que los datos de entrenamiento sean diversos y representativos de diferentes perspectivas y experiencias puede ayudar a prevenir sesgos y garantizar la equidad en el contenido generado por AI. Esto incluye garantizar la representación de comunidades subrepresentadas y eventos raros. Esto va sin decir, las organizaciones deben comprender los datos de origen que se utilizaron para entrenar el modelo para asegurarse de que esté alineado con la realidad y represente lo mejor de lo que la sociedad podría ser. Utilizar indiscriminadamente datos de internet que están llenos de negatividad, sesgos y desinformación es una receta para el desastre.

Coordinación y Colaboración Comunitaria

El colapso del modelo no es solo un desafío técnico, sino también ético y social. La coordinación a nivel comunitario que involucre a empresas de IA, productores de contenido, investigadores y responsables de políticas es esencial. Compartir información, mejores prácticas y colaborar en el desarrollo de estándares y pautas puede ser fundamental para abordar el colapso del modelo. Aunque las pautas y los marcos son buenos, al igual que el Marco de Ética de IA de las Naciones Unidas, hacer cumplir y obtener aceptación en las fronteras geopolíticas será un desafío.

Resumen

En Multiplicity, el intento de Doug de clonarse a sí mismo para manejar sus responsabilidades conduce al caos y la entropía no intencionales. Este escenario encuentra un paralelo en el mundo de la IA, donde entrenar modelos en datos generados por IA puede llevar a una forma de entropía conocida como colapso del modelo.

Así como los clones en la película se vuelven más tontos y caóticos con cada generación, los modelos de IA pueden perder su capacidad para representar con precisión la diversidad y complejidad de los datos originales mientras se entrenan con sus propias salidas.

El colapso del modelo, similar a la entropía en Multiplicity, tiene implicaciones de gran alcance para la calidad, confiabilidad y equidad del contenido generado por IA. Es un recordatorio de que la replicación descontrolada, ya sea clones en una película o IA que se entrena con sus propios datos, puede llevar a una pérdida de información y un aumento del desorden.

Sin embargo, a diferencia de la clonación descontrolada en Multiplicity, tenemos las herramientas y el conocimiento para gestionar y mitigar el colapso del modelo en los sistemas de IA. Al retener conjuntos de datos originales producidos por humanos, diversificar los datos de entrenamiento, monitorear regularmente los modelos de IA y fomentar la coordinación comunitaria, podemos contrarrestar la entropía y garantizar que la IA siga siendo una herramienta confiable y beneficiosa.

A medida que la IA continúa evolucionando, es imperativo recordar las lecciones de Multiplicity, la entropía y la investigación sobre el colapso del modelo. A través de esfuerzos colectivos, podemos practicar la IA de manera responsable, asegurando que permanezca fundamentada en la realidad y sirva a las diversas necesidades de todas las comunidades, sin caer en el caos.

En esencia, al gestionar activamente el ‘proceso de clonación’ de los datos de IA y ser conscientes de la entropía que puede crear, podemos orientar el desarrollo de la IA en una dirección que sea tanto innovadora como responsable.

Si desea obtener más información sobre la Inteligencia Artificial, consulte mi libro “Inteligencia Artificial: Una Guía Ejecutiva para Hacer que la IA Funcione para su Negocio” en Amazon.

[1] Thompson, Stuart A. 2023. “Contenido Generado por AI Descubierto en Sitios de Noticias, Granjas de Contenido y Reseñas de Productos”. The New York Times, 19 de mayo de 2023, sección Tecnología. https://www.nytimes.com/2023/05/19/technology/ai-generated-content-discovered-on-news-sites-content-farms-and-product-reviews.html.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Kevin Baragona, Co-Fundador y CEO de DeepAI – Serie de Entrevistas

- Un novedoso modelo de aprendizaje automático acelera la evaluación de catalizadores de descarbonización de meses a milisegundos

- Un estudio encuentra que ChatGPT aumenta la productividad de los trabajadores en algunas tareas de escritura

- Tutorial de Docker para Científicos de Datos

- Desbloquea el éxito de DataOps con DataOps.live – ¡Destacado en la Guía de Mercado de Gartner!

- La cirugía cerebral impulsada por IA se convierte en una realidad en Hong Kong

- Conoce FlexGen un motor de generación de alto rendimiento para ejecutar grandes modelos de lenguaje (LLM) con memoria limitada de GPU.