La necesidad de un gradiente de explicabilidad en IA

El gradiente de explicabilidad en IA

Demasiado detalle puede resultar abrumador, pero un detalle insuficiente puede ser engañoso.

“Cualquier tecnología suficientemente avanzada es indistinguible de la magia” – Arthur C. Clarke

¡Con los avances en los autos autónomos, la visión por computadora y más recientemente, los modelos de lenguaje grandes, la ciencia a veces puede sentirse como magia! Los modelos se están volviendo cada vez más complejos cada día, y puede ser tentador agitar las manos en el aire y murmurar algo sobre retropropagación y redes neuronales al intentar explicar modelos complejos a una nueva audiencia. Sin embargo, es necesario describir un modelo de IA, su impacto esperado y posibles sesgos, y ahí es donde entra en juego la IA Explicable.

Con la explosión de métodos de IA en la última década, los usuarios han llegado a aceptar las respuestas que se les dan sin cuestionar. Todo el proceso del algoritmo a menudo se describe como una caja negra, y no siempre es sencillo o incluso posible comprender cómo el modelo llegó a un resultado específico, incluso para los investigadores que lo desarrollaron. Para generar confianza y seguridad en sus usuarios, las empresas deben caracterizar la equidad, la transparencia y los procesos subyacentes de toma de decisiones de los diferentes sistemas que emplean. Este enfoque no solo conduce a un enfoque responsable hacia los sistemas de IA, sino que también aumenta la adopción de la tecnología (https://www.mckinsey.com/capabilities/quantumblack/our-insights/global-survey-the-state-of-ai-in-2020).

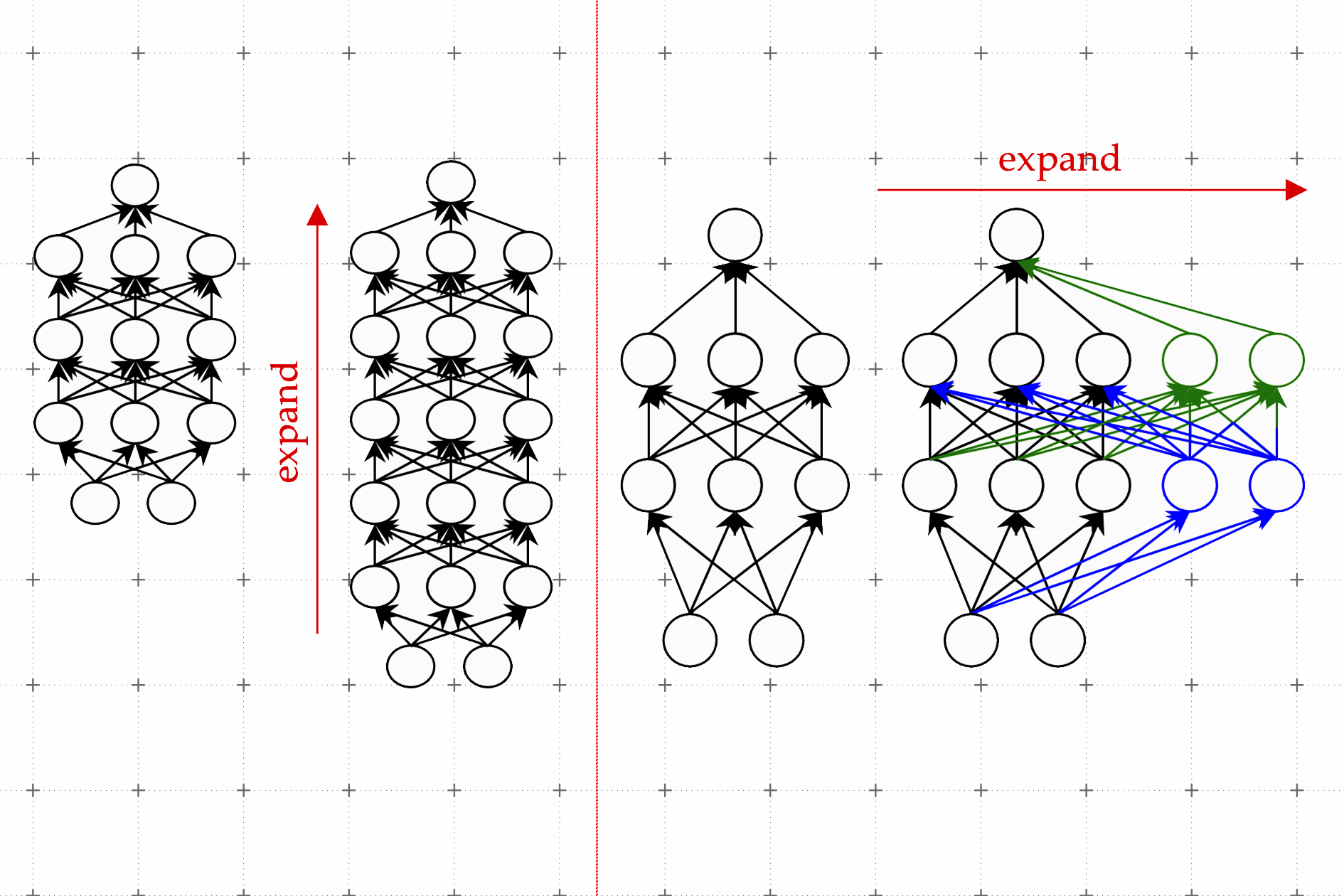

Una de las partes más difíciles de la explicabilidad en la IA es definir claramente los límites de lo que se está explicando. Un ejecutivo y un investigador de IA no requerirán y aceptarán la misma cantidad de información. Encontrar el nivel adecuado de información entre explicaciones directas y todas las diferentes rutas posibles requiere mucho entrenamiento y retroalimentación. Contrariamente a la creencia común, eliminar las matemáticas y la complejidad de una explicación no la vuelve insignificante. Es cierto que existe el riesgo de simplificar demasiado y engañar a la persona haciéndole creer que tiene una comprensión profunda del modelo y de lo que puede hacer con él. Sin embargo, el uso de las técnicas adecuadas puede proporcionar explicaciones claras en el nivel adecuado que llevarían a la persona a hacer preguntas a otra persona, como un científico de datos, para continuar…

- Sobrevive al Apocalipsis del Mercado Laboral de IA Guía de Supervivencia – Parte 1

- Los 8 mejores complementos de ChatGPT para 2023 (y cómo usarlos)

- LGBMClassifier Una Guía de Inicio Rápido

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Inmersión profunda en las Unidades Recurrentes con Puertas (GRU) Entendiendo las Matemáticas detrás de las RNN

- Explorando NLP – Comenzando con NLP (Paso #1)

- Explorando el Procesamiento del Lenguaje Natural – Inicio de NLP (Paso #2)

- Explorando NLP – Iniciando NLP (Paso #3)

- Guía completa de métricas de evaluación de clasificación

- ¿Qué tan aleatorios son los goles en el fútbol?

- Consulta tus DataFrames con potentes modelos de lenguaje grandes utilizando LangChain.