Crea una puerta de enlace de IA generativa para permitir el consumo seguro y conforme de modelos base.

Crear una plataforma de IA generativa para un consumo seguro y compatible con los modelos base.

En el mundo en constante evolución de la IA (Inteligencia Artificial) y el aprendizaje automático (Machine Learning), los modelos de base (FMs) han demostrado un tremendo potencial para impulsar la innovación y desbloquear nuevos casos de uso. Sin embargo, a medida que las organizaciones aprovechan cada vez más el poder de los FMs, las preocupaciones relacionadas con la privacidad de los datos, la seguridad, el costo adicional y el cumplimiento se han vuelto primordiales. Las industrias reguladas y orientadas al cumplimiento, como los servicios financieros, la atención médica y las ciencias de la vida, y los institutos gubernamentales, enfrentan desafíos únicos para garantizar el consumo seguro y responsable de estos modelos. Para encontrar un equilibrio entre la agilidad, la innovación y el cumplimiento de los estándares, se vuelve esencial una plataforma sólida. En esta publicación, proponemos Generative AI Gateway como plataforma para permitir el acceso seguro a los FMs para una innovación rápida.

En esta publicación, definimos qué es un Generative AI Gateway, sus beneficios y cómo diseñar uno en AWS. Un Generative AI Gateway puede ayudar a las grandes empresas a controlar, estandarizar y gobernar el consumo de FM desde servicios como Amazon Bedrock, Amazon SageMaker JumpStart, proveedores de modelos de terceros (como Anthropic y sus APIs) y otros proveedores de modelos fuera del ecosistema de AWS.

¿Qué es un Generative AI Gateway?

Para las API tradicionales (como REST o gRPC), API Gateway se ha establecido como un patrón de diseño que permite a las empresas estandarizar y controlar cómo se externalizan y consumen las API. Además, los registros de API permiten la gobernabilidad centralizada, el control y la capacidad de descubrimiento de las API.

De manera similar, Generative AI Gateway es un patrón de diseño que tiene como objetivo ampliar los patrones de API Gateway y Registro con consideraciones específicas para la prestación y el consumo de modelos de base en entornos de grandes empresas. Por ejemplo, manejar alucinaciones, administrar IPs y EULAs (Acuerdos de Licencia de Usuario Final) específicos de la empresa, así como moderar generaciones, son nuevas responsabilidades que van más allá del alcance de los API Gateway tradicionales.

- Más allá de la predicción El delicado equilibrio de servir a los clientes y hacer crecer tu negocio

- Mejorando la precisión de la puntuación de sentimiento con FinBERT y abrazando los principios SOLID.

- Automatizar la autorización previa utilizando CRD con CDS Hooks y AWS HealthLake

Además de los requisitos específicos para la IA generativa, el panorama tecnológico y regulatorio de los modelos de base está cambiando rápidamente. Esto crea desafíos únicos para las organizaciones en términos de equilibrar la velocidad de la innovación y el cumplimiento. Por ejemplo:

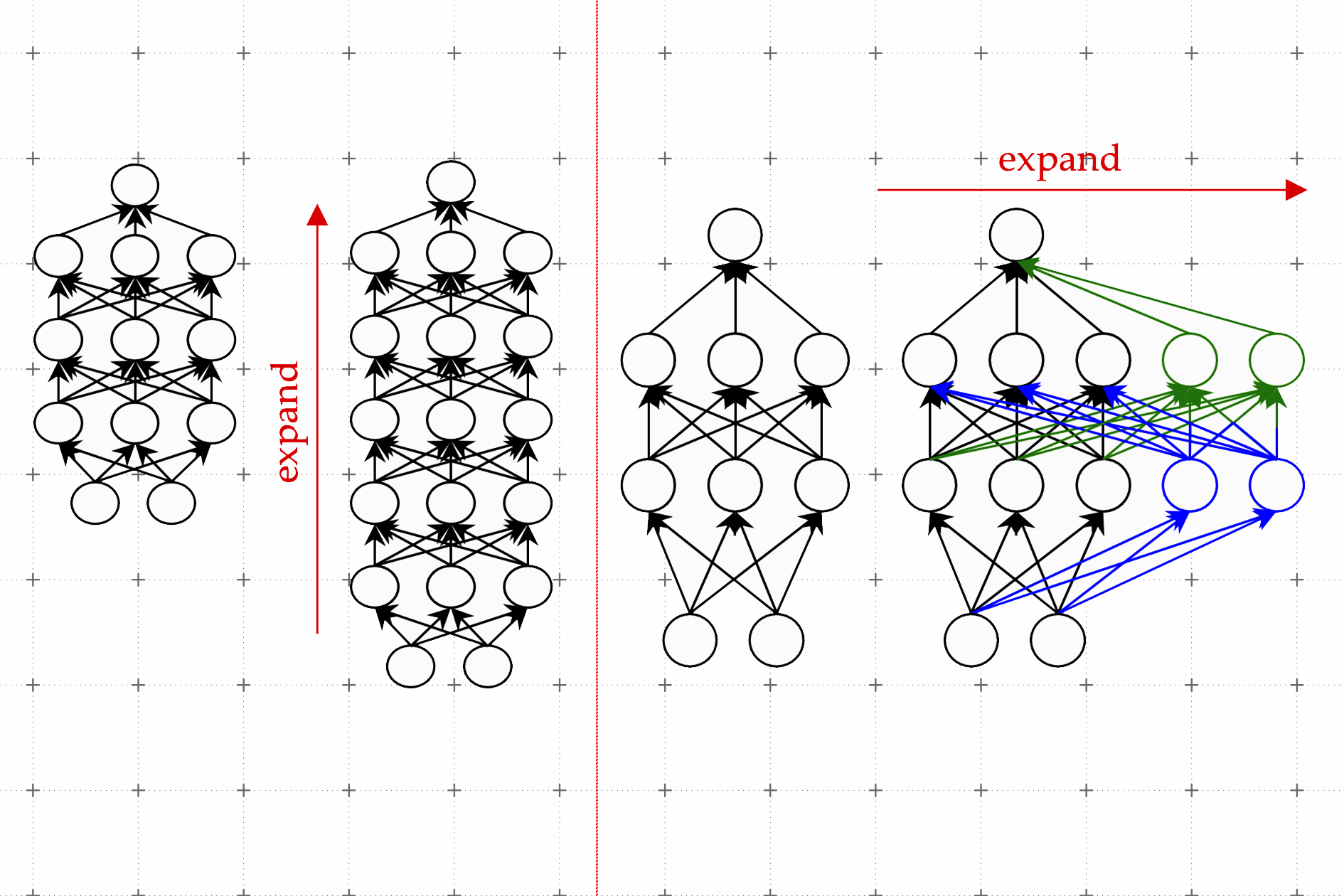

- El estado del arte (SOTA) de los modelos, arquitecturas y mejores prácticas está cambiando constantemente. Esto significa que las empresas necesitan un acoplamiento suelto entre los clientes de la aplicación (consumidores del modelo) y los puntos finales de inferencia del modelo, lo que garantiza un cambio fácil entre modelos de lenguaje de gran tamaño (LLM), modelos de visión o modelos multimodales si es necesario. Una capa de abstracción sobre los puntos finales de inferencia del modelo proporciona ese acoplamiento suelto.

- La incertidumbre regulatoria, especialmente sobre la propiedad intelectual y la privacidad de los datos, requiere la observabilidad, el monitoreo y el seguimiento de las generaciones. Por ejemplo, si las aplicaciones basadas en Retrieval Augmented Generation (RAG) incluyen accidentalmente información de identificación personal (PII) en su contexto, es necesario detectar estos problemas en tiempo real. Esto se vuelve desafiante si las grandes empresas con múltiples equipos de ciencia de datos utilizan plataformas distribuidas y personalizadas para implementar modelos de base.

Generative AI Gateway busca resolver estos nuevos requisitos al proporcionar los mismos beneficios que los API Gateway y Registros tradicionales, como la gobernabilidad centralizada y la observabilidad, y la reutilización de componentes comunes.

Resumen de la solución

En concreto, Generative AI Gateway proporciona los siguientes componentes clave:

- Una capa de abstracción de modelo para FMs aprobados

- Un API Gateway para FMs (AI Gateway)

- Un espacio de trabajo para FMs para descubrir internamente modelos

El siguiente diagrama ilustra la arquitectura de la solución.

Para una mayor resiliencia, la solución sugerida puede implementarse en un entorno Multi-AZ (zona de disponibilidad múltiple). Las líneas punteadas en el diagrama anterior representan los límites de red, aunque toda la solución se puede implementar en una sola VPC (Virtual Private Cloud).

Capa de abstracción de modelo

La capa de abstracción de modelo sirve como base para el acceso seguro y controlado al conjunto de FMs de la organización. La capa proporciona una única fuente de verdad sobre qué modelos están disponibles para la empresa, el equipo y el empleado, así como cómo acceder a cada modelo almacenando información sobre los puntos finales para cada modelo.

Esta capa es el pilar para el consumo seguro, cumplimiento y ágil de FMs a través del Generative AI Gateway, promoviendo prácticas de IA responsables dentro de la organización.

La capa en sí misma consta de cuatro componentes principales:

- Registro de puntos finales de FM – Después de que los FMs se evalúan, aprueban e implementan para su uso, sus puntos finales se agregan al registro de puntos finales de FM, un repositorio centralizado de todos los puntos finales API implementados o accesibles externamente. El registro contiene metadatos sobre los puntos finales de servicio de IA generativa que una organización consume, ya sea un FM implementado internamente o una API de IA generativa proporcionada externamente por un proveedor. Los metadatos incluyen información sobre los puntos finales de servicio para cada modelo de base y su configuración, y políticas de acceso (basadas en funciones, equipos, etc.).

- Almacenamiento y motor de políticas del modelo – Para que los FMs se consuman de manera compatible, la capa de abstracción de modelo debe realizar un seguimiento de las reglas cualitativas y cuantitativas para las generaciones del modelo. Por ejemplo, algunas generaciones pueden estar sujetas a ciertas regulaciones, como CCPA (Ley de Privacidad del Consumidor de California), que requiere un comportamiento de generación personalizado según la ubicación geográfica. Por lo tanto, las políticas deben tener en cuenta el país y la ubicación geográfica para garantizar el cumplimiento en entornos regulatorios cambiantes en diferentes lugares.

- Capa de identidad – Después de que los modelos están disponibles para ser consumidos, la capa de identidad desempeña un papel fundamental en la gestión de accesos, asegurándose de que solo los usuarios o roles autorizados dentro de la organización puedan interactuar con FMs específicos a través del AI Gateway. Los mecanismos de control de acceso basados en roles (RBAC) ayudan a definir permisos de acceso granulares, asegurando que los usuarios puedan acceder a modelos según sus roles y responsabilidades.

- Integración con registros de modelos de proveedores – Los FMs pueden estar disponibles de diferentes maneras, ya sea implementados en cuentas de organización bajo VPCs o disponibles como API a través de diferentes proveedores. Después de pasar las verificaciones iniciales mencionadas anteriormente, el registro de puntos finales tiene la información necesaria sobre estos modelos de los proveedores y sus versiones expuestas a través de API. Esto abstrae las complejidades subyacentes para el usuario final.

Para poblar el registro de puntos finales del modelo de IA, el equipo del Generative AI Gateway colabora con un equipo multidisciplinario de expertos en el campo y los interesados en la línea de negocio para seleccionar y embarcar cuidadosamente a los FM en la plataforma. Durante esta fase de embarque, se tienen en cuenta factores como el rendimiento del modelo, el coste, la alineación ética, el cumplimiento de las regulaciones de la industria y la reputación del proveedor. Mediante una evaluación exhaustiva, las organizaciones aseguran que los FM seleccionados se ajusten a sus necesidades específicas y cumplan con los requisitos de seguridad y privacidad.

El siguiente diagrama ilustra la arquitectura de esta capa.

Los servicios de AWS pueden ayudar a construir una capa de abstracción de modelos (MAL) de la siguiente manera:

- El gerente de IA generativa crea una tabla de registro utilizando Amazon DynamoDB. Esta tabla se llena con información sobre los FM desplegados internamente en la cuenta de la organización o accesibles a través de una API de los proveedores. Esta tabla almacenará el punto final, metadatos y parámetros de configuración del modelo. También puede almacenar la información si se necesita una función personalizada de AWS Lambda para invocar al FM subyacente con clientes de API específicos del proveedor.

- El gerente de IA generativa determina luego el acceso para el usuario, agrega límites, añade una política para el tipo de generaciones que el usuario puede realizar (imágenes, texto, multimodalidad, etc.) y agrega otras políticas específicas de la organización, como la IA responsable y los filtros de contenido, que se añadirán como una tabla de política separada en DynamoDB.

- Cuando el usuario realiza una solicitud utilizando el AI Gateway, se envía a Amazon Cognito para determinar el acceso para el cliente. Un autorizador de Lambda ayuda a determinar el acceso desde la capa de identidad, que será gestionada por la política de la tabla de DynamoDB. Si el cliente tiene acceso, se obtienen desde AWS Secrets Manager el acceso relevante, como el (IAM) de AWS Identity and Access Management o la clave API para el punto final del FM. Además, en esta etapa se explora el registro para encontrar el punto final y la configuración relevantes.

- Una vez que se obtiene toda la información necesaria relacionada con la solicitud, como el punto final, la configuración, las claves de acceso y la función personalizada, se devuelve al AI Gateway para ser utilizado con la función de despacho Lambda que llama a un punto final de modelo específico.

AI Gateway

El AI Gateway sirve como un componente crucial que facilita el consumo seguro y eficiente de los FM dentro de la organización. Opera sobre la capa de abstracción del modelo, proporcionando una interfaz basada en API para los usuarios internos, incluyendo desarrolladores, científicos de datos y analistas de negocios.

A través de esta interfaz fácil de usar (programática y basada en una interfaz de usuario de centro de juegos), los usuarios internos pueden acceder, interactuar y utilizar de manera transparente los modelos curados de la organización, asegurando que los modelos relevantes estén disponibles según sus identidades y responsabilidades. Un AI Gateway puede incluir lo siguiente:

- Una interfaz de API unificada para todos los FM: El AI Gateway presenta una interfaz de API unificada y un SDK que abstrae las complejidades técnicas subyacentes, permitiendo a los usuarios internos interactuar con el conjunto de FM de la organización fácilmente. Los usuarios pueden utilizar las APIs para invocar diferentes modelos y enviar sus indicaciones para obtener la generación del modelo.

- Gestión de cuotas, límites y uso de la API: Esto incluye lo siguiente:

- Cuota consumida: Para permitir la asignación eficiente de recursos y el control de costos, el AI Gateway proporciona a los usuarios información sobre su cuota consumida para cada modelo. Esta transparencia permite a los usuarios gestionar de manera efectiva el uso de los recursos de IA, asegurando una utilización óptima y evitando el desperdicio de recursos.

- Solicitud de alojamiento dedicado: Reconociendo la importancia de la asignación de recursos para casos de uso críticos, el AI Gateway permite a los usuarios solicitar alojamiento dedicado para modelos específicos. Los usuarios con aplicaciones de alta prioridad o sensibles a la latencia pueden utilizar esta función para garantizar un entorno consistente y dedicado para sus necesidades de inferencia de modelos.

- Control de acceso y gobierno de modelos: Utilizando la capa de identidad de la capa de abstracción del modelo, el AI Gateway impone estrictos controles de acceso. La identidad de cada usuario y los roles asignados determinan los modelos a los que pueden acceder. Este control de acceso granular asegura que los usuarios solo tengan acceso a los modelos relevantes para sus dominios, manteniendo la seguridad y privacidad de los datos mientras se promueve el uso responsable de la IA.

- Aplicación de políticas de contenido, privacidad y IA responsable: El AI Gateway emplea tanto la preprocesamiento como el postprocesamiento de todas las entradas al modelo, así como las generaciones del modelo para filtrar y moderar la toxicidad, violencia, daño, datos de PII y más, que son especificados por la capa de abstracción del modelo para su filtrado. Centralizar esta función en el AI Gateway asegura su cumplimiento y facilita su auditoría.

Al integrar la Puerta de enlace de IA con la capa de abstracción del modelo e incorporar características como el control de acceso basado en identidad, la lista de modelos y la visualización de metadatos, el monitoreo de la cuota consumida y las solicitudes de alojamiento dedicado, las organizaciones pueden crear una plataforma poderosa de consumo de IA.

Además, la Puerta de enlace de IA proporciona los beneficios estándar de las Puertas de enlace de API, como los siguientes:

- Mecanismo de control de costos – Para optimizar la asignación de recursos y gestionar los costos de manera efectiva, se puede implementar un robusto mecanismo de control de costos. Este mecanismo monitorea el uso de recursos, los costos de inferencia del modelo y los gastos de transferencia de datos. Permite a las organizaciones obtener información sobre el gasto de recursos de IA generativa, identificar oportunidades de ahorro de costos y tomar decisiones informadas sobre la asignación de recursos.

- Caché – La inferencia de los FMs puede volverse costosa, especialmente durante las fases de prueba y desarrollo de la aplicación. Una capa de caché puede ayudar a reducir ese costo e incluso mejorar la velocidad al mantener una caché para las solicitudes frecuentes. La caché también descarga la carga de inferencia en el punto final, lo que deja espacio para otras solicitudes.

- Observabilidad – Esto desempeña un papel crucial en la captura de las actividades realizadas en la Puerta de enlace de IA y el Discovery Playground. Registros detallados registran las interacciones del usuario, las solicitudes de modelos y las respuestas del sistema. Estos registros proporcionan información valiosa para la solución de problemas, el seguimiento del comportamiento del usuario y el fortalecimiento de la transparencia y la responsabilidad.

- Cuotas, límites de velocidad y limitación – El aspecto de gobierno de esta capa puede incorporar la aplicación de cuotas, límites de velocidad y limitación para gestionar y controlar el uso de recursos de IA. Las cuotas definen el número máximo de solicitudes que un usuario o equipo puede realizar dentro de un marco de tiempo específico, asegurando una distribución justa de recursos. Los límites de velocidad evitan el uso excesivo de recursos al imponer una frecuencia máxima de solicitud. La limitación mitiga el riesgo de sobrecarga del sistema controlando la frecuencia de las solicitudes entrantes, evitando interrupciones del servicio.

- Registros de auditoría y monitoreo de uso – El equipo asume la responsabilidad de mantener registros de auditoría detallados de todo el ecosistema. Estos registros permiten monitorizar de manera integral el uso, lo que permite al equipo central hacer un seguimiento de las actividades del usuario, identificar posibles riesgos y mantener la transparencia en el consumo de IA.

El siguiente diagrama ilustra esta arquitectura.

Los servicios de AWS pueden ayudar en la construcción de una Puerta de enlace de IA de la siguiente manera:

- El usuario realiza la solicitud utilizando Amazon API Gateway, que se enruta a la capa de abstracción del modelo después de autenticar y autorizar la solicitud.

- La Puerta de enlace de IA impone límites de uso para las solicitudes de cada usuario utilizando políticas de límite de uso devueltas por el MAL. Para facilitar la aplicación, utilizamos la capacidad nativa de API Gateway para aplicar la medición. Además, realizamos validaciones estándar de API Gateway en la solicitud utilizando un esquema JSON.

- Después de validar los límites de uso, tanto la configuración del punto final como las credenciales recibidas del MAL forman la carga útil de inferencia real utilizando interfaces nativas proporcionadas por cada uno de los proveedores de modelos aprobados. La capa de despacho normaliza las diferencias entre los SDK e interfaces de API de los proveedores para proporcionar una interfaz unificada al cliente. Problemas como cambios de DNS, equilibrio de carga y caché también podrían ser gestionados por un servicio de despacho más sofisticado.

- Después de recibir la respuesta de los puntos finales de modelo subyacentes, las funciones Lambda de postprocesamiento utilizan las políticas del MAL relacionadas con el contenido (toxicidad, desnudez, etc.) y el cumplimiento (CCPA, GDPR, etc.) para filtrar o enmascarar las generaciones en su totalidad o en parte.

- A lo largo del ciclo de vida de la solicitud, todas las generaciones y cargas útiles de inferencia se registran a través de Amazon CloudWatch Logs, que se pueden organizar mediante grupos de registros según las etiquetas y las políticas recuperadas del MAL. Por ejemplo, los registros se pueden separar por proveedor de modelo y ubicación geográfica. Esto permite una mejora y solución de problemas adicionales del modelo.

- Finalmente, hay disponible una auditoría retrospectiva a través de AWS CloudTrail.

Discovery Playground

El último componente es introducir un Discovery Playground, que presenta una interfaz amigable para el usuario construida sobre la capa de abstracción del modelo y la Puerta de enlace de IA, ofreciendo un entorno dinámico para que los usuarios exploren, prueben y aprovechen todo el potencial de los FMs disponibles. Además de proporcionar acceso a las capacidades de IA, el playground permite a los usuarios interactuar con los modelos utilizando una interfaz de usuario rica, proporcionar comentarios valiosos y compartir sus descubrimientos con otros usuarios dentro de la organización. Ofrece las siguientes características clave:

- Interfaz Playground – Puedes ingresar fácilmente instrucciones y recibir resultados del modelo en tiempo real. La interfaz simplifica el proceso de interacción, haciendo que la exploración de la inteligencia artificial generativa sea accesible para usuarios con diferentes niveles de experiencia técnica.

- Tarjetas de modelo – Puedes acceder a una lista completa de modelos disponibles junto con sus metadatos correspondientes. Puedes explorar información detallada sobre cada modelo, como sus capacidades, métricas de rendimiento y casos de uso compatibles. Esta función facilita la toma de decisiones informadas, permitiéndote seleccionar el modelo más adecuado para tus necesidades específicas.

- Mecanismo de retroalimentación – Un aspecto diferenciador del playground es su mecanismo de retroalimentación, que te permite proporcionar información sobre los resultados del modelo. Puedes informar problemas como alucinaciones (información fabricada), lenguaje inapropiado o cualquier comportamiento no intencionado observado durante la interacción con los modelos.

- Recomendaciones para casos de uso – El Playground de Descubrimiento puede estar diseñado para facilitar el aprendizaje y comprensión de las capacidades de los FMs para diferentes casos de uso. Puedes experimentar con diferentes instrucciones y descubrir qué modelos destacan en escenarios específicos.

Al ofrecer una interfaz de usuario intuitiva, tarjetas de modelo, mecanismo de retroalimentación, recomendaciones para casos de uso y la opción de Example Store, el Playground de Descubrimiento se convierte en una plataforma poderosa para la exploración de la inteligencia artificial generativa y el intercambio de conocimientos dentro de la organización.

Consideraciones de proceso

Mientras que los módulos anteriores de Generative AI Gateway ofrecen una plataforma, esta capa es más práctica, asegurando el consumo responsable y conforme de los FMs dentro de la organización. Incluye medidas adicionales que van más allá de los aspectos técnicos, centrándose en consideraciones legales, prácticas y regulatorias. Esta capa presenta responsabilidades cruciales para el equipo central en materia de seguridad de datos, licencias, regulaciones organizativas y rastros de auditoría, fomentando una cultura de confianza y transparencia:

- Seguridad y privacidad de datos – Debido a que los FMs pueden procesar grandes cantidades de datos, la seguridad y privacidad de los datos se convierten en preocupaciones primordiales. El equipo central es responsable de implementar medidas robustas de seguridad de datos, que incluyen encriptación, controles de acceso y anonimización de datos. Se garantiza diligentemente el cumplimiento de las regulaciones de protección de datos, como el GDPR, HIPAA u otros estándares específicos de la industria, para salvaguardar la información sensible y la privacidad de los usuarios.

- Monitoreo de datos – Debe establecerse un sistema integral de monitoreo de datos para rastrear la información entrante y saliente a través de AI Gateway y Discovery Playground. Esto incluye monitorear las instrucciones proporcionadas por los usuarios y los resultados del modelo correspondientes. El mecanismo de monitoreo de datos permite a la organización observar patrones de datos, detectar anomalías y garantizar que la información sensible permanezca segura.

- Licencias y acuerdos de modelos – El equipo central debe encargarse de administrar las licencias y acuerdos asociados con el uso de los modelos. Los modelos proporcionados por los proveedores pueden tener acuerdos de uso específicos, restricciones de uso o términos de licencia. El equipo garantiza el cumplimiento de estos acuerdos y mantiene un repositorio completo de todas las licencias, asegurando una comprensión clara de los derechos y limitaciones relacionados con cada modelo.

- Consideraciones éticas – A medida que los sistemas de IA se vuelven cada vez más sofisticados, el equipo central asume la responsabilidad de garantizar la alineación ética en el uso de la IA. Evalúan los modelos en busca de posibles sesgos, resultados perjudiciales o comportamiento no ético. Se toman medidas para mitigar estos problemas y fomentar el desarrollo y despliegue responsable de AI dentro de la organización.

- Adaptación proactiva – Para estar a la vanguardia de los desafíos emergentes y las regulaciones en constante cambio, el equipo central adopta un enfoque proactivo para la gobernanza. Actualizan continuamente las políticas, los estándares de modelos y las medidas de cumplimiento para alinearse con las últimas prácticas de la industria y los requisitos legales. Esto asegura que el ecosistema de IA de la organización cumpla con los estándares éticos y de cumplimiento.

Conclusión

Generative AI Gateway permite a las organizaciones utilizar modelos fundamentales de manera responsable y segura. A través de la integración de la capa de abstracción de modelos, AI Gateway y Discovery Playground, impulsados con monitoreo, observabilidad, gobernanza, seguridad, cumplimiento y capas de auditoría, las organizaciones pueden encontrar un equilibrio entre innovación y cumplimiento. AI Gateway te brinda acceso sin problemas a modelos seleccionados, mientras que Discovery Playground fomenta la exploración y la retroalimentación. El monitoreo y la gobernanza proporcionan información para una asignación de recursos optimizada y una toma de decisiones proactiva. Con un enfoque en la seguridad, el cumplimiento y las prácticas éticas de IA, Generative AI Gateway abre las puertas a un futuro donde las aplicaciones impulsadas por AI prosperan de manera responsable, desbloqueando nuevos ámbitos de posibilidades para las organizaciones.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- OpenAI presenta DALL-E 3 y los usuarios pueden generar imágenes en ChatGPT

- Tom Hanks advierte a sus seguidores sobre Deepfakes generados con IA

- Guía para no ingenieros Entrena a un chatbot LLaMA 2.

- Principales Sesiones de Aprendizaje Profundo Llegando a ODSC West

- Cómo hacer tu propio horario de ODSC West

- Boletín de Ética y Sociedad #5 Hugging Face va a Washington y otros divagaciones del verano de 2023

- 🧨 Acelerando la difusión estable de inferencia XL con JAX en TPU en la nube v5e