Primer aniversario de ChatGPT dando forma al futuro de la interacción AI

Primer aniversario de ChatGPT moldeando el futuro de la interacción IA

Reflexionando sobre el primer año de ChatGPT, es claro que esta herramienta ha cambiado significativamente el panorama de la IA. Lanzado a finales de 2022, ChatGPT destacó por su estilo conversacional y fácil de usar, lo que hizo que interactuar con la IA se sintiera más como chatear con una persona que con una máquina. Este nuevo enfoque rápidamente llamó la atención del público. Tan solo cinco días después de su lanzamiento, ChatGPT ya había atraído a un millón de usuarios. A principios de 2023, este número aumentó a aproximadamente 100 millones de usuarios mensuales, y para octubre, la plataforma estaba recibiendo alrededor de 1.7 mil millones de visitas en todo el mundo. Estas cifras hablan por sí solas sobre su popularidad y utilidad.

A lo largo del último año, los usuarios han encontrado todo tipo de formas creativas de utilizar ChatGPT, desde tareas simples como escribir correos electrónicos y actualizar currículums hasta comenzar negocios exitosos. Pero no se trata solo de cómo lo utilizan las personas; la tecnología en sí misma ha crecido y mejorado. Inicialmente, ChatGPT era un servicio gratuito que ofrecía respuestas de texto detalladas. Ahora, existe ChatGPT Plus, que incluye ChatGPT-4. Esta versión actualizada está entrenada con más datos, ofrece menos respuestas incorrectas y comprende mejor las instrucciones complejas.

Una de las mayores actualizaciones es que ChatGPT ahora puede interactuar de múltiples formas: puede escuchar, hablar e incluso procesar imágenes. Esto significa que puedes hablar con él a través de su aplicación móvil y mostrarle imágenes para obtener respuestas. Estos cambios han abierto nuevas posibilidades para la IA y han cambiado la forma en que las personas ven y piensan sobre el papel de la IA en nuestras vidas.

Desde sus comienzos como una demostración tecnológica hasta su estado actual como un jugador importante en el mundo tecnológico, el viaje de ChatGPT es realmente impresionante. Inicialmente, se veía como una forma de probar y mejorar la tecnología obteniendo retroalimentación del público. Pero rápidamente se convirtió en una parte esencial del panorama de la IA. Este éxito demuestra lo efectivo que es afinar modelos de lenguaje grandes (LLMs, por sus siglas en inglés) con aprendizaje supervisado y retroalimentación de los seres humanos. Como resultado, ChatGPT puede manejar una amplia gama de preguntas y tareas.

- Es probable que las grandes empresas tecnológicas establezcan la política de inteligencia artificial en Estados Unidos. No podemos permitir que eso suceda’.

- Top 40+ Herramientas Generativas de IA (Diciembre 2023)

- Investigadores de Microsoft Research y Georgia Tech revelan los límites estadísticos de las alucinaciones en los modelos de lenguaje

La carrera por desarrollar sistemas de IA más capaces y versátiles ha llevado a una proliferación de modelos tanto de código abierto como propietarios, como ChatGPT. Comprender sus capacidades generales requiere de evaluaciones exhaustivas en una amplia variedad de tareas. Esta sección explora estas evaluaciones, arrojando luz sobre cómo se comparan diferentes modelos, incluido ChatGPT, entre sí.

Evaluación de los LLMs: Los puntos de referencia

- MT-Bench: Este punto de referencia evalúa la capacidad de mantener múltiples conversaciones y seguir instrucciones en ocho dominios: escritura, juego de roles, extracción de información, razonamiento, matemáticas, codificación, conocimientos STEM y humanidades/ciencias sociales. Los LLM más sólidos, como GPT-4, se utilizan como evaluadores.

- AlpacaEval: Basado en el conjunto de evaluación de AlpacaFarm, este evaluador automático basado en LLM compara los modelos con las respuestas de LLMs avanzados como GPT-4 y Claude, calculando la tasa de victorias de los modelos candidatos.

- Open LLM Leaderboard: Utilizando el Conjunto de Evaluación de Modelos de Lenguaje, este marcador evalúa los LLM en siete puntos de referencia clave, incluyendo desafíos de razonamiento y pruebas de conocimientos generales, tanto en la configuración de cero disparos como en la de pocos disparos.

- BIG-bench: Este punto de referencia colaborativo abarca más de 200 tareas novedosas de lenguaje, que abarcan una amplia gama de temas e idiomas. Su objetivo es explorar los LLMs y predecir sus capacidades futuras.

- ChatEval: Un marco de debate multiagente que permite a los equipos discutir y evaluar de manera autónoma la calidad de las respuestas de diferentes modelos en preguntas abiertas y tareas tradicionales de generación de lenguaje natural.

Rendimiento comparativo

En términos de puntos de referencia generales, los LLM de código abierto han mostrado un progreso notable. Por ejemplo, Llama-2-70B logró resultados impresionantes, especialmente después de ser afinado con datos de instrucciones. Su variante, Llama-2-chat-70B, se destacó en AlpacaEval con una tasa de victorias del 92.66%, superando a GPT-3.5-turbo. Sin embargo, GPT-4 sigue siendo el líder con una tasa de victorias del 95.28%.

Zephyr-7B, un modelo más pequeño, demostró capacidades comparables a los LLMs más grandes de 70B, especialmente en AlpacaEval y MT-Bench. Mientras tanto, WizardLM-70B, afinado con una amplia gama de datos de instrucciones, obtuvo la puntuación más alta entre los LLMs de código abierto en MT-Bench. Sin embargo, aún se quedó rezagado detrás de GPT-3.5-turbo y GPT-4.

Una interesante entrada, GodziLLa2-70B, logró una puntuación competitiva en la tabla de clasificación Open LLM, mostrando el potencial de modelos experimentales que combinan conjuntos de datos diversos. De manera similar, Yi-34B, desarrollado desde cero, destacó con puntuaciones comparables a GPT-3.5-turbo y solo ligeramente por detrás de GPT-4.

UltraLlama, con su afinación fina en datos diversos y de alta calidad, igualó a GPT-3.5-turbo en sus referencias propuestas e incluso lo superó en áreas de conocimiento mundial y profesional.

Escalando: El Ascenso de los Grandes LLMs

Los mejores modelos LLM desde 2020

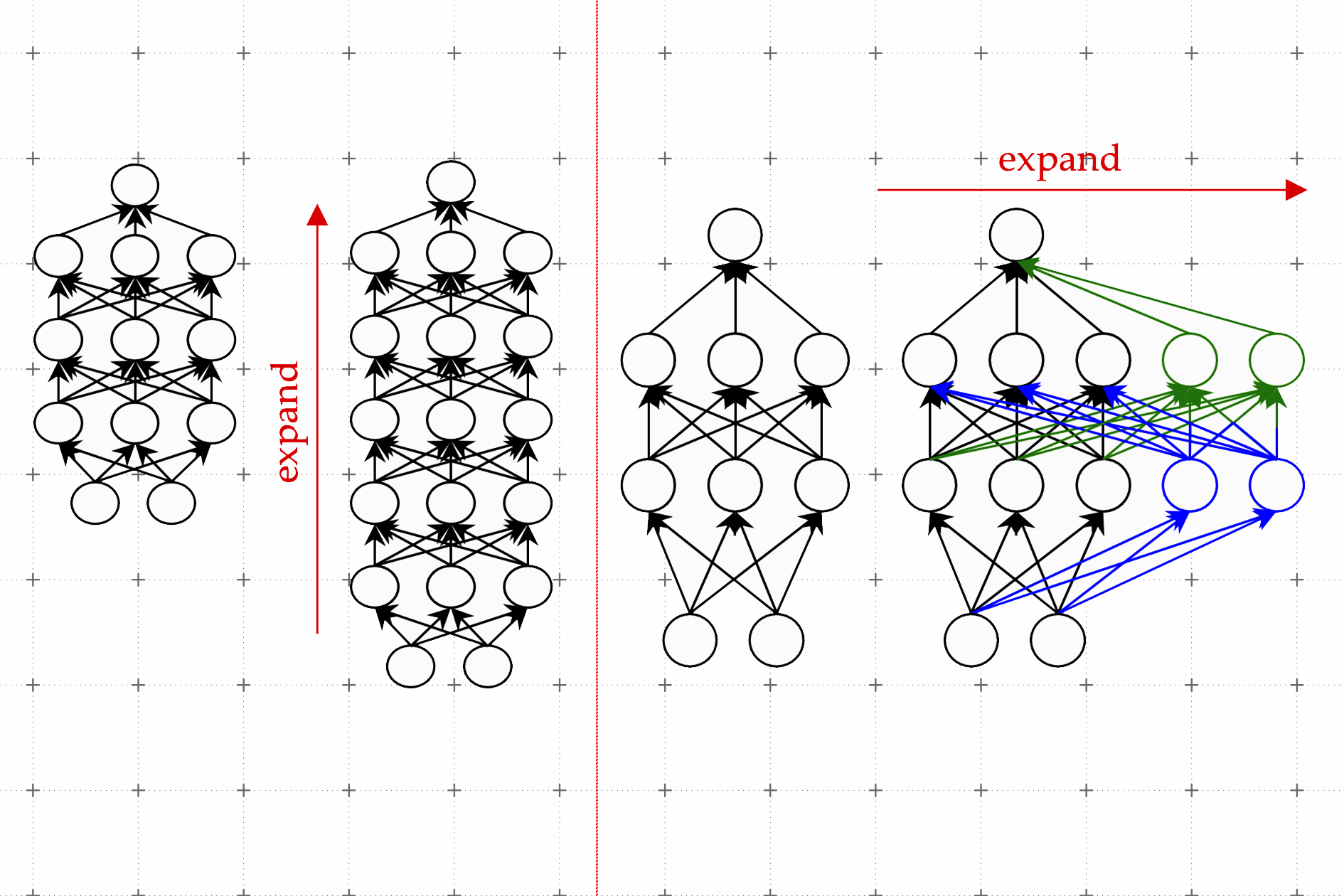

Una tendencia notable en el desarrollo de LLM ha sido el aumento de los parámetros del modelo. Modelos como Gopher, GLaM, LaMDA, MT-NLG y PaLM han empujado los límites, culminando en modelos con hasta 540 mil millones de parámetros. Estos modelos han demostrado capacidades excepcionales, pero su naturaleza de código cerrado ha limitado su aplicación más amplia. Esta limitación ha generado interés en desarrollar LLMs de código abierto, una tendencia que está ganando impulso.

Paralelamente al aumento del tamaño de los modelos, los investigadores han explorado estrategias alternativas. En lugar de simplemente hacer que los modelos sean más grandes, se han centrado en mejorar la preentrenamiento de modelos más pequeños. Ejemplos incluyen Chinchilla y UL2, que han demostrado que más no siempre es mejor; también se pueden obtener resultados eficientes mediante estrategias más inteligentes. Además, se ha prestado considerable atención a la adaptación de instrucciones de los modelos de lenguaje, con proyectos como FLAN, T0 y Flan-T5 que han realizado contribuciones significativas en esta área.

El Catalizador ChatGPT

La introducción de ChatGPT de OpenAI marcó un punto de inflexión en la investigación de Procesamiento del Lenguaje Natural (PLN). Para competir con OpenAI, empresas como Google y Anthropic lanzaron sus propios modelos, Bard y Claude, respectivamente. Si bien estos modelos muestran un rendimiento comparable a ChatGPT en muchas tareas, todavía se quedan atrás del último modelo de OpenAI, GPT-4. El éxito de estos modelos se atribuye principalmente al aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF), una técnica que está recibiendo un mayor enfoque en la investigación para mejorar aún más.

Rumores y Especulaciones sobre Q* (Q-Star) de OpenAI

Informes recientes sugieren que los investigadores de OpenAI podrían haber logrado un avance significativo en IA con el desarrollo de un nuevo modelo llamado Q* (pronunciado Q estrella). Según se rumorea, Q* tiene la capacidad de resolver problemas matemáticos a nivel de educación primaria, un logro que ha suscitado discusiones entre expertos sobre su potencial como hito hacia la inteligencia artificial general (AGI). Si bien OpenAI no ha comentado sobre estos informes, las supuestas habilidades de Q* han generado una considerable emoción y especulación en las redes sociales y entre los entusiastas de la IA.

El desarrollo de Q* es notable porque los modelos de lenguaje existentes, como ChatGPT y GPT-4, si bien son capaces de realizar algunas tareas matemáticas, no son particularmente hábiles para manejarlas de manera confiable. El desafío radica en la necesidad de que los modelos de IA no solo reconozcan patrones, como lo hacen actualmente a través del aprendizaje profundo y los transformadores, sino que también puedan razonar y comprender conceptos abstractos. Las matemáticas, al ser un punto de referencia para el razonamiento, requieren que la IA planifique y ejecute múltiples pasos, demostrando una comprensión profunda de conceptos abstractos. Esta habilidad marcaría un salto significativo en las capacidades de la IA, potencialmente extendiéndose más allá de las matemáticas a otras tareas complejas.

Sin embargo, los expertos advierten contra exagerar este desarrollo. Si bien un sistema de IA que resuelva de manera confiable problemas matemáticos sería un logro impresionante, no necesariamente señala la llegada de una IA superinteligente o AGI. La investigación actual de IA, incluidos los esfuerzos de OpenAI, se ha centrado en problemas elementales, con diversos grados de éxito en tareas más complejas.

Las posibles aplicaciones de avances como Q* son vastas, desde tutorías personalizadas hasta asistencia en investigación científica e ingeniería. Sin embargo, también es importante manejar las expectativas y reconocer las limitaciones y preocupaciones de seguridad asociadas con tales avances. Las preocupaciones sobre los riesgos existenciales que plantea la IA, una preocupación fundamental de OpenAI, siguen siendo pertinentes, especialmente a medida que los sistemas de IA comienzan a interactuar más con el mundo real.

El Movimiento de LLM de Código Abierto

Para impulsar la investigación de código abierto de LLM, Meta lanzó los modelos de la serie Llama, desencadenando una ola de nuevos avances basados en Llama. Esto incluye modelos ajustados con datos de instrucción, como Alpaca, Vicuna, Lima y WizardLM. La investigación también se está ramificando para mejorar las capacidades de los agentes, el razonamiento lógico y la modelización de contextos largos dentro del marco basado en Llama.

Además, hay una tendencia creciente de desarrollar potentes LLM desde cero, con proyectos como MPT, Falcon, XGen, Phi, Baichuan, Mistral, Grok y Yi. Estos esfuerzos reflejan un compromiso de democratizar las capacidades de los LLM de código cerrado, haciendo que las herramientas de IA avanzada sean más accesibles y eficientes.

El impacto de ChatGPT y los modelos de código abierto en la atención médica

Estamos viendo un futuro en el que los LLMs ayudan en la toma de notas clínicas, el llenado de formularios para reembolsos y el apoyo a los médicos en el diagnóstico y la planificación del tratamiento. Esto ha captado la atención tanto de los gigantes tecnológicos como de las instituciones de atención médica.

Las discusiones de Microsoft con Epic, un destacado proveedor de software de registros médicos electrónicos, señalan la integración de LLMs en la atención médica. Ya se están implementando iniciativas en UC San Diego Health y el Centro Médico de la Universidad de Stanford. De manera similar, las asociaciones de Google con Mayo Clinic y el lanzamiento de HealthScribe por parte de Amazon Web Services, un servicio de documentación clínica basado en IA, marcan avances significativos en esta dirección.

Sin embargo, estas implementaciones rápidas plantean preocupaciones sobre ceder el control de la medicina a intereses corporativos. La naturaleza propietaria de estos LLMs hace que sea difícil evaluarlos. Su posible modificación o discontinuación por motivos de rentabilidad podría comprometer la atención, privacidad y seguridad del paciente.

La necesidad urgente es adoptar un enfoque abierto e inclusivo para el desarrollo de LLM en la atención médica. Las instituciones de atención médica, los investigadores, los médicos y los pacientes deben colaborar globalmente para construir LLMs de código abierto para la atención médica. Este enfoque, similar a la Trillion Parameter Consortium, permitiría el uso conjunto de recursos computacionales, financieros y expertos.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Transformando los servicios BFSI utilizando el poder de las características generativas de la IA en GCP

- Inaugurando la ciencia de datos en América Latina con Favio Vázquez

- ‘Eres un Experto’ No es tan mágica como crees la sugerencia de IA

- Conoce a Gemini La respuesta de Google a ChatGPT

- Poder de los Modelos de Lenguaje de IA para Desarrolladores de React Una Guía Completa

- Principales documentos LLM importantes de la semana del 27/11 al 03/12

- Conoce a Ego-Exo4D Un conjunto de datos y una suite de referencia esenciales para apoyar la investigación sobre aprendizaje de video y percepción multimodal.