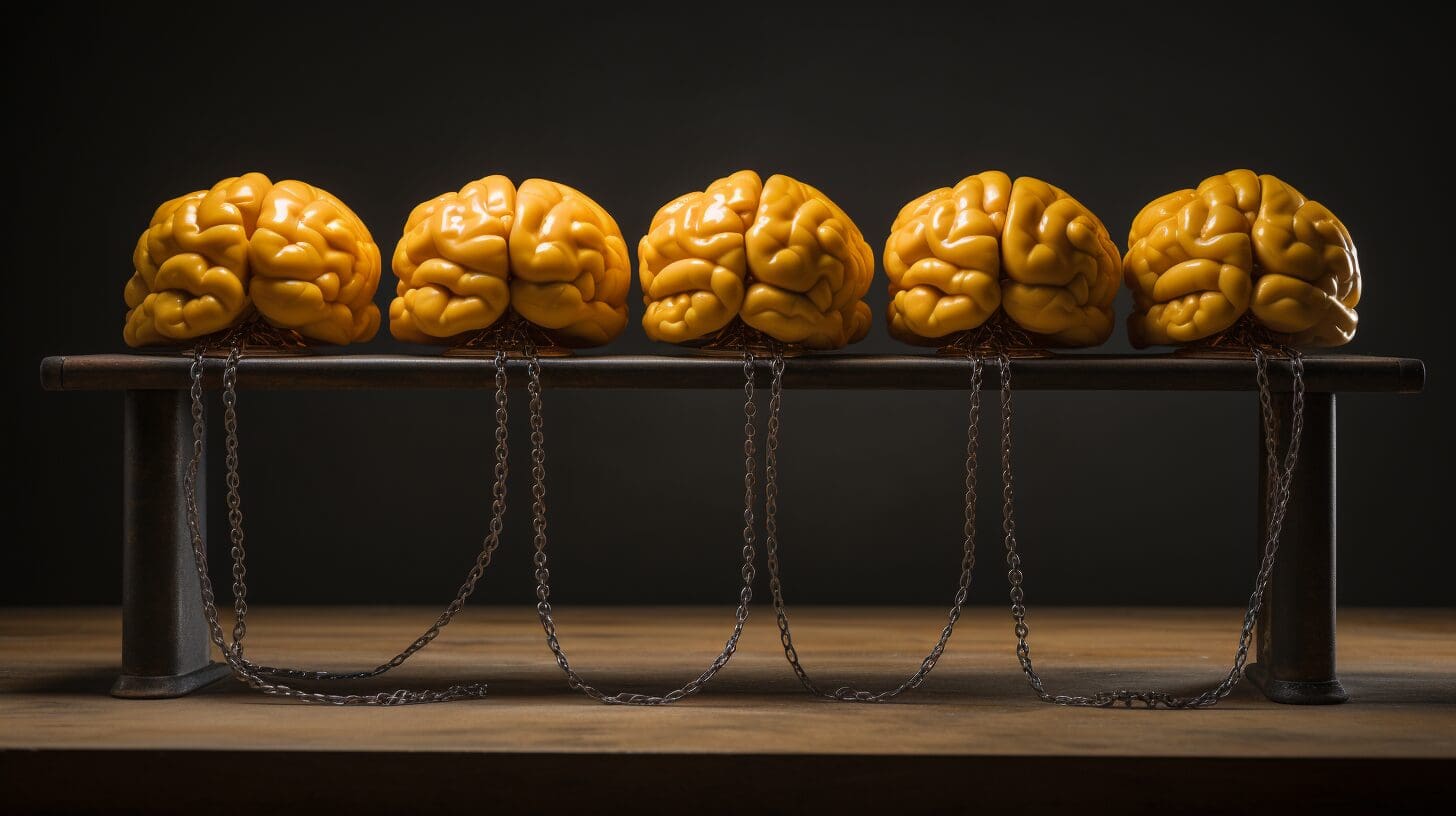

Automatizando la Cadena del Pensamiento Cómo la IA puede impulsarse a sí misma a razonar

Automatizando la Cadena del Pensamiento Cómo la IA puede razonar por sí misma

Puntos clave

- La activación de la cadena de pensamiento (CoT) mejora el razonamiento de LM proporcionando ejemplos paso a paso

- La creación manual de demostraciones CoT requiere un esfuerzo humano no trivial

- Este artículo explora la generación automatizada de demostraciones CoT mediante el propio LM

- El método Auto-CoT propuesto agrupa preguntas y luego selecciona diversas para la auto-activación

- Los experimentos muestran que Auto-CoT coincide con CoT creado manualmente, sin intervención humana

- Exploración de datos impulsada por ChatGPT desbloquea conocimientos ocultos en tu conjunto de datos

- 6 Pasos para Proteger tu Privacidad al Usar Herramientas de IA Generativa

- Investigadores de ETH Zurich y Microsoft proponen X-Avatar un modelo de avatar humano implícito animable capaz de capturar la postura del cuerpo humano y expresiones faciales.

Introducción

El artículo “Activación automática de la cadena de pensamiento en modelos de lenguaje grandes” explora formas automatizadas de crear consignas efectivas de “cadena de pensamiento” (CoT) para modelos de lenguaje grandes (LLM) como GPT-4. La activación de CoT implica mostrar al LLM ejemplos que demuestran cadenas de razonamiento paso a paso que van desde una pregunta hasta una respuesta final. Esto mejora el rendimiento en tareas de razonamiento complejas.

Discusión

Los mejores resultados de activación de CoT, sin embargo, actualmente requieren que los humanos creen manualmente demostraciones, con preguntas hechas a medida y pasos de razonamiento detallados adaptados a cada tarea. Los autores proponen eliminar este esfuerzo manual haciendo que el LLM genere automáticamente sus propias demostraciones CoT para la activación. Su método clave, llamado Auto-CoT, funciona primero agrupando las preguntas de una tarea dada según su similitud semántica. Luego, Auto-CoT selecciona un conjunto diverso de preguntas que abarcan diferentes grupos. Para cada pregunta seleccionada, Auto-CoT utiliza el propio LLM en modo de cero disparo para producir una cadena de razonamiento desde la pregunta hasta una respuesta. Aplica heurísticas simples para seleccionar cadenas basadas en longitud y simplicidad.

Los autores realizan experimentos evaluando Auto-CoT en 10 conjuntos de datos de razonamiento que abarcan problemas de aritmética, sentido común y lógica simbólica. Los resultados muestran que Auto-CoT coincide o supera el rendimiento de CoT basado en demostraciones creadas manualmente, sin requerir ningún esfuerzo humano para diseñar demostraciones. Una idea clave es que el uso de muestreo basado en diversidad en lugar de recuperación basada en similitud para seleccionar las preguntas de activación mitiga el impacto de las demostraciones imperfectas generadas por el razonamiento de cero disparo del LLM. Auto-CoT también supera sustancialmente a los baselines como la recuperación de preguntas similares o el muestreo aleatorio para las demostraciones.

En general, el trabajo proporciona pruebas sólidas de que los LLM pueden activarse a sí mismos para demostrar un razonamiento complejo de múltiples pasos. Auto-CoT esencialmente compone un LLM que genera un conjunto diverso de ejemplos de CoT, con otro LLM que utiliza esos ejemplos para la inferencia. Los autores sugieren que este enfoque de auto-activación podría extender significativamente las técnicas de activación y mejorar las capacidades de aprendizaje de pocos disparos de los LLM en tareas de razonamiento complejas. Las limitaciones incluyen posibles costos computacionales y problemas para escalar a problemas más no restringidos. Pero la capacidad de automatizar la activación reduce el esfuerzo humano y las necesidades de personalización.

Preguntas y respuestas de investigación

¿Cómo se compara Auto-CoT con otros métodos que automatizan la creación de consignas, como la activación aumentada por recuperación?

La activación aumentada por recuperación recupera ejemplos de datos relacionados para usar en la activación, en lugar de hacer que el LLM genere demostraciones. Una diferencia clave es que Auto-CoT no requiere un conjunto de datos de ejemplos etiquetados y en cambio se basa en el razonamiento de cero disparo del LLM. La recuperación puede ser más eficiente en cuanto a la muestra, pero requiere la recopilación de datos. Auto-CoT es completamente automatizado pero puede sufrir de demostraciones imperfectas.

¿Se podría aplicar Auto-CoT a tareas de generación de lenguaje natural más allá del razonamiento lógico?

El enfoque de agrupación y auto-activación parece prometedor para tareas textuales menos estructuradas donde la coherencia es importante. Por ejemplo, Auto-CoT podría proporcionar ejemplos de planificación de escritura para escritura creativa o ilustraciones de diálogo para bots conversacionales. Los desafíos clave serían definir métodos de agrupación apropiados y entrenar la generación de cero disparo del LLM para demostraciones de alta calidad.

¿Qué hay de innovador en esta investigación?

La innovación clave es utilizar el propio LLM para generar demostraciones para la activación, en lugar de confiar en la creación manual. Esto permite que la activación sea más automatizada y adaptable a la tarea. La agrupación para seleccionar preguntas diversas para la auto-activación también es innovadora.

¿Cuáles son las implicaciones más amplias de esta investigación?

Esta investigación podría reducir significativamente el esfuerzo humano y la experiencia necesarios para diseñar consignas efectivas. Podría permitir que los LLM aprendan nuevas tareas más rápidamente y con menos datos, mejorando sus capacidades de aprendizaje de pocos disparos. El enfoque de auto-activación podría aplicarse para extender técnicas de activación como el aprendizaje en contexto.

¿Cuáles son algunos problemas potenciales o descuidos con esta investigación tal como se presenta, si los hay?

Un problema potencial es que Auto-CoT se basa en la agrupación de preguntas según características de similitud de Sentence-BERT. El rendimiento podría verse afectado en tareas donde la similitud semántica no se alinea bien con la similitud de razonamiento. El enfoque también podría incurrir en mayores costos de cálculo que el prompting estándar.

¿Cuáles son los siguientes pasos lógicos de investigación a partir de esta investigación?

Los siguientes pasos importantes incluyen explorar cómo Auto-CoT se escala a tareas de razonamiento más complejas y abiertas, integrándolo con la recuperación de fuentes de conocimiento externas, y estudiar si el enfoque se puede aprender de manera más eficiente en cuanto a la muestra a través del meta-aprendizaje en lugar de depender únicamente de un LLM pre-entrenado. El análisis de la interacción entre el número de grupos, el tamaño de la muestra y el rendimiento también es una pregunta abierta.

Conclusiones

- Auto-CoT reduce la necesidad de demostraciones hechas a mano para promover LMs

- El auto-promt con Auto-CoT compone un LM que genera ejemplos diversos y otro que infiere

- La diversidad en la muestra de preguntas es clave para superar cadenas de razonamiento imperfectas en cero-shot

- El enfoque podría ampliar las técnicas de prompting y hacer que los LMs sean mejores para el aprendizaje en pocos ejemplos

- Auto-CoT demuestra la promesa de automatizar el prompting para reducir el esfuerzo humano

- Los siguientes pasos incluyen escalar Auto-CoT a tareas de razonamiento más complejas y LMs más grandes

Matthew Mayo (@mattmayo13) es un científico de datos y el editor en jefe de VoAGI, el recurso en línea fundamental de Ciencia de Datos y Aprendizaje Automático. Sus intereses se centran en el procesamiento del lenguaje natural, el diseño y la optimización de algoritmos, el aprendizaje no supervisado, las redes neuronales y los enfoques automatizados para el aprendizaje automático. Matthew tiene un título de maestría en ciencias de la computación y un diploma de posgrado en minería de datos. Puede contactarse con él en editor1 en VoAGI[punto]com.

We will continue to update Zepes; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- Herramientas de IA principales para emprendedores 2023

- La carta de presentación generada por IA de un graduado del IIT hace reír a todos

- Un nuevo estudio de investigación de IA de DeepMind propone dos codificaciones posicionales direccionales y estructurales para grafos dirigidos

- ChatGPT investigado por la Comisión Federal de Comercio por posibles daños

- Conoce Objaverse-XL Un conjunto de datos abierto de más de 10 millones de objetos en 3D.

- Puedes conservar tu trabajo, pero no será el mismo trabajo

- ¡No, no, no lo pongamos ahí! Este método de IA puede realizar edición de diseño continua con modelos de difusión