Learn more about Search Results transformers

- You may be interested

- Cómo ganar dinero con X / Twitter

- Evaluar modelos de lenguaje grandes en ...

- Microsoft presenta Azure ChatGPT una ve...

- Recuperación Mejorada de Generación con...

- Retro-ingeniería de un esquema de base ...

- Nueva herramienta para construir y repa...

- Búsqueda autónoma de información visual...

- Analógico y Digital Lo Mejor de Ambos M...

- Dominar la Segmentación de Clientes uti...

- Esta investigación de IA introduce Flas...

- Es hora de que los desarrolladores y la...

- Evaluando la síntesis del habla en vari...

- Evita estos 3 costosos errores y salva ...

- V-Net, el hermano mayor de U-Net en la ...

- Los investigadores simplifican el cambi...

Esta investigación de IA revela el LSS Transformer Un enfoque revolucionario de IA para el entrenamiento eficiente de secuencias largas en los Transformers.

Una nueva investigación de IA ha presentado el Long Short-Sequence Transformer (LSS Transformer), un método eficiente de entrenamiento distribuido diseñado para modelos de transformadores…

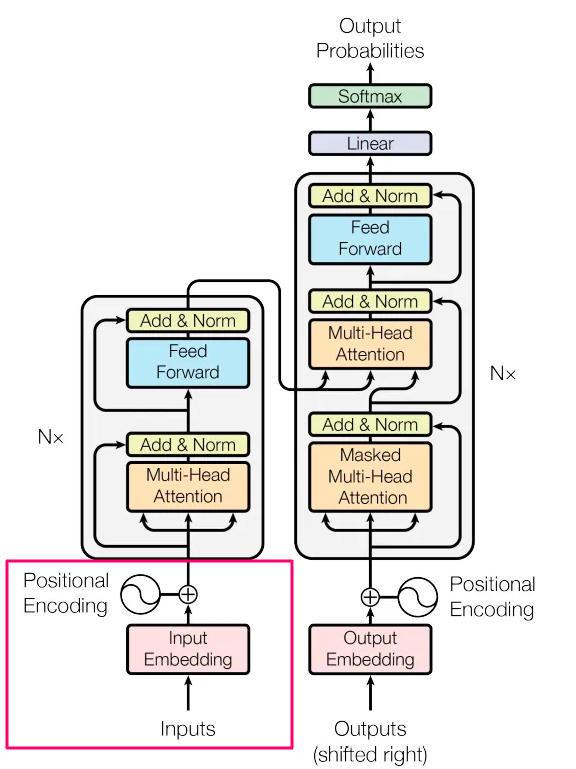

El ABC de los Transformers Todo lo que necesitas saber

Probablemente ya hayas oído hablar de Transformers, y todo el mundo habla de ello, ¿así que por qué escribir un nuevo artículo al respecto?…

Comparando técnicas de procesamiento de lenguaje natural RNNs, Transformers, BERT

RNN, Transformers y BERT son técnicas populares de PNL con compensaciones en modelado de secuencias, paralelización y preentrenamiento para tareas derivadas.

De-codificado Transformers explicados en un lenguaje sencillo

Sin código, matemáticas o mención de claves, consultas y valores.

Segmentación semántica de imágenes utilizando Transformers de predicción densa

Introducción Este artículo analizará una técnica de visión por computadora llamada Segmentación Semántica de Imágenes. Aunque esto suena complejo, lo vamos a desglosar paso…

RELU vs. Softmax en Vision Transformers ¿Importa la longitud de la secuencia? Ideas de un artículo de investigación de Google DeepMind

Hoy en día, una arquitectura común de aprendizaje automático es la arquitectura de transformer. Una de las partes principales del transformer, la atención, tiene…

¿Cuál es la conexión entre los Transformers y las Máquinas de Vectores de Soporte? Revelando el sesgo implícito y la geometría de optimización en las arquitecturas de los Transformers

El procesamiento del lenguaje natural (NLP) ha revolucionado debido a la auto-atención, el elemento clave del diseño del transformer, que permite al modelo reconocer…

Desbloqueando la eficiencia en Transformers de Visión Cómo los MoEs de Visión Móvil Escasos superan a sus contrapartes densas en aplicaciones con recursos limitados

Una arquitectura de red neuronal llamada Mixture-of-Experts (MoE) combina las predicciones de varias redes neuronales expertas. Los modelos MoE lidian con trabajos complicados en…

Visión general de los esquemas de cuantización admitidos de forma nativa en 🤗 Transformers

Nuestro objetivo es brindar una descripción clara de los pros y los contras de cada esquema de cuantificación admitido en transformers para ayudarlo a…

¿Pueden los Transformers aprender a estrategizar?

Aunque la mayoría de los juegos de mesa se basan en el uso de redes neuronales convolucionales u otras arquitecturas inspiradas en la geometría,…

Transformando la investigación en Catalyst Conoce a CatBERTa, un modelo de IA basado en Transformers diseñado para la predicción de energía utilizando entradas de texto

La investigación de catalizadores químicos es un campo dinámico donde siempre se buscan soluciones nuevas y duraderas. La base de la industria contemporánea, los…

Explicando la atención en Transformers [Desde el punto de vista del codificador]

En este artículo, nos sumergiremos profundamente en el concepto de atención en las redes Transformer, particularmente desde la perspectiva del codificador. Cubriremos los siguientes…

Investigadores de la Universidad de Wisconsin-Madison proponen Eventful Transformers un enfoque rentable para el reconocimiento de video con una pérdida mínima de precisión.

Los Transformers originalmente diseñados para el modelado del lenguaje han sido investigados recientemente como una posible arquitectura para tareas relacionadas con la visión. Con…

Haciendo LLMs más ligeros con AutoGPTQ y transformers

Los grandes modelos de lenguaje han demostrado capacidades notables en comprender y generar texto similar al humano, revolucionando aplicaciones en diversos campos. Sin embargo,…

Simplificando Transformers NLP de última generación utilizando palabras que comprendes – parte 2 – Entrada

Dragón sale de huevos, los bebés saltan de vientres, el texto generado por IA comienza desde las entradas. Todos tenemos que empezar en algún…

Investigadores de Google DeepMind proponen 6 transformaciones componibles para aumentar de forma incremental el tamaño de las redes neuronales basadas en Transformers mientras se preserva la funcionalidad.

Las redes neuronales basadas en transformadores han recibido mucha atención últimamente porque funcionan bien. La traducción automática, la creación de texto y la respuesta…

Swin Transformers | Tareas modernas de visión por computadora

Introducción El Swin Transformer es una innovación significativa en el campo de los transformadores de visión. El rendimiento excepcional de los transformadores se ha…

Train self-supervised vision transformers on overhead imagery with Amazon SageMaker’ Entrenar transformadores de visión auto-supervisados en imágenes aéreas con Amazon SageMaker.

En esta publicación, demostramos cómo entrenar transformadores de visión auto-supervisados en imágenes aéreas utilizando Amazon SageMaker. Los viajeros colaboraron con el Laboratorio de Soluciones…

Extracción de datos de documentos sin OCR con Transformers (2/2)

¿Qué tan bien comprenden los modelos transformadores Donut y Pix2Struct los documentos? Te muestro cómo entrenarlos y comparar sus resultados para la tarea de…

Abriendo en Canal la Biblioteca de Transformers de Hugging Face

Este es el tercer artículo de una serie sobre el uso de modelos de lenguaje grandes (LLMs) en la práctica. Aquí daré una guía…

Análisis de acordes de jazz con Transformers

En este artículo, resumo parte de mi artículo de investigación Predicción de jerarquías musicales con un decodificador neuronal basado en gráficos que presenta un…

Guía introductoria completa sobre el reconocimiento de voz a texto con Transformers

Introducción Todos lidiamos con datos de audio mucho más de lo que nos damos cuenta. El mundo está lleno de datos de audio y…

Herramientas y Agentes de HuggingFace Transformers Práctica

La versión v4.29.0 de Transformers, basada en el concepto de herramientas y agentes, proporciona una API de lenguaje natural sobre transformers. ¿Cómo usarlos? Sumergámonos…

Cómo entrenar un nuevo modelo de lenguaje desde cero utilizando Transformers y Tokenizers

En los últimos meses, hemos realizado varias mejoras en nuestras bibliotecas de transformers y tokenizers, con el objetivo de facilitar más que nunca el…

Cómo generar texto utilizando diferentes métodos de decodificación para la generación de lenguaje con Transformers

Introducción En los últimos años, ha habido un creciente interés en la generación de lenguaje de forma abierta gracias al surgimiento de modelos de…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.