Learn more about Search Results función SoftMax

- You may be interested

- Mejorando tus LLMs con RLHF en Amazon S...

- Almacenes de datos vs. Lagos de datos v...

- OpenAI presenta DALL-E 3 y los usuarios...

- Uso de Computadoras Analógicas en Intel...

- Acortando la brecha entre la IA y la co...

- IA al descubierto Bloggers y escritores...

- Ajuste fino de un modelo Llama-2 7B par...

- Métodos de Monte Carlo

- Separación de fuentes de música mediant...

- Las 10 mejores formas de utilizar la in...

- Sabemos que las LLM pueden utilizar her...

- Google AI presenta MetNet-3 Revoluciona...

- Buenos ingenieros, malos ingenieros y i...

- ¿Qué significa implementar un modelo de...

- Llama-2, GPT-4 o Claude-2; ¿Cuál es el ...

Google Maps se ha mejorado con funciones de IA

A finales de octubre, Google anunció en un blog cinco nuevas funciones impulsadas por inteligencia artificial que mejoran la popular aplicación de mapas de…

Regresión Softmax completamente explicada para etiqueta de multiclase con Python

En la regresión logística, tratamos con clases binarias, es decir, dos clases en las columnas de salida. Sin embargo, en el mundo real, obtenemos…

RELU vs. Softmax en Vision Transformers ¿Importa la longitud de la secuencia? Ideas de un artículo de investigación de Google DeepMind

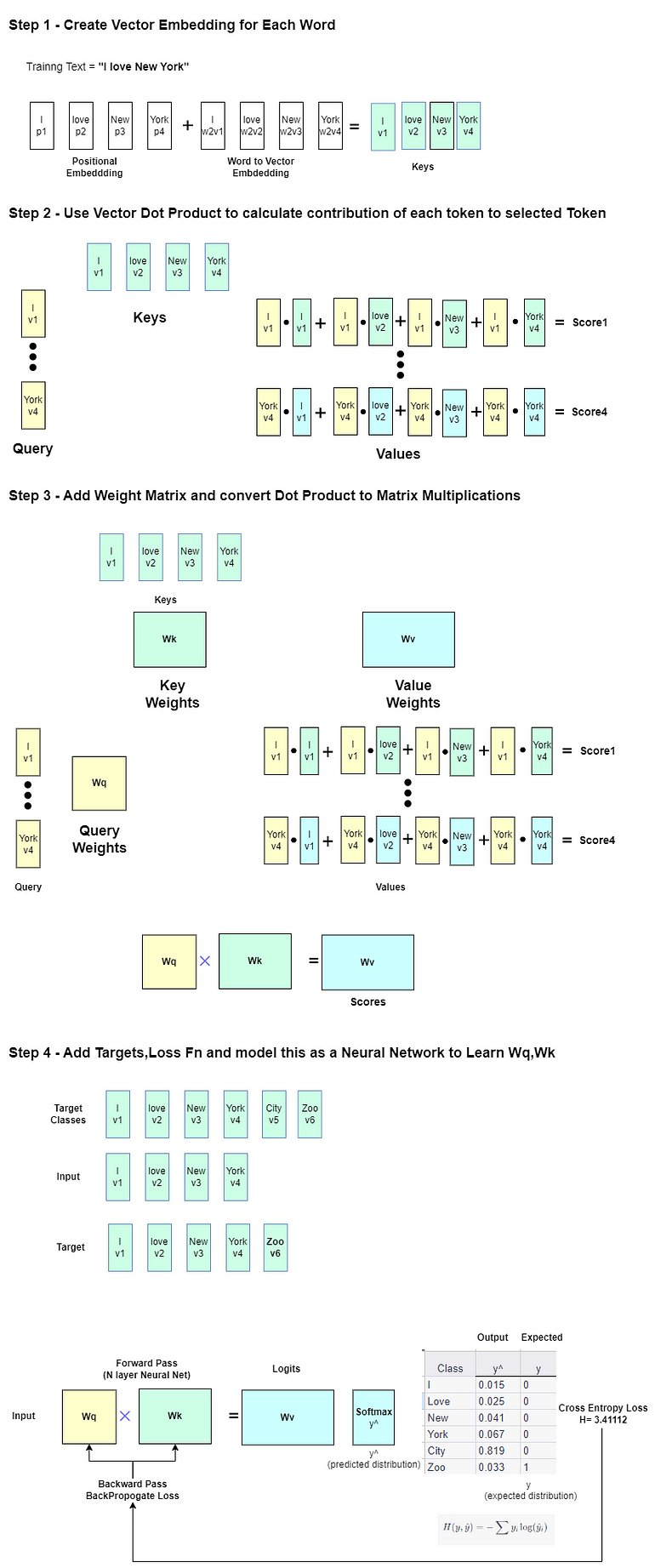

Hoy en día, una arquitectura común de aprendizaje automático es la arquitectura de transformer. Una de las partes principales del transformer, la atención, tiene…

Construyendo Funciones de Activación para Redes Profundas

Un componente básico de una red neuronal profunda es la función de activación (AF) - una función no lineal que da forma a la…

Cómo funciona GPT una explicación metafórica de Clave, Valor, Consulta en Atención, utilizando un cuento de pociones.

El esqueleto de ChatGPT es el modelo GPT, el cual está construido utilizando la arquitectura Transformer. El esqueleto de Transformer es el mecanismo de…

Revelando los entresijos Un análisis a fondo del mecanismo de atención de BERT

Introducción BERT, abreviatura de Bidirectional Encoder Representations from Transformers, es un sistema que aprovecha el modelo de transformador y el entrenamiento previo no supervisado…

Desbloqueando el poder del Big Data El fascinante mundo del Aprendizaje de Grafos

Las grandes empresas generan y recopilan grandes cantidades de datos, como ejemplo el 90% de estos datos se han creado en los últimos años.…

Conoce circ2CBA un modelo novedoso de aprendizaje profundo que revoluciona la predicción de los sitios de unión circRNA-RBP

En un reciente avance, un equipo de investigadores de China ha presentado un modelo de aprendizaje profundo, llamado circ2CBA, que promete revolucionar la predicción…

Casos de uso del clasificador de dos cabezas

Hablemos de algunos casos reales de tareas de visión por computadora. A simple vista, el problema de clasificación es tan sencillo como parece, y…

El ABC de los Transformers Todo lo que necesitas saber

Probablemente ya hayas oído hablar de Transformers, y todo el mundo habla de ello, ¿así que por qué escribir un nuevo artículo al respecto?…

De-codificado Transformers explicados en un lenguaje sencillo

Sin código, matemáticas o mención de claves, consultas y valores.

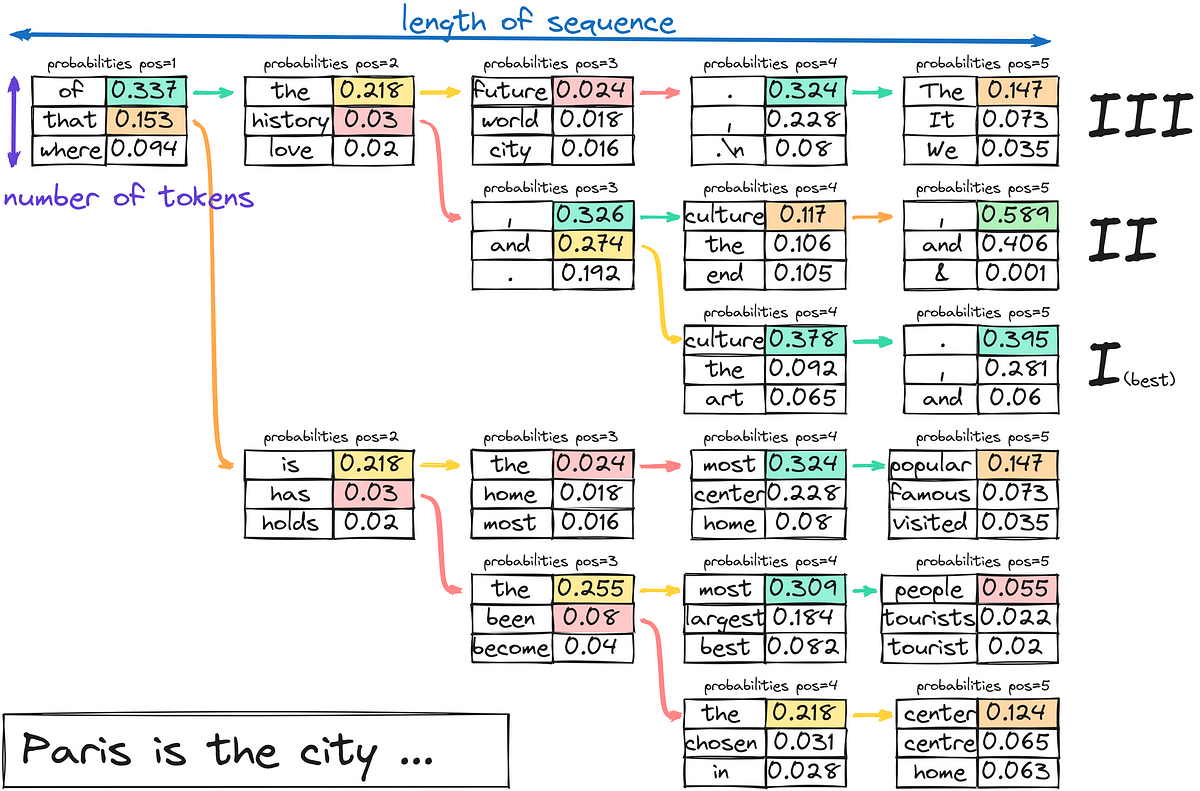

¿Cómo genera texto un LLM?

Hoy nos concentraremos en el tercer paso descifrar y generar texto. Si estás interesado en los dos primeros pasos, comenta abajo. También consideraré cubrir…

Explorando Grandes Modelos de Lenguaje – Parte 1

Este artículo está escrito principalmente para el autoestudio. Por lo tanto, abarca ampliamente y también profundiza. Siéntete libre de saltar ciertas secciones según tus…

Una Introducción Suave al Aprendizaje Profundo Bayesiano

¡Bienvenido al emocionante mundo de la Programación Probabilística! Este artículo es una introducción al Aprendizaje Profundo Bayesiano y las Redes Neuronales Profundas para principiantes.

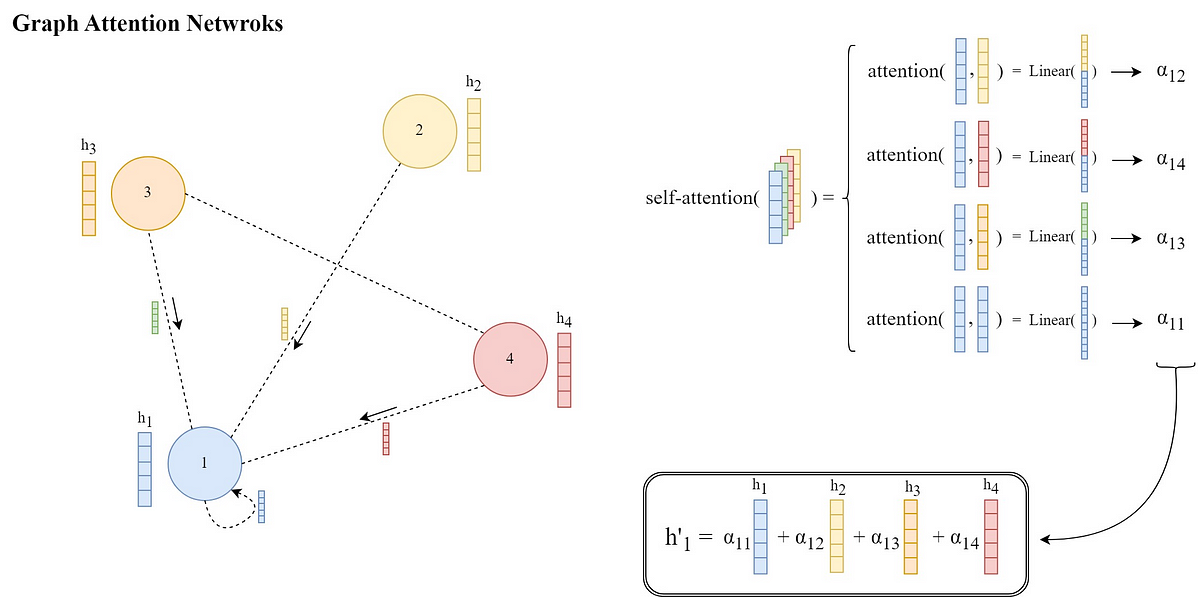

Explicación del artículo de las Redes de Atención en Grafos con ilustración e implementación en PyTorch

Las redes neuronales gráficas (GNN) son una poderosa clase de redes neuronales que operan en datos estructurados en forma de grafo. Aprenden representaciones de…

El Reformador – Empujando los límites del modelado de lenguaje

Cómo el Reformer utiliza menos de 8GB de RAM para entrenar en secuencias de medio millón de tokens El modelo Reformer, presentado por Kitaev,…

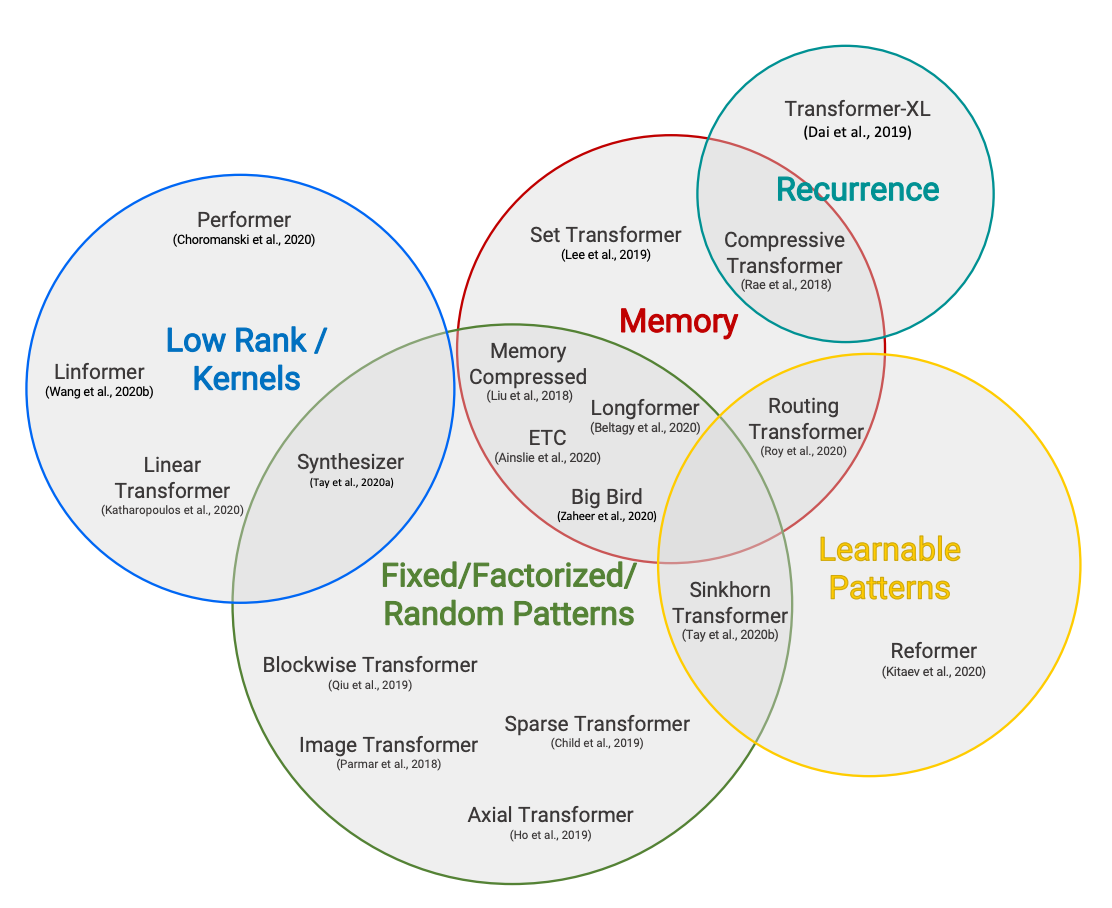

Hugging Face Reads, Feb. 2021 – Transformers de largo alcance

Taxonomía de Transformers eficientes de Efficient Transformers: una encuesta de Tay et al. Coescrito por Teven Le Scao, Patrick Von Platen, Suraj Patil, Yacine…

De descifrar el mecanismo de atención hacia una solución de margen máximo en los modelos de transformador

El mecanismo de atención ha desempeñado un papel importante en el procesamiento del lenguaje natural y en los grandes modelos de lenguaje. El mecanismo…

Técnicas avanzadas de RAG una visión general ilustrada

Dado que el objetivo del artículo es hacer un resumen y explicación de los algoritmos y técnicas RAG disponibles, no entraré en detalles de…

¡Vamos a explorar el aprendizaje por transferencia…

Hay muchas definiciones que describen el aprendizaje por transferencia. Básicamente, implica utilizar el conocimiento de modelos pre-entrenados para resolver nuevos problemas. Hay numerosos beneficios…

Visualizando Modelos en Profundidad Una Guía para Grad-CAM en Aprendizaje Profundo

Introducción El mapeo de activación de clase ponderado por gradiente es una técnica utilizada en el aprendizaje profundo para visualizar y comprender las decisiones…

Una guía completa sobre la convolución atroz en las redes neuronales convolucionales

Introducción En el ámbito de la visión por computadora, las Redes Neuronales Convolucionales (CNNs) han redefinido el panorama del análisis y comprensión de imágenes.…

Permite un entrenamiento más rápido con la biblioteca de paralelismo de datos de Amazon SageMaker

El entrenamiento de modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés) se ha vuelto cada vez más popular en el…

Grandes modelos de lenguaje DeBERTa – BERT mejorado con decodificación y atención desentrelazada

En los últimos años, BERT se ha convertido en la herramienta número uno en muchas tareas de procesamiento de lenguaje natural. Su destacada capacidad…

Superpotencia el entrenamiento de tus modelos de aprendizaje profundo

¿Te has encontrado con situaciones en las que es fácil obtener un impulso inicial en precisión pero una vez que llegas al 90%, tienes…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.