Learn more about Search Results biblioteca transformers

- You may be interested

- Grok Chatbot de IA de la xAI de Elon Musk

- 20+ Mejores Herramientas de IA Para Sta...

- 10 Mejores Herramientas Generadoras de ...

- Construye una Red Neuronal Convoluciona...

- MLOps para la inferencia por lotes con ...

- Cómo crear un plan de estudio autodidac...

- Difusión Estable Dominando el Arte del ...

- William Wu, Fundador y CEO de Artisse &...

- 🧨 Acelerando la difusión estable de inf...

- IBM y NASA se unen para crear Earth Sci...

- Spotify adopta la IA desde listas de re...

- Subtítulos visuales Usando modelos de l...

- ¿Tu conjunto de datos tiene valores fal...

- Synapse CoR ChatGPT con un Giro Revoluc...

- ¿Qué es la Inteligencia Artificial Estr...

Abriendo en Canal la Biblioteca de Transformers de Hugging Face

Este es el tercer artículo de una serie sobre el uso de modelos de lenguaje grandes (LLMs) en la práctica. Aquí daré una guía…

Top 5 bibliotecas de IA generativa para usar en 2024

Introducción En el siempre cambiante mundo de la tecnología, la Inteligencia Artificial (IA) ha surgido como una fuerza transformadora. Desde sus humildes comienzos en…

ExLlamaV2 La biblioteca más rápida para ejecutar LLMs

ExLlamaV2 es una biblioteca diseñada para exprimir aún más rendimiento de GPTQ. Gracias a nuevos kernels, está optimizada para (increíblemente) rápidas inferencias.

Salvando las bibliotecas digitales y el Internet Archive

Una batalla sobre la verdad y quién tiene acceso a ella en la era digital.

Segmentación semántica de imágenes utilizando Transformers de predicción densa

Introducción Este artículo analizará una técnica de visión por computadora llamada Segmentación Semántica de Imágenes. Aunque esto suena complejo, lo vamos a desglosar paso…

Conoce vLLM una biblioteca de aprendizaje automático de código abierto para una inferencia y servicio LLM rápidos

Los grandes modelos de lenguaje (LLMs, por sus siglas en inglés) tienen un impacto cada vez mayor en cómo cambian nuestras vidas diarias y…

Visión general de los esquemas de cuantización admitidos de forma nativa en 🤗 Transformers

Nuestro objetivo es brindar una descripción clara de los pros y los contras de cada esquema de cuantificación admitido en transformers para ayudarlo a…

Haciendo LLMs más ligeros con AutoGPTQ y transformers

Los grandes modelos de lenguaje han demostrado capacidades notables en comprender y generar texto similar al humano, revolucionando aplicaciones en diversos campos. Sin embargo,…

Swin Transformers | Tareas modernas de visión por computadora

Introducción El Swin Transformer es una innovación significativa en el campo de los transformadores de visión. El rendimiento excepcional de los transformadores se ha…

Train self-supervised vision transformers on overhead imagery with Amazon SageMaker’ Entrenar transformadores de visión auto-supervisados en imágenes aéreas con Amazon SageMaker.

En esta publicación, demostramos cómo entrenar transformadores de visión auto-supervisados en imágenes aéreas utilizando Amazon SageMaker. Los viajeros colaboraron con el Laboratorio de Soluciones…

Conoce GPTCache una biblioteca para desarrollar una caché semántica de consultas LLM.

ChatGPT y los modelos de lenguaje grandes (LLMs) son extremadamente flexibles, lo que permite la creación de numerosos programas. Sin embargo, los costos asociados…

Guía introductoria completa sobre el reconocimiento de voz a texto con Transformers

Introducción Todos lidiamos con datos de audio mucho más de lo que nos damos cuenta. El mundo está lleno de datos de audio y…

Cómo entrenar un nuevo modelo de lenguaje desde cero utilizando Transformers y Tokenizers

En los últimos meses, hemos realizado varias mejoras en nuestras bibliotecas de transformers y tokenizers, con el objetivo de facilitar más que nunca el…

Cómo generar texto utilizando diferentes métodos de decodificación para la generación de lenguaje con Transformers

Introducción En los últimos años, ha habido un creciente interés en la generación de lenguaje de forma abierta gracias al surgimiento de modelos de…

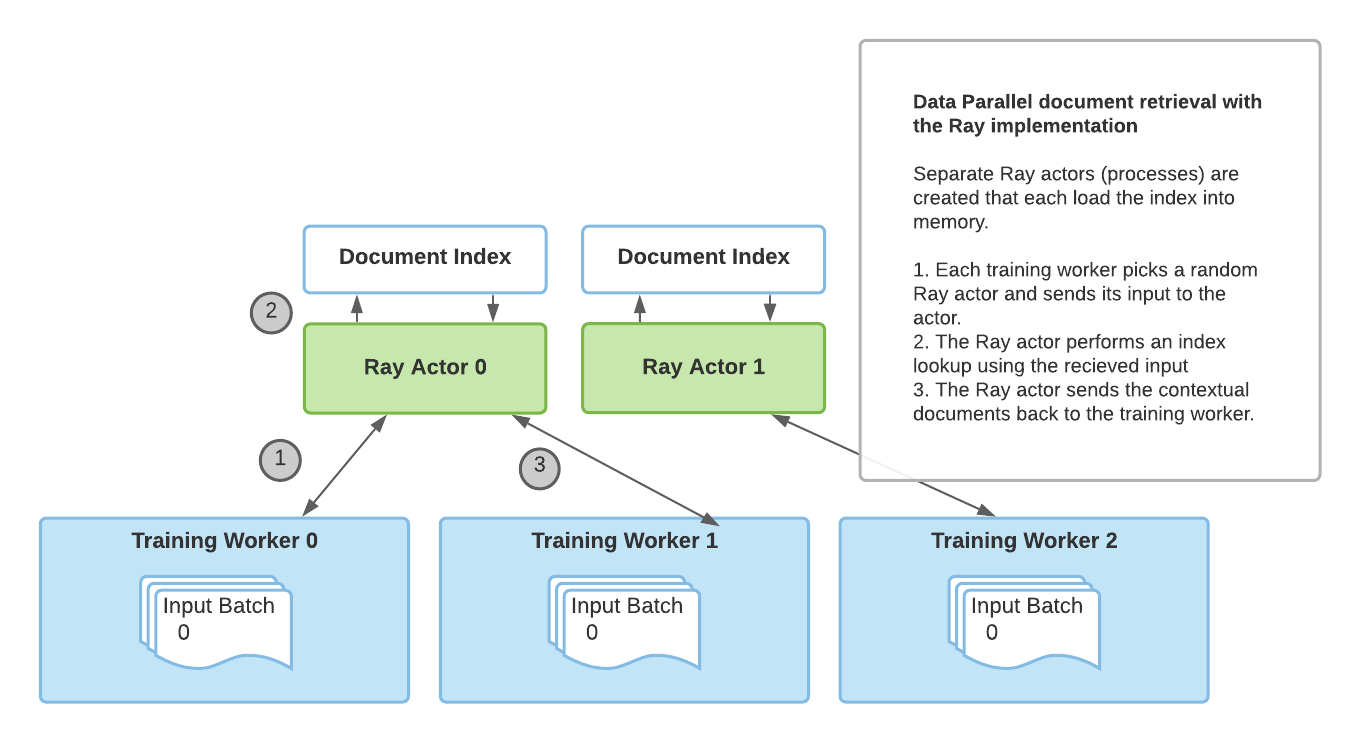

Recuperación Mejorada de Generación con Huggingface Transformers y Ray

Una publicación de blog invitada de Amog Kamsetty del equipo de Anyscale Huggingface Transformers recientemente agregó el modelo Retrieval Augmented Generation (RAG), una nueva…

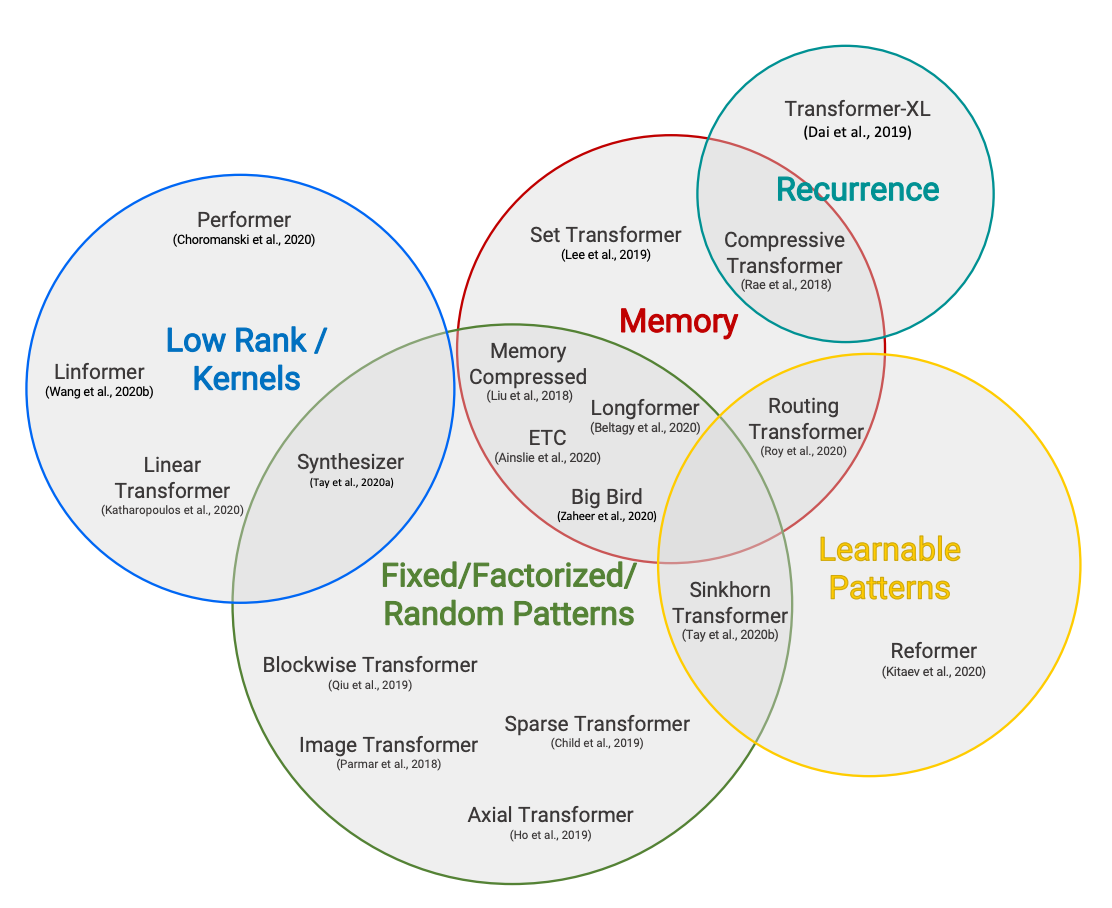

Hugging Face Reads, Feb. 2021 – Transformers de largo alcance

Taxonomía de Transformers eficientes de Efficient Transformers: una encuesta de Tay et al. Coescrito por Teven Le Scao, Patrick Von Platen, Suraj Patil, Yacine…

Entrenamiento distribuido Entrena BART/T5 para resumir utilizando 🤗 Transformers y Amazon SageMaker

En caso de que te lo hayas perdido: el 25 de marzo anunciamos una colaboración con Amazon SageMaker para facilitar la creación de modelos…

Hugging Face y Graphcore se asocian para Transformers optimizados para IPU

Hablando en la Cumbre de Hardware de IA 2021, Hugging Face anunció el lanzamiento de su nuevo Programa de Socios de Hardware, que incluye…

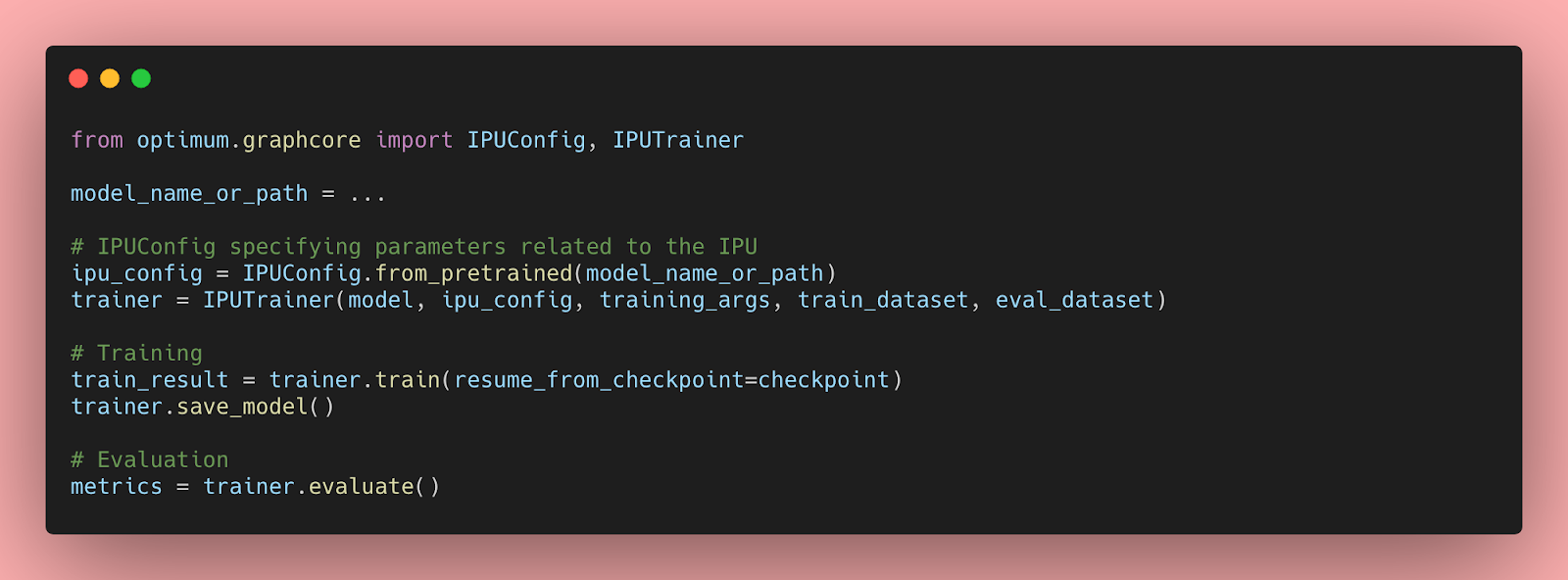

Empezando con Hugging Face Transformers para IPUs con Optimum

Los modelos Transformer han demostrado ser extremadamente eficientes en una amplia gama de tareas de aprendizaje automático, como el procesamiento de lenguaje natural, el…

Graphcore y Hugging Face lanzan una nueva línea de Transformers listos para IPU

Graphcore y Hugging Face han ampliado significativamente la gama de modalidades y tareas de Aprendizaje Automático disponibles en Hugging Face Optimum, una biblioteca de…

Entrenar y Ajustar Finalemente Modelos de Sentence Transformers

Revisa este tutorial con el Notebook Companion: Entrenar o ajustar un modelo de Sentence Transformers depende en gran medida de los datos disponibles y…

Inmersión Profunda Vision Transformers en Hugging Face Optimum Graphcore

Esta publicación del blog mostrará lo fácil que es ajustar modelos Transformer pre-entrenados para su conjunto de datos utilizando la biblioteca Hugging Face Optimum…

Pronóstico de series de tiempo probabilísticas con 🤗 Transformers

Introducción La predicción de series temporales es un problema científico y empresarial esencial y, como tal, también ha experimentado mucha innovación recientemente con el…

El Hub de Hugging Face para Galerías, Bibliotecas, Archivos y Museos

El Hub de Hugging Face para galerías, bibliotecas, archivos y museos ¿Qué es el Hub de Hugging Face? Hugging Face tiene como objetivo hacer…

Aprendiendo Transformers Code First Parte 1 – La Configuración

No sé tú, pero a veces mirar código es más fácil que leer papers. Cuando estaba trabajando en AdventureGPT, comencé leyendo el código fuente…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.